Il y a longtemps, au cours du dernier millénaire, les cartes vidéo avaient pour principal objectif de diffuser des images depuis la mémoire de l'ordinateur vers l'écran d'affichage. Parmi les fabricants de devaysov, il y avait une confusion et une vacillation violentes. Les jeux sont sortis avec leur propre jeu de pilotes pour une variété d'appareils (y compris les cartes vidéo). Puis il est venu: S3 Trio64 V +, qui est devenu une sorte de standard. Une copie presque complète - S3 Trio64 V2 - est sortie un peu plus tard. Et même plus tard est apparu S3 Virge, déjà équipé de 4 Mo de mémoire vidéo.

S3 Trio64 V2 avec 1 Mo de mémoire vidéo intégrée. Comme vous pouvez le voir, la carte vidéo peut être mise à niveau en ajoutant deux autres morceaux de SOJ DRAM EDO 512 Ko pour obtenir 2 Mo de mémoire.

1 Mo de mémoire vidéo suffit pour créer 3 tampons à une résolution d'écran de 640 × 480 pixels avec 256 couleurs. Heroes 3 nécessite 2 Mo, car la résolution était de 800 × 600 pixels et 65 536 couleurs.

Et tout était simple et clair: le processeur a triché et envoyé des données en mémoire, et la carte vidéo a transmis une image à l'écran. Et puis, dans le monde de l'informatique, littéralement éclater 3dfx avec sa technologie révolutionnaire Voodoo.

En toute justice, il faut dire qu'avant l'apparition des solutions de 3dfx, il y avait d'autres technologies. En particulier, la puce NV1 NV1 (qui a échoué).

Alors, qu'est-ce que le vaudou? C'était un soi-disant accélérateur 3D; un supplément pour la création de graphiques de haute qualité et haute performance. Une différence importante par rapport aux solutions modernes - cet accélérateur nécessitait la présence d’une carte vidéo conventionnelle (2D). Pour ses cartes vidéo, 3dfx a développé API - Glide - un outil pratique pour travailler avec Voodoo (pour les développeurs de jeux, en premier lieu).

![]()

Accélérateur de graphiques en trois dimensions basés sur 3Dfx Voodoo 2. C'est avec ce chipset que sont apparus technologie SLI: il était possible de connecter deux accélérateurs fonctionnant en tandem, tandis qu’un accélérateur traitait les lignes paires de l’autre, l’autre - plus étrange que ce qui était théoriquement le cas, deux fois plus performant

Conscients des avantages du nouveau marché, d'autres grands acteurs se sont joints à la lutte pour le consommateur en présentant leurs produits. Parmi les principaux, vous pouvez vous rappeler: 3D RAGE d'ATI, RIVA de NVIDIA, et également prononcé par le chuchotement respectueux Millennium de Matrox. Les huiles ont été déversées dans le feu et les développeurs logiciel, Dans un noble effort de normalisation (et, par conséquent, soulager le programmeur d'avoir au port votre code pour supporter les cartes de différents fabricants graphiques) fonctions de travail utilisées: Microsoft publie la Direct3D (partie de la bibliothèque DirectX), Silicon Graphics - OpenGL.

Peut-être que le dernier succès de 3dfx était Voodoo3. À cette époque cette carte graphique a été le plus productif en termes de graphisme 3D, mais il "est venu sur les talons" est venu RIVA TNT2 de NVIDIA. Afin de surpasser la concurrence, 3dfx a abandonné tous ses efforts pour développer un nouveau chipset. Et à ce moment-là, la GeForce 256 est sortie de NVIDIA, qui a en fait marqué le dernier clou de la "couverture de la confrontation". Le nouveau chipset de 3dfx était pas un concurrent à GeForce 256. retrouver encore la tête, il a été décidé de libérer un chipset configuration multiprocesseur mise à jour - VSA-100 - Voodoo5. Cependant, les temps étaient absents, et au moment de l'émergence de nouveaux accélérateurs basés sur des processeurs de 3dfx, les concurrents ont fait baisser les prix de leurs produits précédents, et bientôt introduit de nouvelles qui ne sont pas seulement moins cher mais aussi Voodoo plus productifs 5.

Pour l’ancien leader des accélérateurs 3D, tout était terminé. La plupart des actifs acquis NVIDIA, et a été suivie par l'éradication complète de tout ce qui a été associée à 3dfx, y compris les noms reconnaissables - Voodoo et API Glide. À partir de ce moment, il n'y avait en fait que deux fabricants de solutions haut débit pour les particuliers: ATI et NVIDIA.

En 2000, ATI a sorti un processeur culte d'une nouvelle génération - Radeon. La marque était si populaire qu'elle est toujours utilisée. Ce fut la première solution de processeur graphique, prend en charge DirectX 7. Un peu plus tôt entièrement NVIDIA a donné sa puce emblématique, en se fondant sur les deux lames Voodoo5, et qui a été le début d'une ligne de marque - GeForce. Les deux noms sont bien établis dans l'esprit des utilisateurs, et la question « Quelle est votre carte vidéo? » Il est possible d'entendre la réponse: « la Radeon » ou « la GeForce ».

À différents moments, le palmier du championnat est passé à l'une ou l'autre entreprise. Il est impossible de dire sans équivoque sur quel chipset la carte vidéo sera la meilleure: tout dépend des fabricants de cartes vidéo. Mais quittons les "guerres saintes" et parcourons brièvement les grandes lignes des décisions.

Donc, l'an 2000. ATI propose une gamme de « seventhousanders » - la Radeon 7000 et 7200, et un an plus tard - 7500, utilisés pour rendre la technologie plus de processus « délicat ». Les cartes supportaient DirectX 7.0 et OpenGL 1.3.

NVIDIA met GeForce 2 et GeForce 3 sur le marché, prenant en charge DirectX 7 et OpenGL 1.2.

La prochaine génération de cartes graphiques d'ATI «huit » (Radeon 8500 et représentée version light - Radeon 8500 LE) et "devyatitysyachniki" (Radeon 9000, 9100, 9200, 9250 avec les suffixes supplémentaires) supportant DirectX 8.1 et OpenGL 1.4. En 2002, il y a « devyatitysyachniki» régulière: Radeon 9500 - Radeon 9800 et le début de la série X: X300 - X850 et X1050 - X1950. API prise en charge - DirectX 9.0 b OpenGL 2.0.

NVIDIA GeForce4 MX publié dans les versions - pour les systèmes d'entrée de gamme, et Ti (titane) - pour les systèmes et moyennes gammes haut de gamme, supportant DirectX 8.1 et OpenGL 1.3. Avec la prochaine ligne - GeForce FX, il y a eu un petit scandale. La société a lancé des chipsets compatibles avec les shaders, la version 2.0a et a activement fait la promotion de cette technologie. Mais, comme le montrent les tests, les shaders ont fonctionné beaucoup plus lentement que le concurrent (ATI). Afin de sauver la situation, NVIDIA a modifié le code de ses pilotes afin que, dans les benchmarks les plus courants, le code du shader soit remplacé par un code plus productif.

Quoi qu'il en soit, mais la ligne suivante Retour au numéro de canal - GeForce 6 et processeurs vidéo a commencé à prendre en charge DirectX 9.0c et OpenGL 2.0. La septième génération - la GeForce 7, était le successeur direct de la précédente et n’a rien apporté de nouveau.

En 2006, ATI est acquise par AMD. Cependant, l'ancienne marque est préservée et les produits continuent à être étiquetés comme ATI Radeon. Encore une fois, changer le nom commercial, et à la place de la série X, il y a des séries HD (qui, incidemment, sont lancées à ce jour). Les nouveaux "deux-mille" - HD2000 - prennent en charge DirectX 10.0 et OpenGL 3.3. Série HD3000, en fait, rien de différent n’est différent (sauf que dans certains modèles, il existe un support pour DirectX 10.1). ligne suivante - HD4000 - également exploité les solutions précédentes: la réduction de la technologie de processus entraînant une dissipation thermique plus faible et a permis d'augmenter en toute sécurité le nombre de processeurs de flux, responsable du traitement graphique. La plupart des solutions haut de gamme reçoivent une mémoire GDDR5 (les modèles plus jeunes utilisent GDDR3).

Mais, NVIDIA fait une percée dans l'informatique, en libérant la huitième génération de son produit - GeForce 8. En plus de supporter DirectX 10 et OpenGL 3.3, l'appui technologique CUDA, qui peut être utilisé pour déplacer une partie des calculs de la CPU principale du processeur graphique. Parallèlement à cette technologie, une autre a été présentée - PhysX - qui, pour les calculs, pourrait utiliser un processeur central ou un processeur de carte vidéo avec prise en charge de CUDA.

Carte vidéo Zotac 9800GT avec 512 Mo de mémoire. Le modèle extrêmement infructueux en termes de dissipateur de chaleur, j'ai dû installer un refroidisseur supplémentaire pour un meilleur refroidissement

La neuvième génération - GeForce 9 - était en fait le développement de précédents succès. Au cours du développement, la désignation a été modifiée - la nouvelle ligne était appelée GeForce 100.

Dans la dixième génération - GeForce 200 - CUDA version 2.0 a été mise à jour. En outre, le support matériel pour H.264 et MPEG-2 a été ajouté. Certains modèles de cartes vidéo commencent à être équipés de mémoire rapide - GDDR5.

A la fin de 2009, ATI met à jour la gamme - le HD5000 sort. Outre la technologie de processus mise à jour, les cartes vidéo prennent en charge DirectX 11 et OpenGL 4.1.

En 2010, AMD décide d'abandonner la marque ATI dans les futures cartes. La nouvelle série - HD6000 - sort déjà sous le nom AMD Radeon. La sortie de l'image vidéo en 3D est également disponible.

NVIDIA change également la technologie des processus et de nouveaux processeurs graphiques - GeForce 400, prenant en charge DirectX 11 et OpenGL 4.1. Une énorme quantité de travail a été effectuée sur la puce, et grâce à MIMD, il a été possible d’augmenter considérablement les performances.

La poursuite du développement de la ligne - la GeForce 500 - a traditionnellement une consommation d’énergie réduite (en raison de l’optimisation) et de meilleures performances.

Nos jours

En 2012, les deux sociétés ont présenté des lignes mises à jour de leurs produits: GeForce 600 de NVIDIA et HD7000 d'AMD.

Les GPU NVIDIA ont reçu un remplissage mis à jour, basé sur l’architecture Kepler, ce qui a permis d’améliorer les performances et de réduire la dissipation thermique. La technologie de traitement à 28 nm a également bénéficié (dans les cartes du niveau initial, 40 nm sont utilisés). Les technologies disponibles sont DirectX 11.1 et OpenGL 4.3. Le marquage à un degré élevé de probabilité pour déterminer quel type de carte vidéo plus rapide: il a besoin de voir les 2 derniers chiffres de la série:

- GTX610-640 - soi-disant. cartes de bureau, ont des performances médiocres (moins de 100 dollars);

- GTX 650 et GTX 650 Ti - cartes de jeu d'entrée de gamme (moins de 150 $);

- GTX 660 - cartes de jeu de niveau intermédiaire (moins de 250 $);

- GTX 660 Ti, GTX670-690 - cartes de jeu du plus haut niveau de performance et de cartes vidéo haut de gamme (le coût peut atteindre 1 000 dollars et plus);

- GTX Titan, GTX 780 - cartes de jeu haut de gamme.

Le double processeur le plus rapide carte vidéo AMD Radeon HD 7990. À pleine charge consomme 500 watts, ce qui nécessite une alimentation puissante d'un côté et met fin à l'achat d'une deuxième carte pour le mode CrossFire

Les chipsets AMD ont l’architecture Graphics Core Next, la production est réalisée sur un processus de 28 nm. Les technologies disponibles sont DirectX 11.1 et OpenGL 4.2. Le but de la carte vidéo peut être déterminé par les 3 derniers chiffres:

- HD77x0-77 × 0 - jeu de cartes vidéo fourchette de prix initiale (moins de 200 dollars);

- HD78x0-78 × 0 - cartes de jeux vidéo à prix moyen (moins de 300 $);

- HD79x0-79 × 0 - cartes vidéo de jeux avancées et avancées (le coût peut atteindre 1000 dollars et plus).

Sur le marché russe, les chiffres 5, 7 et 9 du nom des modèles correspondent à la plus faible productivité de la classe, mais aussi au prix le plus bas. 9 montre au contraire que cette carte dans la classe est le plus productif.

Il semblerait que la désignation des modèles soit simple et compréhensible, et vous pouvez être sûr que la carte vidéo sur le chipset «plus ancien» sera plus rapide que le collègue «plus jeune». Malheureusement, ce n'est pas toujours le cas. Et même les performances des cartes construites sur un seul chipset peuvent différer de 20% (à peu près au même coût). Pourquoi cela arrive-t-il? Certains fabricants peuvent décider d'économiser sur les composants, en particulier pour installer une mémoire moins chère, ou utiliser un bus avec une largeur de bit inférieure. D'autres, au contraire, s'appuient sur des composants de qualité, overclockent et testent les cartes vidéo. N'oubliez pas le système de refroidissement: une carte rapide avec un ventilateur vibrant peut repousser tout le plaisir des jeux (surtout la nuit). Donc, ne soyez pas paresseux, mais il vaut la peine de visiter des sites Web faisant autorité et de lire des critiques de tests pour trouver non seulement une carte vidéo rapide, mais également silencieuse avec un bon refroidissement. Bonnes ressources: ixbt, ferra, easycom. Les avis peuvent être lus.

Les deux sociétés - AMD et NVIDIA - proposent des solutions pouvant satisfaire presque tous les utilisateurs. Les deux sociétés ont une solution pour la prise en charge de la 3D dans les jeux et les films, à savoir: AMD HD3D et 3D VISION de NVIDIA. Les cartes vidéo de ces sociétés peuvent afficher une image sur plusieurs moniteurs, au point que vous pouvez utiliser plusieurs moniteurs pour un seul jeu. De plus, AMD et NVIDIA ont des technologies qui permettent de combiner plusieurs cartes vidéo, respectivement CrossFire et SLI, grâce à quoi les performances de certains jeux doublent (voire triplent lors de l’installation de 3 cartes). En fait, c'est très bon chemin Augmentez les performances de votre système vidéo à l'avenir.

Jeu sur 3 écrans avec la technologie NVIDIA® 3D Vision ™. Il y a une expansion significative du champ d'application

Il ne reste plus qu'à décider quelles fonctions sont nécessaires et combien d'argent elle est prête à dépenser. Donc, pour la 3D, vous avez besoin d'un moniteur et de lunettes appropriés. PhysX est technologie NVIDIA, et déplacer certaines tâches du processeur vers le processeur de carte graphique peut avoir un effet positif sur les performances globales.

Vous avez sûrement une question mûre: quelle carte vidéo est actuellement la plus rapide? Ce phare biprocesseur, construit sur deux processeurs graphiques AMD Radeon HD 7970.

Et comment choisir une carte en fonction de votre budget et ne pas perdre? Cette question aidera à répondre à une tablette spéciale, qui calcule le coût absolu de 1% de la performance "idéale".

Ouvrez le tableau de performances de la carte vidéo (dans une nouvelle fenêtre)

Annexe 1

NVIDIA a publié une nouvelle série de cartes vidéo - 7xx. Maintenant, la plupart des conseils d'administration de cette série sont en train de fermer (à la fois en termes de fourchette de prix et de performance) des "trous" inévitables dans le processus de développement. La GTX 690 est très rapide, la GTX Titan est une carte graphique monoprocesseur extrêmement silencieuse et rapide. Mais en comparaison avec la GTX 680, ils sont sortis assez fortement. La différence de performance devrait être compensée par la GTX 770 et la GTX 780. Récemment, la GTX 760 a été annoncée. La principale caractéristique de la nouvelle série est la fréquence de chargement automatique importante (en comparaison avec les cartes précédentes).

Annexe 2

AMD a publié un nouveau monstre - une puce à deux carte graphique Radeon R9 295X2. Elle diffère de la »mère seule puce » - Radeon R9 290x - horloge de base légèrement élevée et des caractéristiques de doublement des autres composants - le bus de la mémoire 2 x 512 bits et à double chaleur - jusqu'à 500 W! Pour le refroidissement, un radiateur à eau avec une unité externe est utilisé. La valeur déclarée de ce "jouet" est de 1500 $, ce qui est plus de 2,5 fois plus cher qu'une carte à puce unique. Le prix, bien sûr, est élevé, mais la productivité dépasse les limites - il n’ya tout simplement pas de concurrents pour le moment. La seule carte capable de fournir un Metro: Last Light à la résolution Full HD et maxi 60 FPS, ou plutôt 71 FPS (pour la comparaison - GeForce GTX 780 Ti produit moins de 53 FPS).

« Faire tremper » la situation est destinée sorte de GeForce GTX TITAN Z - dvuhchipovik de NVIDIA, qui est à peu près aussi longtemps que l'on sait qu'il sera libéré. Le prix déclaré est de 3000 $. Très probablement, la carte sera plus rapide que son concurrent d'AMD, mais il vaut la peine qui est déjà un groupe de 2 GeForce GTX 780 Ti coûterait encore moins cher Radeon R9 295X2, à la lumière dont l'achat du phare de NVIDIA si elle semble prometteur, il est seulement dans le cas de la présence de 100 000 roubles supplémentaires et un désir fou de "ressentir" personnellement la nouveauté.

La plupart des smartphones utilisent l'architecture du processeur ARM. Il a été créé par la même entreprise et le supporte également. Dans le processus de création de la majorité des chipsets utilisés dans les appareils mobiles, son développement est utilisé.

Cependant, l'approche peut varier. Certaines entreprises proposent des solutions prêtes à concéder des licences, tandis que d'autres pratiquent la création de leurs propres solutions, en se basant sur le développement de l'entreprise. Pour cette raison, il existe une confrontation sur le marché entre les architectures de base et personnalisées des processeurs graphiques et des processeurs centraux.

Quel est le meilleur que Qualcomm ou ARM?

Aux solutions de base créées ARM, comprennent les cœurs de processeur et les graphiques au Mali. Ils sont utilisés, par exemple, par des fabricants de puces tels que Spreadtrum, Nvidia, Samsung, MediaTek.

Alors que Qualcomm a une approche différente. Pour les chipsets haut de gamme, il utilise des os Kryo, et pour équiper les puces Snapdragon, des graphiques Adreno sont utilisés. Il a été développé par des spécialistes de l'entreprise. La présence de différentes architectures provoque l’émergence de la question, qui devrais-je préférer - Qualcomm ou ARM?

Il est très difficile de donner une réponse sans ambiguïté à cette question. En plus de prendre une décision, les puces graphiques doivent recevoir la primauté. Je dois dire que ce n'est pas seulement la situation qui compte, mais aussi les tâches spécifiques qui sont définies. Et selon cela, les balances peuvent se plier d'un côté ou de l'autre. Cet article est destiné à aider ceux qui veulent bien comprendre ce problème.

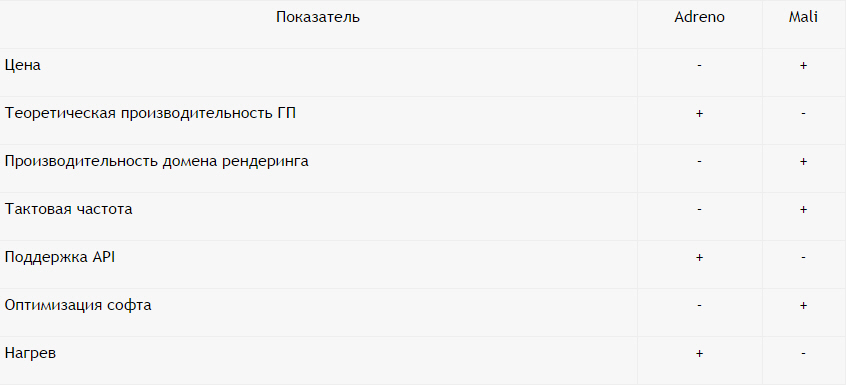

Les côtés positifs et négatifs d'Adreno

Commençons par les plus:

Haute performance. Les calculs théoriques indiquent une vitesse maximale des graphiques Adreno relativement Mali. Ils sont valables s'ils sont utilisés dans des chipsets de la même classe. Ainsi, pour Snapdragon 625, la puissance de traitement d'Adreno 506 est d'environ 130 GFLOPS (c'est environ un milliard de calculs par seconde avec un point flottant). Son concurrent MTK Helio P10, qui possède le GPU Mali T860 Mp2, dispose de 47 indicateurs GFLOPS.

Prend en charge des API plus avancées. La dernière génération de puces Adreno dispose d'un ensemble plus large d'API (outils logiciels de développement), en plus, ce sont des versions plus récentes. Par exemple, depuis la sortie d'Adreno à partir de la 500ème version, cela fait déjà un an. Et ils sont supportés par Open GL ES 3.2, DirectX12, OpenCL 2.0 et Vulkan. Bien que le Mali ne soit pas pris en charge par DirectX12, et OpenCL ne sont disponibles que pour la série G 2016, qui est apparue relativement récemment.

Ils sont moins surchauffés. Les GPU Adreno n'ont pas une tendance aussi élevée à la surchauffe que le Mali. Dans le même temps, je dois dire que Qualcomm avait des processeurs, qui étaient particuliers à tomber dans la limitation. Mais c'étaient des processeurs, caractérisés par une puissance accrue, respectivement, et le noyau du processeur avait un tempérament chaud. Presque comparables aux concurrents, ils ont fonctionné lorsque le régime de performance réduite a été observé.

Maintenant sur les inconvénients:

Très cher. Pour développer ses graphiques, Qualcomm doit dépenser plus d’argent par rapport au montant, ce qui coûte aux concurrents d’accorder des licences à ARM Mali. Pour cette raison, le coût des chipsets du fabricant américain est plus élevé que, par exemple, MTK.

Soft est optimisé pire. Commande, et ils utilisent des graphiques du Mali. Huawei dans les modèles Kirin pratique également l'introduction du stock GP de ARM. Et MediaTek préfère utiliser les graphiques ARM, sans en utiliser aucun autre. Le résultat est une grande part du Mali sur le marché mondial. Et parce que les développeurs de jeux sont privilégiés dans l’optimisation de leurs produits au Mali. Nous pouvons dire que le nombre de GFLOPS, de Mali en puces en rapport avec la moyenne et le budget est légèrement inférieur à celui d’Adreno.

En rendu, Fillrate est plus petit. Les puces Adreno ont un domaine de texturation relativement faible, qui est responsable du processus de formation de l'image finale. Adreno 530 est capable de tracer environ six cent millions de triangles formant une image 3D en une seconde. Et Mali G71 - 850 millions.

Aspects positifs et négatifs du Mali

Et dans ce cas, nous commençons par un positif:

Taux de prévalence élevé. En lien avec le graphisme malien de référence pour les chipsets des smartphones, l’optimisation des jeux est meilleure que sous Adreno.

Seuil de prix bas. Le coût d'une licence pour la production de chipsets avec le Mali est assez bon marché. Cela permet même aux petites entreprises qui n'ont pas la capacité de produire des millions d'investissements pour produire des puces du Mali. Et cela provoque une concurrence encourageante et stimule la société ARM en la poussant à développer de nouvelles solutions. De plus, les utilisateurs de graphiques maliens doivent dépenser moins d’argent.

Taux d'horloge élevé. Les fréquences utilisées dans les processeurs graphiques du Mali sont 1 GHz. Et la compétition ne dépasse pas 650 MHz. La fréquence plus élevée sur les puces Mali permet de meilleurs jeux, avec lesquels le traitement 3D multithread est maintenu pire.

Puissance du domaine de rendu. Le top GP du Mali G71 est capable de restituer environ huit cent cinquante triangles pendant une seconde, ce qui est identique à vingt-sept milliards de pixels. Et ce malgré le fait que Adreno 530 ne peut traiter que 8 milliards de personnes. Il est donc préférable de l'utiliser en travaillant avec des graphiques de textures HD à haute résolution.

Les noyaux Shader sont plus petits. Les processeurs graphiques du Mali ont moins de cœurs que les produits concurrents. Le Mali est pire et en termes de performance maximale dans les GFLOPS. De plus, ils sont moins adaptables aux jeux capables de paralléliser efficacement les charges sur GP.

Les configurations sont limitées. Le décalage réel entre les processeurs graphiques Mali et Adreno est insignifiant. Cependant, dans la vraie vie Les fabricants préfèrent utiliser des solutions prêtes à l'emploi qui ne sont pas très complexes, avec un très petit nombre de grappes informatiques. Ainsi, au Mali, le T720 assure la maintenance de l'ordre de huit blocs, mais le plus répandu est le Mali T720 MP2, qui ne compte que deux grappes.

Prédisposition à la surchauffe. La vitesse d'horloge élevée de la solution malienne est plus universelle, mais elle a pour effet secondaire de surchauffer. C'est pour cette raison qu'il est impossible d'intégrer un nombre significatif de grappes graphiques dans le chipset.

Adreno ou Mali qui est le meilleur?

Sur la base de ce qui précède, nous pouvons dire que Adreno possède des blocs informatiques plus puissants, supporte mieux les nouvelles technologies et ne crée pas de problèmes de surchauffe. Dans le même temps, sur le côté Mali la popularité, la disponibilité, la puissance du domaine de rendu et la fréquence d'horloge. Et, par conséquent, l'optimisation primaire du logiciel pour ces GP.

Mais je dois dire que ce ne sont que des calculs théoriques. La réalité, cependant, indique que le Mali est préféré pour une utilisation dans des modèles liés au budget et à la moyenne initiale. Tandis que la prérogative d'Adreno est un modèle de la classe moyenne et du produit phare. Et c'est tout à fait naturel, car la réalité moderne ne permet pas de voir les graphiques séparément du chipset.

Avantages et inconvénients de Adreno - Mali

Adreno ou Mali: Quel processeur graphique est le meilleur?

À ce jour, le marché des ordinateurs et des composants informatiques a connu un ralentissement du progrès technologique, comme dans de nombreuses branches à forte intensité scientifique de notre vie terrestre. En conséquence, les fabricants de cartes vidéo ont renommé les anciennes solutions légèrement améliorées et les commercialisent. Ces dernières années, AMD et NVIDIA n’ont pas été gênées.

C’est pourquoi, dans cet article, nous aimerions insister sur les principes généraux du choix d’une carte vidéo pour ordinateur moderne pour que le matériel soit pertinent pendant de nombreuses années, comme dans les principes du développement du marché des cartes vidéo au cours de la dernière décennie, pratiquement rien n'a changé. La plupart des critères ont été discutés par les utilisateurs de notre site MegaObzor sur le forum. Alors, commençons.

Comment choisir une carte vidéo?

Critère un: "Avant d'acheter, décidez de la nature de la carte vidéo?"

Beaucoup d’entre nous dans notre enfance rêvent de ordinateur rapide avec une carte vidéo productive. Commencez à faire de l'argent, la plupart cherche à réaliser un rêve d'enfance, mais l'achat rapide et, par conséquent, la carte vidéo coûteux ou ne peut pas trouver le temps d'utiliser pleinement dans les jeux d'ordinateur, ou de continuer à jouer dans l'habituel pour un compteur et grève et World of Tanks, qui sont des exigences particulières au matériel informatique en principe ne diffèrent pas. En conséquence, l'argent investi dans la carte vidéo immédiatement après l'achat dévalué de 30%, et après une année d'inactivité - tous 60-70%, donc autant que pour l'achat une fois nouvelle carte vidéo sur le marché secondaire, personne ne donnera.C'est pourquoi vous obtenez cartes vidéo selon les besoins. Si vous jouez, vous êtes habitué aux jeux anciens et nouveaux éléments que vous n'avez pas vraiment, il est tout à fait assez de cœurs graphiques intégrés dans les processeurs Intel Core i3 / Intel Core i5 / Intel Core i7 et AMD APU variations. Récent nettement inférieurs dans les carottes de performance, la consommation d'énergie fournie par les processeurs d'Intel, donc malgré la grande différence dans le prix, nous recommandons de prêter attention à ces représentants.

Moderne cartes mères savoir comment réaliser pleinement le potentiel cœurs de processeur graphique intégrés, un ensemble soudé de ports de sortie pour l'image sur eux dépend de chaque instance particulière, vous ne sentirez donc aucun défaut.

Si vous aimez jouer à des jeux PC modernes, et même à haute résolution et des détails, alors de toute carte graphique intégrée ne peut être question - il faut immédiatement regarder dehors graphiques qui se démarquent souvent que le processeur central, et souvent plus chers que lui.

Critère numéro deux: "À quel prix dois-je acheter une carte graphique pour les jeux modernes?"

Conditionnellement marché de la carte vidéo peut être divisé en trois catégories. La première catégorie concerne les cartes vidéo coûtant jusqu'à 150 dollars, la seconde allant de 150 dollars à 300 dollars et plus de 300 dollars.L’expérience montre qu’à un coût jusqu'à 150 dollars Il propose des époques oubliées vidéo, ou d'une mauvaise performance, ce qui est comparable ou inférieure à de nombreux noyaux graphiques intégrés modernes processeurs Intel Core i3 / Intel Core i5 / Intel Core i7 / APU AMD. Par conséquent, ils peuvent être achetés uniquement pour remplacer la carte vidéo de l'ancien ordinateur, mais pas pour créer un nouvel ordinateur de jeu.

Cartes vidéo dans la fourchette de prix de 150 à 300 dollars, peut être considéré comme un jeu. Dans ce cas, le coût de la solution est plus proche de 300 $, et sur les derniers noyaux graphiques peuvent fournir un niveau de performance acceptable dans les jeux modernes paramètres de qualité d'image moyenne.

Coût des cartes vidéo plus de 300 dollars et basé sur les dernières générations de cœurs graphiques, peut être considéré comme une carte graphique de jeu. Avec l'amélioration des caractéristiques techniques de la carte vidéo, son coût augmentera également. Lors du choix des données d'une carte vidéo, il est nécessaire de se rappeler que votre processeur doit pouvoir révéler tout son potentiel. Ceci est dans les critères suivants.

Critère troisième: "Quel processeur est nécessaire pour une carte vidéo de jeu moderne?"

Depuis dans n'importe quel ordinateur " la tête« Il est une unité centrale de traitement et qu'il envoie des commandes à la carte graphique - de sa performance performance graphique dépend de l'achat d'une carte graphique haut de gamme, mais ayant processeur improductif, vous ne découvrir son potentiel est pourquoi vous devez soit acheter un processeur rapide et moderne, avant d'acheter une carte vidéo, ou .. critiques sur Internet, trouver une solution minimale, qui est suffisante pour révéler son potentiel.En tout cas - la marge de performance du processeur mais c'est toujours bien, et la marge de performance de la carte vidéo est de l'argent jeté au vent.

Critère numéro quatre: "Quel fabricant de carte vidéo dois-je choisir?"

La plupart des cartes vidéo sont produites par le modèle de référence et seules les différentes versions overclockées ont un design individuel. La conception individuelle est nécessaire pour assurer le fonctionnement de la carte vidéo à des fréquences de fonctionnement plus élevées, souvent en tension et, par conséquent, avec un refroidissement plus efficace. Pratiquement toutes les cartes vidéo ASUS ont un design individuel, tandis que les autres fabricants ont des clones de la version de référence.Si vous ne prévoyez pas d'overclocker la carte graphiquePour vos fabricants de cartes de nom (ASUS, EVGA, Gigabyte, XFX, Palit, MSI) ne doivent faire la différence entre les options suivantes:

- prix;

- l'ensemble complet de la livraison (une boîte, des disques, des jeux, des adaptateurs, des couvertures, des étiquettes, etc.);

- système de refroidissement;

- la présence ou l'absence d'overclocking en usine;

- la période de garantie du fabricant.

Lorsque vous sélectionnez d'abord les quatre derniers points, sélectionnez la carte vidéo au coût minimum.

Si vous prévoyez d'overclocker la carte vidéo et que vous vous sentez comme un overclocker, alors, parmi les exigences ci-dessus, faites-vous remarquer:

- la disposition des composants de la carte vidéo sur la carte de circuit imprimé;

- le principe de la construction d'un système d'alimentation central, de la mémoire vidéo;

- les températures de fonctionnement de la carte vidéo avec un système de refroidissement installé en usine;

- la présence de toute sélection de puces par le fabricant;

- la disponibilité d'exemples de modification réussie de la carte vidéo sur Internet.

Il faut comprendre que overclockingEn règle générale, il est très agréable d’acheter une carte vidéo au coût minimum et de la disperser à un niveau plus élevé. Les overclockers performants réalisent 100% ou plus de la différence de coût lors du recalcul au ratio de performance par rapport au coût d'achat.

Critère cinquième: "Sur quelles caractéristiques techniques d’une carte vidéo à guider?"

Caractéristiques techniques des cartes vidéo les producteurs et les générations sont faciles à comparer, car leur construction n'a pas changé depuis de nombreuses années. Nous les listons:- type d'architecture du noyau;

- le nombre d'unités de calcul du noyau (shaders universels et blocs raster);

- le nombre de transistors utilisés dans la fabrication du noyau;

- la finesse du processus technologique de fabrication du noyau;

- la fréquence du noyau;

- largeur du bus mémoire;

- type de mémoire vidéo;

- fréquence de fonctionnement de la mémoire vidéo;

- la quantité de mémoire vidéo;

- consommation d'énergie / production de chaleur;

- prix

Toutes ces données sont présentées dans la description des biens des magasins en ligne, l'agrégateur de prix dans RuNet - Yandex.Market. Il suffit de cliquer sur la section "Spécifications" ou "Spécifications" pour obtenir des informations complètes.

Insistons sur ces caractéristiques plus en détail.

1. Type d'architecture du noyau. Ce paramètre détermine le nombre d'opérations que le cœur de calcul effectuera pour 1 cycle de calcul ou 1 Hz de la fréquence de fonctionnement. Les cœurs graphiques de différentes architectures fonctionnant à la même fréquence afficheront toujours des performances différentes, pouvant parfois atteindre 100%. Plus l’architecture de base de ce fabricant est récente, plus elle est progressive et effectue plus d’opérations par horloge.

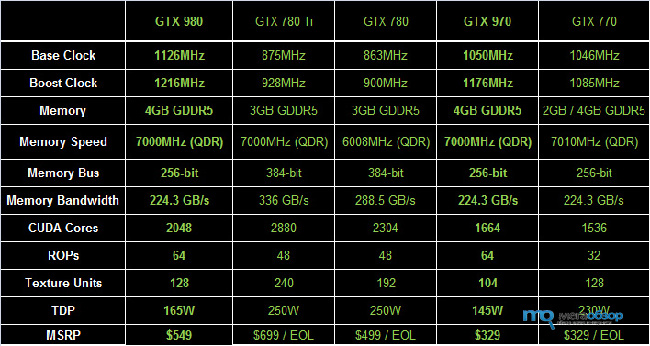

2. Le nombre d'unités de calcul du noyau (shaders universels et blocs raster) - affecte de manière significative les performances de la carte vidéo. Certaines cartes vidéo de différentes catégories de prix peuvent être construites sur les mêmes cœurs, mais ont un nombre différent d'unités informatiques activées. Pour plus de clarté, comparez ci-dessous cartes vidéo GeForce GTX 970 et GeForce GTX 980:

Les deux cartes vidéo sont construites sur le même noyau GM204. Mais la carte vidéo plus jeune a un nombre réduit d’unités de shader de 2048 à 1664 pièces. Coupe unités de calcul fabricants fait pour l'une des deux raisons: soit la puce avéré être un bloc défectueux (s) et le blocage de leur part, basée sur eux a été libéré pour la carte vidéo moins cher, ou des cartes vidéo plus chers ne sont pas vendus et après la coupe autorisée pour la production de cartes vidéo moins cher. Les dernières années ont permis aux overclockers, débloquant des blocs bloqués, de transformer des cartes vidéo bon marché en plus chères. Malheureusement, générations récentes les cartes vidéo présentent rarement une telle chance à leurs propriétaires.

3. Nombre de transistors utilisés dans la fabrication du noyau. Un autre paramètre important du noyau graphique de la carte vidéo. Cela est dû au fait que plus on utilise de transistors dans la production d’une carte vidéo, plus elle consomme d’électricité lors des pics de charge.

Revenons à la GeForce GTX 970 et GeForce GTX 980. cœur graphique GM204, Comme vous pouvez le voir, le noyau des deux cartes graphiques sont basées sur le même nombre de transistors, en dépit du fait que la GeForce GTX 970 a un plus petit nombre d'unités de calcul. Souvent, les unités déconnectées continuent de consommer de l'électricité à un certain niveau minimum, et la température moyenne de fonctionnement dans les mêmes fréquences de fonctionnement, les cartes graphiques seront comparables. Cette dernière circonstance rend la carte graphique rognée toujours moins économe en énergie que l’ancienne lors de la comparaison du rapport performances / consommation d’électricité.

4. La finesse du processus de fabrication du noyau. Le processus technologique moderne de fabrication des noyaux de cartes vidéo a atteint 28 nanomètres. Les processeurs Intel sont devenus plus sophistiqués. La technologie de traitement plus petit, le noyau consomme moins d'énergie, et les autres transistors peuvent être placés sur une plaquette de silicium, de réduire ainsi le coût de production. Mais la génération récente de noyaux montrent que le procédé de réduction augmente la température moyenne de fonctionnement, car l'augmentation de la densité des transistors entraîne une augmentation de la libération de chaleur par unité de surface. En tout état de cause, si un refroidissement adéquat est fourni, plus le processus technologique de fabrication du cœur est mince, mieux ce sera pour l'utilisateur final.

5. Fréquence du noyau. Plus la fréquence de fonctionnement des cœurs graphiques identiques est élevée, mieux ce sera, car cela fournira un niveau de performance supérieur.

6. Largeur du bus mémoire. Plus le bus de données est large pour la carte vidéo, mieux c'est. Mais il ne faut pas oublier que cette déclaration ne sera vraie que si les cartes vidéo ont le même type de mémoire vidéo et la même fréquence de fonctionnement. Des exemples évidents sont les deux principaux concurrents graphiques - GeForce GTX 980 et Radeon R9 290x, où malgré deux fois plus large échange de données de bus dans la dernière - carte graphique GeForce GTX 980 présente plus de performance en raison d'autres architecture de base et plus les fréquences de fonctionnement.

7. Type de mémoire vidéo. Le plus type moderne la mémoire vidéo, plus la fréquence de fonctionnement et les performances de pointe élevées peuvent fonctionner. Il est nécessaire de prendre des cartes vidéo sur le même type de mémoire vidéo que la version de référence du fabricant lors de l’annonce - NVIDIA ou AMD.

8. Fréquence de la mémoire vidéo. Plus la fréquence de fonctionnement de la mémoire vidéo est élevée, mieux c'est. Cette instruction est valide lorsque vous comparez deux cartes vidéo de même largeur que le bus de données.

9. Capacité de mémoire vidéo. Souvent, les fabricants modernes trompent les clients de manière flagrante, offrant au même prix deux cartes vidéo avec un volume important et réduit de puces de mémoire vidéo soudées. coût comparable est généralement atteint par l'utilisation d'un type de vidéo primitive, par exemple, au lieu de GDDR3 etc. GDDR5 brasé Sur cette ruse menée dans tous les cas, ne devrait pas être - la quantité supplémentaire de mémoire vidéo qui vous donnera un peu, mais le ralentissement de la mémoire vidéo conduira à une perte importante de solutions graphiques de performance.

10. Consommation d'énergie / dissipation thermique. Ici, tout est clair, plus la consommation d'énergie et la chaleur sont faibles, mieux c'est. Lorsque vous comparez des cartes vidéo, vous devez faire attention au nombre d'éléments non desséchés sur le circuit imprimé et à leur qualité. Moins il y a de places vides sous les condensateurs, moins les régulateurs de tension, plus la carte graphique sera stable avec les chutes de tension côté alimentation.

11. Prix: - devrait être minimal pour le produit qui répond aux exigences énumérées ci-dessus.

Critère Six: "interfaces de connexion carte graphique PCI-Express 16x 3.0 / PCI-Express 16x 2.0 / PCI-Express 16x 1.0 compatible ou non?"

Oui, les interfaces sont rétrocompatibles. Mais naturellement, plus interface moderne prend en charge votre carte mère, mieux c'est. La clé est le nombre de lignes PCI-Express actives - 16x ou 8x. Avec le nombre de lignes réduit à 8x, les cartes vidéo haut de gamme affichent des performances moindres que si vous travailliez dans un slot PCI-Express 16x 3.0 à part entière ou dans un slot PCI-Express 16x 2.0.Critère numéro sept: "Ai-je besoin d'un support pour la carte graphique SLI / CrossFire?"

Cette option est nécessaire dans le cas où vous êtes très riche ou risquez de devenir pauvre dans le futur. Dans le premier cas, s'il y a un support carte mère deux cartes vidéo ou plus, combinant leur puissance de calcul, vous obtiendrez une surproduction.

Dans le second cas, après quelques années, vous pouvez acheter une seconde carte vidéo similaire pour une somme dérisoire sur le marché secondaire, combiner celle-ci avec la carte existante et augmenter la productivité de 40 à 70% selon les jeux. La mesure dans laquelle cela sera effectif à ce moment-là n'est pas claire, car ces dernières années, deux générations de solutions graphiques ont presque doublé les performances.

Critère du huitième: "Qu'est-ce qui est mieux - NVIDIA ou AMD?"

Chaque fabricant possède sa propre architecture de base, une carte de circuit imprimé, une liste des technologies prises en charge. En conséquence, ils diffèrent en termes de productivité, de consommation d'énergie, de production de chaleur et de capacité à exécuter des fonctions connexes.

Par exemple, de nombreux convertisseurs vidéo prennent en charge l'accélération de la conversion en utilisant les capacités de calcul de la puce graphique de la carte vidéo. Le degré d'accélération dépend des performances du cœur de la carte vidéo et est assez significatif dans certains modes de conversion. D'accord, un bonus agréable.

Critère numéro neuf: "À quoi le CPU doit-il faire attention lors de l'achat d'une nouvelle carte vidéo?"

Premièrement, ce sont les tailles de la carte vidéo achetée. Dans le marché actuel, il existe des cartes vidéo à deux et à deux emplacements. Certains modèles peuvent être d'une longueur minimale et peuvent être facilement installés dans de nombreux cas de micro-ITX. Si vous avez un cas similaire - prenez une carte vidéo de taille minimale, si vous avez une "tour" complète, alors vous devriez prendre la norme - vous gagnerez l'efficacité de refroidissement des composants d'alimentation du cœur graphique et de la mémoire vidéo.Deuxièmement, il s’agit de la puissance de l’alimentation installée. La plupart des cartes graphiques de jeux modernes nécessitent une alimentation externe supplémentaire de 12 volts. Par conséquent, l’alimentation électrique doit avoir plusieurs lignes de 12 volts, avoir le nombre de prises requis alimentation complémentaire PCI-Express ou au moins vous devez avoir des adaptateurs pour les prendre en charge. La puissance maximale de l'alimentation électrique doit être supérieure de 20 à 25% à celle consommée par votre système à la charge maximale. Elle offre alors une efficacité maximale lors de la conversion de 220 volts en 12, 5 et 3,3 volts pour les utilisateurs de l'ordinateur.

Dixième critère: "Que signifie Retail (RTL) et OEM dans les noms de la carte vidéo?"

Ces inscriptions signifient compléter la solution proposée. OEM Les cartes vidéo sont fournies aux fabricants d’ordinateurs, ils n’ont donc pas les boîtiers habituels, ils ont un équipement minimal et sont livrés sur le marché, comme si "accidentellement". En règle générale, il s'agit d'une carte vidéo dans un package avec un disque pour installer les pilotes. Mais vous obtenez une carte graphique "en boîte" similaire au prix le plus bas.

Exemple d'achèvement d'une carte vidéo OEM

Abréviation Au détail ou RTL signifie que la carte vidéo est "encaissée", c'est-à-dire qu'elle est destinée à la vente au détail et qu'elle contient tout ce qui est indiqué sur le site Web du fabricant.

Ce sont peut-être tous ces points communs que vous devez connaître lorsque vous choisissez une carte vidéo pour un ordinateur de jeu.

Lors de la lecture des spécifications des smartphones et des tablettes, la plupart des utilisateurs accordent une attention particulière aux caractéristiques du processeur et, rAM, taille de l'écran, stockage intégré et caméra. Dans le même temps, ils oublient parfois un composant aussi important que le processeur graphique (GPU). Un processeur graphique typique d'une entreprise est associé à un processeur spécifique. Par exemple, les processeurs Qualcomm Snapdragon bien connus sont toujours intégrés aux puces graphiques Adreno. La société taïwanaise MediaTek fournissait généralement ses chipsets avec les processeurs graphiques PowerVR d'Imagination Technologies, et plus récemment avec ARM Mali.

Les processeurs chinois Allwiner sont généralement équipés de processeurs graphiques Mali. Les processeurs Broadcom fonctionnent avec les processeurs graphiques VideoCore. Intel utilise des processeurs graphiques PowerVR et des graphiques NVIDIA avec ses processeurs mobiles. Ressource s-smartphone.com a été compilé une note de trois douzaines des meilleurs en termes de paramètres, processeurs graphiques, conçus pour être utilisés dans les smartphones et les tablettes. Tout utilisateur moderne est important de savoir.

1. Qualcomm Adreno 430, utilisé dans le smartphone et;

3. PowerVR GX6450;

4. Qualcomm Adreno 420;

7. Qualcomm Adreno 330;

8. PowerVR G6200;

9. ARM Mali-T628;

10. PowerVR GSX 544 MP4;

11. ARM Mali-T604;

12. NVIDIA GeForce Tegra 4;

13. PowerVR SGX543 MP4;

14. Qualcomm Adreno 320;

15. PowerVR SGX543 MP2;

16. PowerVR SGX545;

17. PowerVR SGX544;

18. Qualcomm Adreno 305;

19. Qualcomm Adreno 225;

20. ARM Mali-400 MP4;

21. NVIDIA GeForce ULP (Tegra 3);

22. Broadcom VideoCore IV;

23. Qualcomm Adreno 220;

24. ARM Mali-400 MP2;

25. NVIDIA GeForce ULP (Tegra 2);

26. PowerVR GSX540;

27. Qualcomm Adreno 205;

28. Qualcomm Adreno 203;

29. PowerVR 531;

30. Qualcomm Adreno 200.

Le processeur graphique est un composant essentiel du smartphone. De ses capacités techniques dépend la performance des graphiques et, en premier lieu, les applications les plus intensives graphiquement - les jeux. Depuis que la notation a été compilée au cours du premier semestre, des modifications ont pu être apportées depuis. Comment pensez-vous que la position des processeurs dans cette évaluation correspond à leurs performances réelles?

« Pourquoi cette insertion est nécessaire? Donnez plus de cœurs, mégahertz et cache!"- un utilisateur d'ordinateur moyen demande et s'exclame. En effet, lorsqu'une carte graphique discrète est utilisée dans un ordinateur, le besoin de graphiques intégrés est éliminé. J'avoue que j'étais sournois sur le fait qu'aujourd'hui, le processeur sans vidéo intégrée est plus difficile à trouver qu'avec lui. Il existe de telles plates-formes - il s'agit de LGA2011-v3 pour les puces Intel et AM3 + pour les pierres "AMD". Dans les deux cas, nous parlons des meilleures décisions et il faut les payer. Les plates-formes classiques, telles que Intel LGA1151 / 1150 et AMD FM2 +, sont toutes équipées de processeurs graphiques intégrés. Oui, dans les cahiers, "incorporé" est indispensable. Au moins parce qu'en mode 2D ordinateurs portables courir plus longtemps sur la batterie. Dans les ordinateurs de bureau, le sens de la vidéo intégrée se trouve dans les ensembles bureautiques et les HTPC. Tout d'abord, nous économisons sur les composants. Deuxièmement, nous économisons à nouveau la consommation d’énergie. Néanmoins, récemment, AMD et Intel parlent sérieusement du fait que leurs graphiques intégrés - à tous les graphiques du graphique! Convient également pour les jeux. Ceci nous vérifierons.

Augmentation de 300%

Pour la première fois, les graphiques intégrés au processeur (iGPU) sont apparus dans les solutions (architecture du Core de la première génération) en 2010. Il est intégré au processeur. Un amendement important, puisque le concept même de "vidéo intégrée" a été formé beaucoup plus tôt. Intel - dans le lointain 1999 avec la sortie du 810-ème chipset pour Pentium II / III. À Clarkdale, HD Graphics intégré a été implémenté en tant que puce distincte, située sous le capot de diffusion de la chaleur du processeur. Les graphiques ont été réalisés à l’aide de l’ancienne technologie de processus 45 nm à l’époque, la partie informatique principale reposant sur les normes 32 nm. Les premières solutions Intel, dans lesquelles l’unité HD Graphics s’est «installée» avec les autres composants d’une seule puce, étaient les processeurs Sandy Bridge.

Depuis lors, les graphiques intégrés dans la «pierre» pour les plates-formes grand public LGA115 * sont devenus le standard de facto. Les générations Ivy Bridge, Haswell, Broadwell, Skylake - ont toutes une vidéo intégrée.

Intégré dans le processeur graphique est apparu il y a 6 ans

Contrairement à la partie informatique, le "montage" dans les solutions Intel progresse sensiblement. HD Graphics 3000 dans les processeurs de bureau Sandy Bridge K-series dispose de 12 périphériques exécutifs. HD Graphics 4000 à Ivy Bridge a 16; HD Graphics 4600 dans Haswell-20, HD Graphics 530 dans Skylake - 25. Les fréquences du GPU et de la RAM ne cessent d'augmenter. En conséquence, les performances de la vidéo intégrée en quatre ans ont été multipliées par 3 ou 4! Mais il existe une série beaucoup plus puissante d'Iris Pro "embarqués", qui sont utilisés dans certains processeurs Intel. 300% d'intérêt sur quatre générations.

Intégré au processeur graphique - c'est le segment sur lequel Intel doit suivre AMD. Dans la plupart des cas, les solutions du "rouge" sont plus rapides. Rien d'étonnant à cela, AMD développe des cartes de jeux vidéo puissantes. C'est dans les graphiques intégrés des processeurs de bureau utilisant la même architecture et les mêmes développements: GCN (Graphics Core Next) et 28 nanomètres.

Les puces hybrides d'AMD ont fait leur apparition en 2011. La famille des cristaux de Llano était la première dans laquelle les graphiques intégrés étaient combinés avec la partie de calcul sur un monocristal. AMD marketing ont réalisé que pour rivaliser avec Intel sur ses termes ne donc pas introduit le terme APU (Accelerated Processing Unit, unité centrale de traitement avec accélérateur vidéo), bien que l'idée nourrie « rouge » depuis 2006. Après Llano sont venues trois générations d '"hybrides": Trinity, Richland et Kaveri (Godavari). Comme je l'ai déjà dit, dans les puces modernes, l'architecture vidéo intégrée n'est pas différente des graphiques utilisés dans les accélérateurs Radeon 3D discrets. En conséquence, dans les puces 2015-2016, la moitié du budget des transistors est dépensée en iGPU.

La chose la plus intéressante est que le développement de APU a influencé l'avenir… des consoles de jeux. Ici et dans la PlayStation 4 avec Xbox One est utilisée puce AMD Jaguar - huit cœurs, avec des graphiques sur l'architecture de GCN. Vous trouverez ci-dessous un tableau avec des caractéristiques. Radeon R7 - c'est la vidéo intégrée la plus puissante, qui est la "rouge" à ce jour. Le bloc est utilisé dans les processeurs hybrides AMD A10. Radeon R7 360 est une carte vidéo d'entrée de gamme discrète qui, en 2016, peut être considérée comme une carte de jeu. Comme vous pouvez le voir, le "build-in" moderne en termes de caractéristiques est légèrement inférieur à l'adaptateur bas de gamme. On ne peut pas dire que les graphismes des consoles de jeux présentent des caractéristiques exceptionnelles.

L'aspect même des processeurs avec graphiques intégrés met souvent fin à la nécessité d'acheter un adaptateur d'entrée de gamme discret. Cependant, déjà vidéo intégrée d'AMD et Intel empiète déjà sur le sacré - le segment du jeu. Par exemple, dans la nature, il existe un processeur quad-core Core i7-6770HQ (2.6 / 3.5 GHz) sur l'architecture Skylake. Il utilise les graphiques intégrés Iris Pro 580 et 128 Mo de mémoire eDRAM en tant que cache de quatrième niveau. La vidéo intégrée comprend 72 unités exécutives fonctionnant à 950 MHz. Ceci est plus puissant que le graphique Iris Pro 6200, qui utilise 48 périphériques exécutifs. Par conséquent, Iris Pro 580 est des cartes graphiques plus rapides discrets tels que la Radeon R7 360 et GeForce GTX 750, et dans certains cas, imposer une concurrence GeForce GTX 750 Ti et Radeon R7 370. Que plus sera quand AMD APU transférera ses 16 nanomètre processus technique, et les deux fabricants utiliseront éventuellement avec la mémoire graphique intégrée.

Test

Pour tester le processeur graphique intégré moderne, j'ai pris quatre: deux d'AMD et Intel. Toutes les puces sont équipées de différents iGPU. Ainsi, gibridnikov AMD A8 (plus A10-7700K) vidéo Radeon R7 est livré avec 384 processeurs unifiés. L'ancienne série - A10 - 128 blocs de plus. Au-dessus du vaisseau amiral et de la fréquence. Il y a une série de A6 - en elle avec des capacités graphiques très triste, car il utilise « Retrofitting» Radeon R5 256 processeurs unifiés. Je ne l'ai pas considéré pour les jeux Full HD.

Les graphiques intégrés les plus puissants sont AMD A10 et Intel Broadwell

En ce qui concerne les produits d'Intel, les puces les plus fonctionnement Skylake Core i3 / i5 / i7 pour plate-forme LGA1151 utilisé par le module HD Graphics 530. Comme je l'ai déjà mentionné, il contient 25 actionneurs: 5 de plus que les HD Graphics 4600 (Haswell), mais 23 de moins que l'Iris Pro 6200 (Broadwell). Lors du test, le Core i5-6400 quad core junior a été utilisé.

|

Technologie de processus |

||||

|

La génération |

Kaveri (Godavari) |

Kaveri (Godavari) |

||

|

Plate-forme |

||||

|

Nombre de cœurs / threads |

||||

|

Fréquence d'horloge |

3,6 (3,9) GHz |

4,1 (4,3) GHz |

2,7 (3,3) GHz |

3,1 (3,6) GHz |

|

Cache de niveau 3 |

||||

|

Graphiques intégrés |

Radeon R7, 757 MHz |

Radeon R7, 866 MHz |

HD Graphics 530, 950 MHz |

Iris Pro 6200, 1100 MHz |

|

Contrôleur mémoire |

DDR3-2133, deux canaux |

DDR3-2133, deux canaux |

DDR4-2133, DDR3L-1333/1600 deux canaux |

DDR3-1600, deux canaux |

|

Niveau TDP |

||||

|

Appeler l'appât: AMD A8-7670K 3 en ligne |

Appeler l'appât: AMD A10-7890K 3 en ligne |

Appeler l'appât: Intel Core i5-6400 3 en ligne |

Appeler l'appât: Intel Core i5-5675C 3 en ligne |

Vous trouverez ci-dessous les configurations de tous les bancs d'essai. Quand il vient vous devez donner à la vidéo intégrée de la performance, l'attention en raison du choix de RAM, car elle dépend aussi du nombre de FPS affiche les graphiques intégrés à la fin. Dans mon cas, je les baleines DDR3 / DDR4, fonctionnant à une fréquence effective de 2400 MHz.

|

Bancs d'essai |

|||

|

|

|

|

|

|||

De tels kits ne sont pas pour rien. Officiellement, avec processeur intégré Kaveri contrôleur de mémoire fonctionne la mémoire DDR3-2133 cartes mères cependant chipset A88X (en raison du diviseur supplémentaire) et DDR3-2400 de support. Les puces Intel, couplées à la logique phare Z170 / Z97 Express, interagissent également avec une mémoire plus rapide, les préréglages du BIOS étant beaucoup plus volumineux. En ce qui concerne le banc d'essai, la plate-forme LGA1151 utilisait une baleine Kingston Savage HX428C14SB2K2 / 16 à deux canaux, qui fonctionne sans problème en overclocking à 3000 MHz. Dans d'autres systèmes, la mémoire ADATA AX3U2400W8G11-DGV a été utilisée.

Une petite expérience Dans le cas des processeurs Core i3 / i5 / i7 pour la plate-forme LGA1151, l'utilisation d'une mémoire plus rapide pour l'accélération graphique n'est pas toujours rationnelle. Par exemple, pour le Core i5-6400 (HD Graphics 530), le changement de DDR4-2400 MHz défini sur DDR4-3000 dans le Bioshock Infinite n'a donné que 1,3 FPS. C'est-à-dire que, compte tenu des paramètres de qualité graphique que j'ai définis, les performances se sont "reposées" précisément dans le sous-système graphique.

Lorsque vous utilisez des processeurs hybrides AMD, la situation semble meilleure. L'augmentation de la vitesse de la RAM donne une augmentation plus impressionnante du nombre d'images par seconde, dans les fréquences delta de 1866-2400 MHz, nous avons affaire à une augmentation de 2 à 4 images par seconde. Je pense que l'utilisation de la RAM dans tous les bancs d'essai avec une fréquence efficace de 2400 MHz est une solution rationnelle. Et plus proche de la réalité.

Juger de la vitesse des graphiques intégrés sera basé sur les résultats de treize applications de jeu. Je les ai conditionnellement divisés en quatre catégories. Le premier inclut les hits PC populaires mais peu exigeants. Ils sont joués par des millions. Par conséquent, ces jeux ("tanks", Word of Warcraft, League of Legends, Minecraft - ici) n'ont pas le droit d'être exigeants. Nous pouvons nous attendre à un niveau de FPS confortable avec des paramètres de qualité graphique élevés en résolution Full HD. Les autres catégories ont été simplement divisées en trois périodes: Jeux 2013/14, 2015 et 2016.

La performance des graphiques intégrés dépend de la fréquence de la RAM

La qualité des graphiques a été sélectionnée individuellement pour chaque programme. Pour les jeux peu exigeants, ce sont principalement des réglages élevés. Pour les autres applications (à l'exception de Bioshock Infinite, Battlefield 4 et DiRT Rally) - qualité graphique médiocre. Néanmoins, nous allons tester les graphiques intégrés en résolution Full HD. Les captures d'écran décrivant tous les paramètres de qualité graphique se trouvent sous le même nom. Nous considérerons un chiffre jouable à 25 images par seconde.

HD

L'objectif principal du test est d'étudier les performances des graphiques intégrés des processeurs dans la résolution Full HD, mais nous commencerons tout d'abord par une HD plus basse. Tout à fait à l'aise dans ces conditions se sentent iGPU Radeon R7 (pour l'A8 et A10) et l'Iris Pro 6200. Mais Graphics HD 530 avec ses 25 actionneurs dans certains cas, a donné à l'image complètement injouable. Plus précisément: dans cinq jeux de treize ans, depuis Rise of the Tomb Raider, Far Cry 4 « Witcher 3: Wild Hunt», Need for Speed 2 XCOM et de réduire la qualité des graphismes est nulle part. De toute évidence, dans Full HD, la puce vidéo intégrée Skylake s'attend à un échec complet.

HD Graphics 530 se fusionne déjà en 720p

Les graphiques Radeon R7, utilisés dans l’A8-7670K, n’ont pas réussi à gérer trois jeux, l’Iris Pro 6200 - avec deux, et l’A10-7890K - avec un seul.

Fait intéressant, il existe des jeux dans lesquels la vidéo intégrée Core i5-5675C contourne sérieusement la Radeon R7. Par exemple, dans Diablo III, StarCraft II, Battlefield 4 et GTA V. En basse résolution, non seulement la présence de 48 périphériques exécutifs affecte, mais aussi la dépendance du processeur. Et aussi la présence d'un cache au quatrième niveau. Dans le même temps, l'A10-7890K a battu son adversaire dans Rise of the Tomb Raider, Far Cry 4, "The Witcher 3" et DiRT Rally. L'architecture de GCN se manifeste bien dans les hits modernes (et pas tellement).

Full HD

Pour plus de clarté, ajoutons un ensemble comprenant un processeur FX-4300 et une carte vidéo discrète GeForce GTX 750 pour tester les graphiques intégrés. Quelque chose de similaire Calculer le coût est simple: la puce coûte 4000 roubles, l'adaptateur - 8500 roubles. Le duo est à 1000 roubles A10-7890K plus cher, 5.500 roubles plus A8-7670K, 5.000 roubles plus A10-7800, mais pour 7500 roubles moins cher i5-5675C de base.

En résolution Full HD avec des paramètres de qualité graphique maximum, le FPS jouable dans Dota 2 n'était pas affiché. De graves prélèvements sont observés. Dans les jeux comme MOBA, ils affecteront sérieusement le résultat final. La solution est simple. Réduisez les paramètres de qualité graphique de «Haut» à «Moyen». Dans Diablo III et StarCraft II avec les paramètres que nous avons définis, vous pouvez jouer. Sauf dans le cas de HD Graphics 530, le FPS minimum est réduit dans StarCraft II.

Dans la catégorie des jeux lancés en 2015, il est facile de jouer réel dans GTA V. Et il y a suffisamment de marge de sécurité pour ajuster les paramètres en vue d'améliorer la qualité des graphiques. Comme il l'a dit, avec la charge croissante sur la vidéo intégrée, le niveau de FPS entre A10-7890K et Core i5-5675C dans le jeu sur les grands vols automatiques a presque égalé. Dans The Witcher 3: Wild Hunt et Fallout 4 ne jouent pas, vous devez par exemple réduire la résolution à 1600x900 points.

Dans les jeux publiés en 2016, avec des graphiques intégrés, il est préférable de ne pas se soucier du tout. Ici, sans jeu bon marché, mais une carte vidéo discrète ne peut pas faire.

Résumons-nous avec mon appareil préféré - un exposé clair des faits: le processeur HD Graphics 530 et le processeur Core i5-6400 ont présenté un FPS jouable en deux parties de treize; Les puces restantes - seulement dans quatre applications. Changer vraiment la situation avec une augmentation du nombre d'images est possible uniquement dans DiRT Rally, Bioshock Infinite et Dota 2, ce qui réduit la qualité des graphiques. Dans d'autres cas, vous devrez modifier la résolution. Dans le même temps, le bundle "FX-4300 + GeForce GTX 750 Ti" faisait face à tous les jeux.

en conclusion

Le miracle n'a pas eu lieu. Si nous parlons de jeux en Full HD, alors les graphismes intégrés des processeurs modernes ne peuvent faire face qu’à des jeux multijoueurs sans ressources, ainsi qu’aux jeux populaires des temps anciens. Avec les jeux AAA modernes lancés cette année, ni la Radeon R7 ni l’Iris Pro 6200 ne peuvent faire face. Le reste - et plus encore. Par conséquent, s'appuyer sur un processeur hybride avec un puissant iGPU n'a de sens que. Dans toute autre situation, il est préférable d'acheter une carte graphique discrète plus efficace. C'est banal, mais c'est vrai.

Les graphiques intégrés des processeurs continueront à progresser rapidement. Intel a déjà un noyau de HD Graphics 580. Voyons si quelque chose de similaire apparaît dans le segment de bureau. AMD va bientôt sortir ses premières puces de 16 nanomètres. Il n'y a pas de délais précis, mais je suis sûr que les "rouges" de l'APU continueront d'évoluer. Comme ils disent, attendez et voyez.

Oui, dans certains cas, les graphiques intégrés de l'Iris Pro 6200 sont plus rapides que la Radeon R7, mais le Core i5-5675C lui-même est beaucoup plus coûteux que tout APU existant pour la plate-forme FM2 +. Si vous avez besoin unité de système pour les jeux peu exigeants, il est préférable (moins cher) de prendre une puce AMD hybride.