AMD Radeon пришел черед и компании Nvidia. Ее графические процессоры GeForce пользуются не меньшей популярностью среди игроков, чем продукция конкурента. Обе компании нога в ногу шагают на рынке, предлагая клиентам решения, схожие по уровню производительности и цене. Поэтому было бы несправедливо посвятить материал построению конфигурации CrossFire, но обойти стороной аналогичные возможности продуктов Nvidia.

Немного истории

Началом эры SLI можно считать 1998 год. Тогда компания 3dfx впервые сумела реализовать возможность объединения нескольких видеокарт для решения одной задачи. Однако развитие интерфейса AGP затормозило разработки в этом направлении, так как все материнские платы того времени оснащались только одним слотом для видеоплаты.

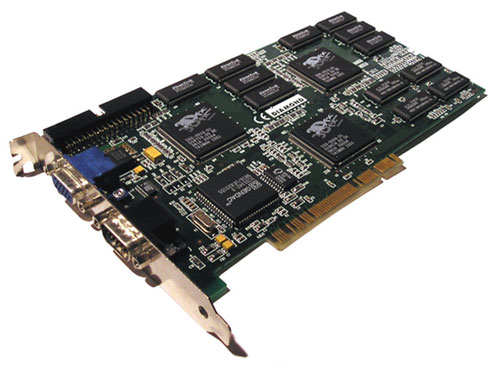

SLI от 3DFX — «дедушка» современной технологии

После того, как в 2001 году 3dfx были куплены компанией Nvidia, все разработки в этом направлении ожидали своего часа, который наступил только в 2004 году. Именно тогда, в 6000-й серии GeForce (первые видеокарты, разработанные специально под новейший на то время интерфейс PCI-Express) имеющиеся разработки были усовершенствованы и внедрены в продукты массового потребления.

SLI из двух GeForce 6600GT

Сперва объединить можно было две видеокарты GeForce 6600 или 6800, с выходом 7000-й серии (в которой была представлена первая полноценная двухпроцессорная плата от Nvidia, 7900GX2) появилась возможность построения четырехпроцессорной конфигурации (из 2 карт), а позже стало возможным и сочетание 3 или 4 раздельных ГП.

Как объединить видеокарты в SLI: требования

Как и для CrossFire, недостаточно купить две видеокарты Nvidia, чтобы сконфигурировать их в SLI. Существует ряд требований к компьютеру, которые следует соблюдать для обеспечения нормального функционирования связки.

Какие видеокарты можно объединить в SLI

Подключение двух видеокарт SLI -мостиком возможно, только если для этого мостика предусмотрен интерфейс на плате. Программными средствами объединить их тоже можно попытаться, но без «плясок с бубном» в таком случае не обойтись. Да и не имеет смысла строить тандем из двух GT610 или GT720. Одна карточка, быстродействие которой окажется выше, чем у подобной связки, в 2 или 3 раза, обойдется дешевле, чем комплект из пары офисных карт и совместимой материнской платы. То есть, отсутствие на младших представителях графических ускорителей SLI-интерфейса вызвано вовсе не жадностью производителя. Мостики никто не ставит, потому что это сделает карту дороже, но смысла от них никакого не будет. Таким образом, подключение двух видеокарт SL I возможно для моделей среднего и топового класса. К таковым относятся ГП, вторая цифра названия которых – 5 и выше (GTX5 5 0Ti, GTX9 6 , GTX6 7 0, GTX7 8 0 и т.д.).

У GeForce GT 720 нет мостика для SLI

Перед тем , как подключить SLI две видеокарты , стоит убедиться в том, что они построены на одной версии графического процессора. К примеру, GeForce GTX650 и GTX650Ti, несмотря на схожесть названий, функционируют на базе совершенно разных ГП и потому в тандеме работать не смогут.

Есть ли практическая польза от SLI?

Перед тем, как объединить видеокарты в SLI, желательно ознакомиться с опытом использования таких конфигураций другими геймерами и изучить спецификации своих карт, а также характеристики более производительных решений в линейке. Нередко ни в плане экономии, ни по производительности, выигрыша двухкарточная конфигурация не дает. К примеру, две GTX950 в SLI демонстрируют результаты, сравнимые с одной GTX970. Разница в цене (около 200 и 400 долларов, соответственно) самих карт оправдана, но если учесть дополнительные затраты на мощный БП, двухслотовую материнскую плату, качественный и хорошо вентилируемый корпус – выглядит она сомнительно.

Совсем иная ситуация, если – составляющая часть процедуры апгрейда имеющегося ПК, купленного пару лет назад. Карточки уровня GTX650Ti или GTX750 все еще можно встретить в продаже по разумной цене (разница с новыми моделями примерно эквивалентна различиям по быстродействию), а технический прогресс за 3 года не преподнес ничего революционного для видеокарт (разве что память HBM, представленную AMD, но Nvidia это пока не касается). Поэтому добавление еще одного графического процессора – вполне рациональный шаг для таких игроков.

SLI: подключение видеокарт

Если компьютер соответствует требованиям для создания SLI-конфигурации, подходящая вторая видеокарта куплена – можно переходить к сборке. После выключения ПК следует снять крышку системного блока, установить вторую плату в соответствующий слот, подключить к ней дополнительный кабель питания (если таковой требуется) и соединить две карты мостиком, идущим в комплекте. Аппаратное подключение двух видеокарт в SLI на этом завершено и можно переходить к программной настройке.

Кабели питания, подключенные к связке SLI

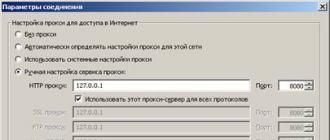

Подключение двух видеокарт SLI в Windows

Для того, чтобы связка из двух ГП могла нормально функционировать – нужно установить на ПК Windows версии Vista или новее (7, 8, 8.1 или 10). Рекомендуется также скачать с сайта Nvidia самую свежую версию драйвера для видеокарты. После этого можно переходить к настройке.

После применения установок связка готова к работе. Возможно, для корректной настройки работы SLI в некоторых играх придется задать им особые параметры в подменю «Программные настройки». Но, как правило, большинство современного ПО в этом не нуждается.

Здравствуйте, сегодня мы поговорим о видеокартах Nvidia работающих в режиме SLI, а именно об их проблемах и способах их решения, но сначала разберемся, что такое режим SLI. Nvidia SLI – это технология, которая позволяет использовать несколько видеокарт одновременно и при этом существенно повысить производительность системы. Одним из основных требований является использование одинакового графического процессора на используемых видеокартах. Ниже будут перечислены более детальные требования для построения компьютера, который будет работать с данной технологией.

- Материнская плата должны иметь два или более разъемов, которые поддерживают данную технологию;

- Хороший блок питания, который сможет обеспечить питанием нашу систему (блоки SLI-Ready являются рекомендуемыми);

- Видеокарты, которые поддерживают данную технологию;

- Мост, которым можно объединить видеокарты;

- Процессор с высокой тактовой частотой, который сможет раскрыть потенциал видеокарт, чтобы не возникало падение кадровой частоты и производительности в целом.

С вышеперечисленного выходит, что построение NVIDIA SLI не является чем-то недостижимым, а наоборот практически ни чем не отличается от сборки обычного домашнего компьютера.

Проблемы

Ну что ж, выше была изложена информация, зачем нужен SLI, его плюсы, а теперь переходим к проблемам и их решению.

- Первая проблема это зависимость от драйверов, драйвера нужно обновлять очень часто, поскольку вносятся серьезные изменения и выходят оптимизации под конкретные игры либо приложения;

- Вторая проблема заключается в том, что не все игры/приложения поддерживают данную технологию и в некоторых играх/приложениях нужно заставлять работать именно несколько Ваших видеокарт;

- Третья проблема данной технологии в тех же обновлениях, поскольку при каждом обновлении драйвера нужно проводить некоторые манипуляции, чтобы работали все видеокарты, а это не всякий раз удобно и не все обладатели данной технологии готовы «рыться» в настройках и разбираться со своими проблемами.

Решение проблем:

- Первая проблема решается достаточно просто. Скачиваем утилиту с официального сайта NVIDIA GeForce Experience, регистрируемся для использования данной программы, заходим на свой аккаунт, и кликаем кнопкой мышки «Проверить наличие обновлений». Если найдется более свежий драйвер, то он будет скачан, и Вам предложат его установить.

- Вторая проблема не всегда решаемая, поскольку не все производители приложений оптимизируют свои приложения под данную технологию, но все же можно попробовать исправить проблемы с производительностью некоторыми несложными манипуляциями в настройках самого драйвера под Вашу систему SLI.

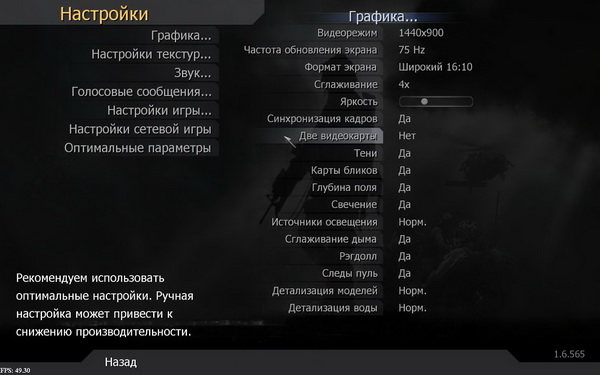

Ниже представлю Вам пример настройки игры The Sims 2, которая по умолчанию не оптимизирована под режим SLI.

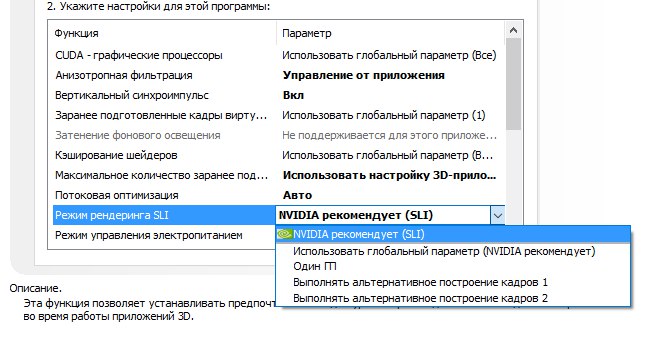

Открываем «Панель управления Nvidia» — управление параметрами 3D – программные настройки и нажимаем на кнопку «Добавить» — указываем путь к файлу, который запускает нашу игру - смотрим на второй раздел «Укажите настройки для этой программы» — режим рендеринга SLI, если есть «Nvidia рекомендует (SLI)», то выбираем данный пункт, если нет, то выбираем «Выполнять альтернативное построение кадров 2».

Нам нужно еще настроить управление электропитанием, а для этого идем в «Режим управления электропитанием» и выбираем пункт «Предпочтителен режим максимальной производительности ».

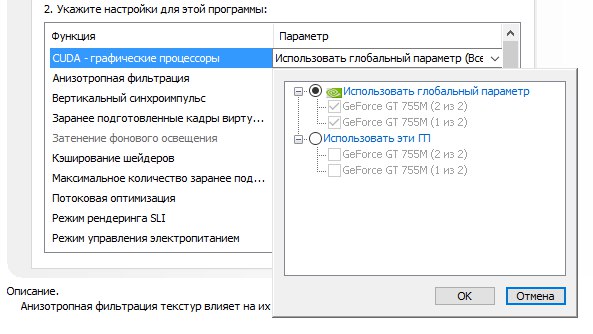

Последним пунктом у нас будет настройка «CUDA – графические процессоры» в данной настройке должны быть выделены галочкой абсолютно все Ваши видеокарты, которые вы хотите использовать в данном приложении.

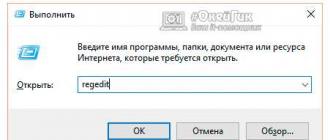

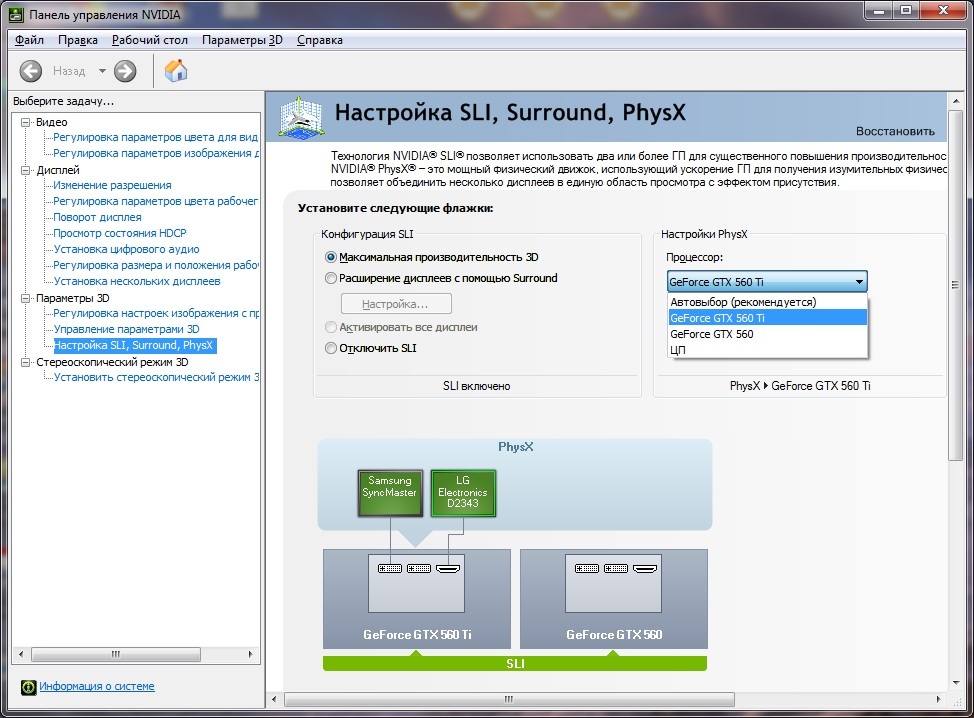

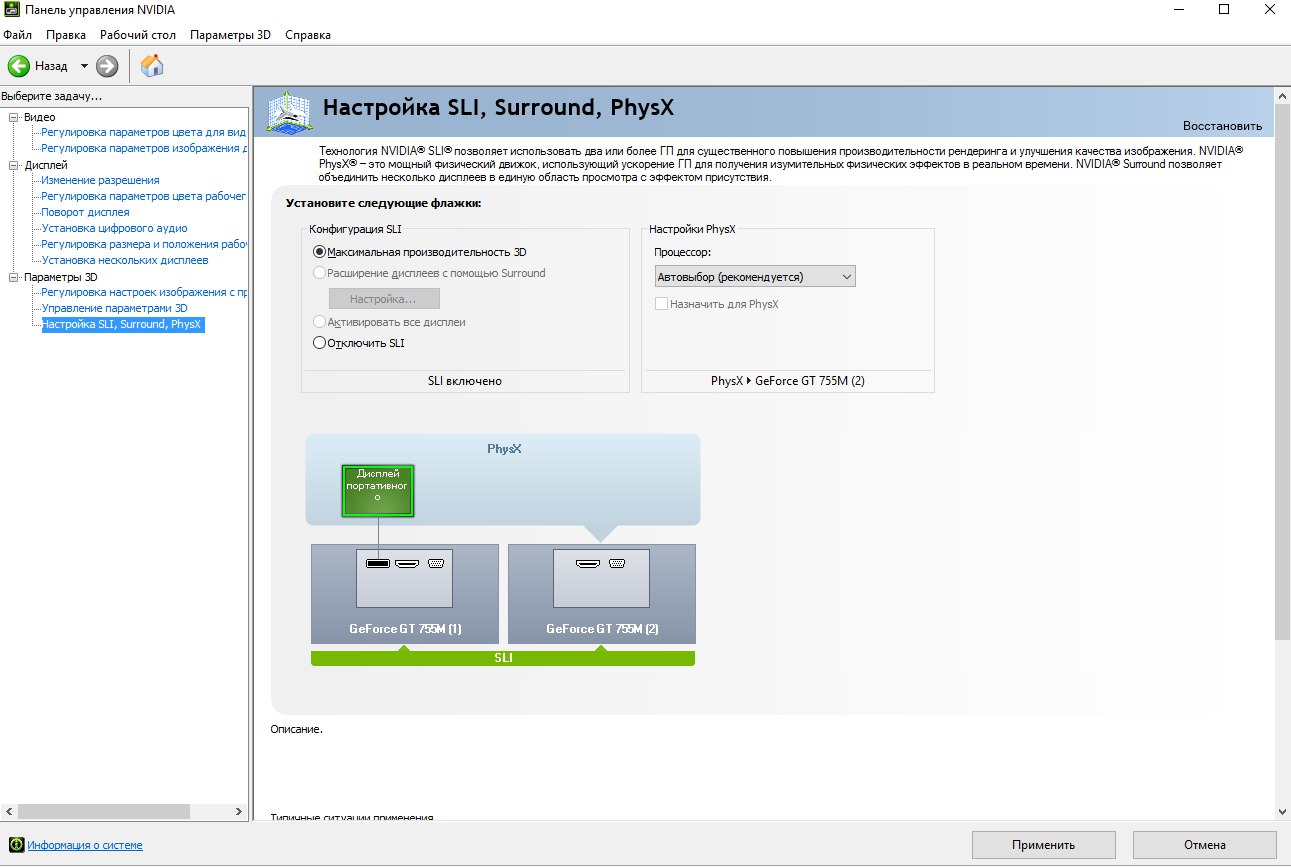

- Третья проблема решается довольно просто, но появляется каждый раз, как мы обновили драйвер и для её исправления нужно несколько кликов. Поскольку мы еще не выходили с панели управления Nvidia нужно кликнуть на вкладку «Настройка SLI, Surround, PhysX» и нажать на «Обновить параметры» затем на кнопку «Применить» и данная проблема будет решена.

Наконец-то, мы дождались! По крайней мере, те пользователи, кому производительности одной видеокарты сегодня мало. Какая разница, сколько стоит подобное решение, если оно обеспечивает непревзойдённую скорость в самых высоких разрешениях с максимальным уровнем деталей. Наконец, nVidia смогла представить рабочую реализацию технологии SLI. Концепция SLI нам давно знакома: две видеокарты, работающие параллельно, - помните старые карты Voodoo2 от 3dfx? Хотя технология nVidia тоже названа SLI, её реализация всё же несколько отличается.

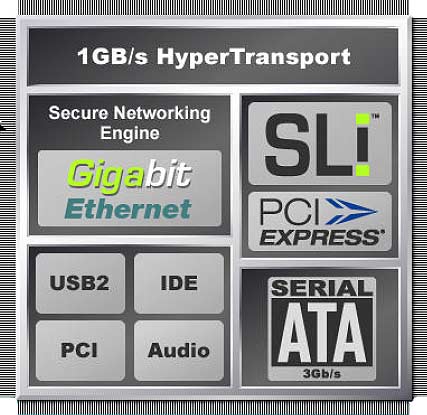

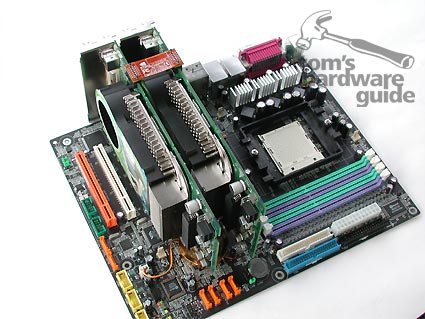

Возрождение принципа использования двух графических карт стало возможным благодаря появлению интерфейса PCI Express. Выпустив чипсет nForce4, nVidia первой представила платформу PCI Express, соответствующую поставленной задаче. Дополнительную информацию вы можете получить в статье nVidia реализует SLI: мощь двух GPU в одном компьютере .

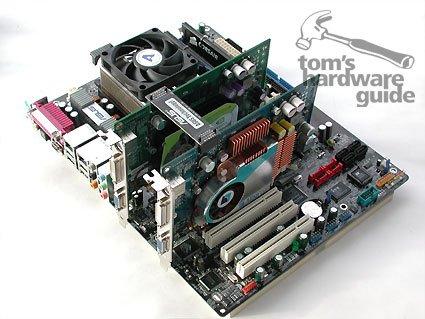

Собрать компоненты для системы SLI не представляет особого труда: нужно найти две идентичные карты nVidia GeForce 6800 Ultra, 6800 GT или 6600 GT с поддержкой PCI Express, а также SLI-совместимую материнскую плату на чипсете nForce4 SLI плюс мост для соединения двух карт. Обычно этот мост производители материнских плат прилагают в комплект поставки. Поскольку производители часто меняют расстояние между двумя слотами x16, некоторые мосты позволяют регулировать свою длину.

Для SLI ничего больше не потребуется - за исключением денег, которые придётся выложить за всё это хозяйство. Дело в том, что материнская плата с поддержкой SLI обойдётся вам существенно дороже обычной версии, не считая затрат на вторую видеокарту. Также вам следует обзавестись мощным блоком питания с 24-контактной вилкой. У владельцев ЖК-мониторов тоже могут возникнуть проблемы. Дело в том, что большинство дисплеев имеют "родное" разрешение 1280x1024. Однако потенциал производительности системы SLI на двух картах GeForce 6800 сегодня можно раскрыть только в разрешении 1600x1200. При уменьшении разрешения "узким местом" будет CPU, так что вам придётся потратиться и на более мощный процессор.

В общем, система SLI недёшева. В следующих разделах нашей статьи мы поделимся нашим опытом и результатами тестов первых материнских плат с поддержкой SLI от ASUS и MSI.

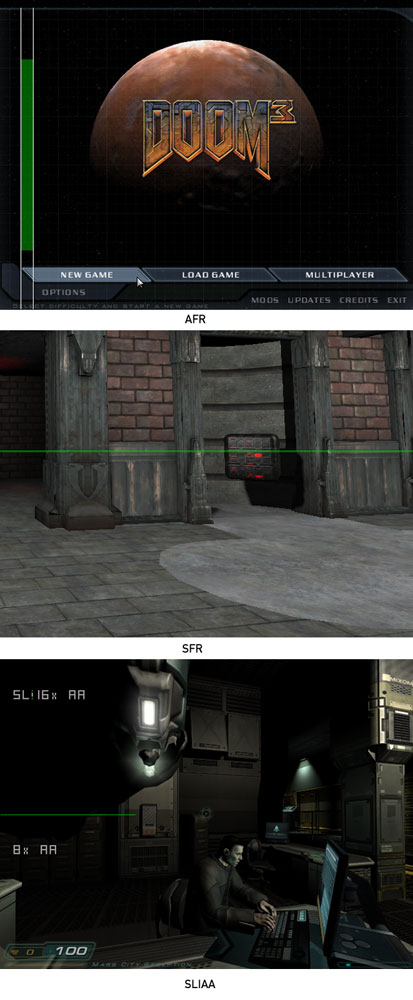

На данный момент nVidia предлагает три различных режима для SLI.

- Режим совместимости (Compatibility Mode).

- Альтернативный рендеринг кадров (Alternate Frame Rendering, AFR).

- Разделённый рендеринг кадров (Split Frame Rendering, SFR).

В режиме совместимости работает только одна карта из двух. Никакого прироста производительности нет. В режиме AFR одна из карт компьютера выдаёт все чётные кадры, а вторая карта - все нечётные. То есть рендеринг разделён между двумя картами по кадрам.

В режиме SFR дисплей разбит на две части. Первая карта выдаёт верхнюю часть картинки, а вторая - нижнюю. Благодаря динамической балансировке нагрузки драйвер равномерно распределяет нагрузку между двумя картами.

nVidia достаточно подробно разъясняет особенности рендеринга режима SLI в двух руководствах (на английском): GPU Programming Guide и SLI Developer FAQ .

Для нашего теста SLI мы получили от nVidia по две эталонные карты GeForce 6800 Ultra и 6800 GT с интерфейсом PCI Express. Внешне эти карты отличались только размерами радиатора. Обе модели оснащены двумя выходами DVI-I (выход VGA обеспечивается через переходник) и ТВ-выходом. Как обычно в случае карт PCI Express, на их обратной стороне располагался разъём питания PEG (PCI Express Graphics). Поскольку подобными разъёмами оснащены только самые последние блоки питания, вам могут потребоваться переходники.

К сожалению, мы не смогли быстро найти две SLI-совместимые карты GeForce 6600 GT, поскольку две модели карт в нашей лаборатории не поддерживали SLI, несмотря на подходящие разъёмы.

Конфигурация SLI на картах nVidia GeForce 6800 Ultra.

Конфигурация SLI на картах nVidia GeForce 6800 GT.

Конфигурация SLI на картах nVidia GeForce 6600 GT - не заработала.

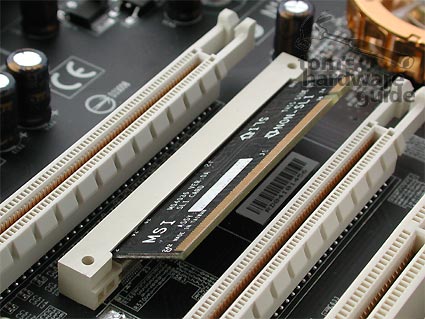

Без моста SLI здесь не обойтись. У материнских плат расстояние между графическими картами чётко задано. Все производители материнских плат задают разное расстояние между слотами x16, поэтому они прилагают в комплект поставки соответствующие мосты. Мы получили два регулируемых моста от nVidia, которые покрывают любое нужное расстояние.

Разные мосты SLI.

Без моста SLI драйвер выдаёт предупреждение. Режим SLI будет работать, но весьма ограничено (см. анализ производительности).

Первый опыт SLI

Аппаратное обеспечение

Как вы понимаете, мы с нетерпением ждали выпуска SLI. Ещё в марте, публикуя статью, посвящённую шине PCI Express , мы ожидали будущие решения на нескольких картах. Конечно же, последовавший анонс такого решения от nVidia приковал всё наше внимание.

Впрочем, после появления первых материнских плат с поддержкой SLI, наш энтузиазм быстро сошёл на нет. Наша тестовая конфигурация постоянно давала сбои, а карты GeForce 6800 и 6600 GT PCIe либо не распознавались вообще, либо компьютер "слетал" через несколько секунд после загрузки. После многих безуспешных попыток запустить систему SLI мы обнаружили причину: карты были слишком "старые". Наши модели относились к совсем ранним образцам nVidia, и, по данным производителя, они не работают должным образом со SLI. Впрочем, эти карты давно уже не продаются, и этому вряд ли следует уделять особое внимание. Последние образцы карт 6800 Ultra и GT работают с технологией SLI без всяких проблем. Здесь, конечно же, возникает вопрос - можно ли затем докупить вторую видеокарту для работы по SLI от другого производителя? Пока мы не знаем ответа.

У нас возникли немалые проблемы и с материнскими платами SLI. Плата ASUS A8N-SLI полностью сбрасывала BIOS каждый раз, когда мы перезапускали компьютер - и эта проблема встречалась не только на нашей тестовой плате. Из-за ограничений по времени тестирования мы не смогли бы поменять плату на другую. Как оказалось позже, причиной сбоя являлась партия дефектных чипов BIOS. К счастью, чип BIOS находится в сокете, поэтому мы смогли быстро его заменить. После этого A8N-SLI Deluxe заработала без всяких проблем.

У платы MSI K8N Diamond, с другой стороны, были выявлены проблемы с памятью при работе в SLI. Наши модули памяти Kingston HyperX в режиме 2/2/2/6 DDR400 приводили к постоянному краху системы. Компьютер загружался и стабильно работал с настольными приложениями и даже с Prime95 в режиме 2/2/2/6, но сразу же "вылетал" при включении режима SLI в большинстве игр. При использовании одной карты такой проблемы не возникает. Только после того, как мы увеличили задержки до 2,5/3/3/7, плата MSI K8N Diamond стабильно заработала в режиме SLI. У нашей тестовой платы также возникли проблемы с пропускной способностью памяти. Даже при задержках 2/2/2/6 тест Sandra выдавал пропускную способность памяти всего 4,9 Гбайт/с, что соответствует DDR 333! К примеру, плата ASUS A8N-SLI выдаёт чуть меньше 6 Гбайт/с.

Потом нам пришлось увеличить задержки памяти для работы SLI и у платы ASUS, так как в режиме 2/2/2/6 и у неё происходили сбои. При переходе на задержки 2/3/3/6 плата работала стабильно. Как мы полагаем и надеемся, эти проблемы связаны с тестовым статусом материнских плат, и у розничных версий они не проявятся. За последние недели ASUS и MSI устроили настоящую гонку за то, кто первым выпустит рабочую плату SLI. Как вы понимаете, "поспешишь - людей насмешишь". Проблемы следовало ожидать. К тому же, большинство из них возникает только в режиме SLI.

После устранения описанных аппаратных проблем конфигурация SLI была сразу же распознана драйвером видеокарты. После включения режима SLI и необходимого перезапуска компьютера всё правильно заработало. Работа SLI становится заметна только при использовании утилиты по подсчёту кадров типа FRAPS в игре. Качество картинки оказалось ничем не отличающимся от обычного режима - никаких линий, мерцания или других артефактов мы не заметили. Только включив режим SLI HUD в драйвере, который показывает распределение частей экрана для просчёта в режиме SLI, вы можете судить о работе SLI.

После установки системы SLI драйвер 66.93 правильно всё распознал.

Включив режим HUD, вы можете видеть распределение нагрузки между двумя картами.

С материнской платой ничего особого делать не нужно - разве что скачать последнюю версию драйверов nForce4.

После нескольких тестов мы обнаружили относительно медленную производительность в двух играх. После включения SLI HUD в драйвере мы увидели, что в этих играх SLI не активируется. Даже форсированное включение SLI в расширенных настройках драйвера не привело к нужному эффекту. После общения с представителями nVidia мы узнали причину проблемы: SLI действительно не работает на некоторых играх. nVidia использует так называемые профили SLI для игр, которые определены в драйвере. Драйвер распознаёт игру через технологию определения приложений и включает нужный режим SLI (разделённый или альтернативный), указанный в профиле. Если профиля SLI для игры не существует, то и режим SLI не будет включён. Форсировать режим SLI или создать свой профиль невозможно. Впрочем, по информации nVidia, в драйвере уже существует более 50 профилей для игр, где будет включён режим SLI. Если же игра совсем новая, то владельцам SLI, вероятно, придётся ждать выхода нового драйвера. Но даже тогда нет никакой гарантии, что режим SLI будет включён в той или иной игре.

По информации nVidia, существуют игры, которые просто несовместимы со SLI. В качестве примера можно назвать Microsoft Flight Simulator 9 и Novalogic Joint Operations. Причину на момент выхода статьи мы не знаем точно. nVidia указывает только на то, что в этих играх используются технологии кадрового буфера, которые вызывают проблемы со SLI. В общем, из 10 игр, которые мы включили в наше тестирование, две оказались несовместимы со SLI.

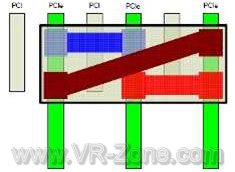

Теоретически, стандарт PCI Express позволяет подключать бесконечное число параллельных линий PCI Express, однако новые настольные чипсеты ограничены 20 линиями или ещё даже меньшим их количеством. Если учесть, что слот PEG (PCI Express for graphics- PCI Express для графики) уже отнимает 16 линий, то для всех остальных слотов остаётся всего четыре.

nVidia немного схитрила с выпуском чипсета nForce 4 . При работе одной видеокарты доступны все 16 линий. Но при переходе на режим SLI 16 линий распределяются между двумя слотами x16. Так что каждый слот PEG работает в режиме x8 PCI Express.

Впрочем, на практике подобное решение практически не сказывается на производительности, ведь пропускная способность x8 PCIe соответствует AGP 8x. Как показывает наше сравнительное тестирование режимов x8 и x16 PCIe , к ощутимым различиям в производительности это не приводит.

Материнские платы с поддержкой SLI

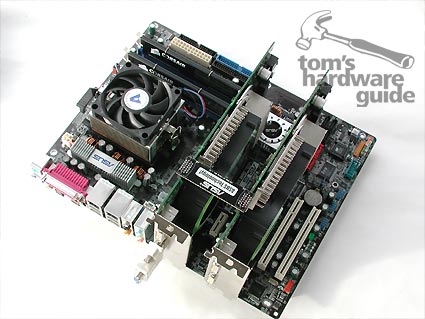

ASUS поставляет A8N-SLI с хорошим набором аксессуаров.

Плата ASUS A8N-SLI Deluxe имеет хорошую комплектацию. ASUS увеличила расстояние между слотами x16 PCIe, разместив между ними два слота x1 PCIe. Небольшая плата определяет работу одной или двух графических карт - в зависимости от того, каким концом она вставлена. Пружинные крепления "EZ Switch" облегчают процесс. В режиме SLI необходимо подключить дополнительную вилку питания Molex (EZ Plug). Дело в том, что спецификация PCI Express допускает максимальное питание 75 Вт на слот x16. По информации ASUS, без дополнительного подключения питания у систем SLI, блоки питания которых оснащены 20-контактными вилками ATX, могут возникать проблемы. В инструкции ASUS рекомендует использовать блоки питания стандарта ATX 2.0, которые имеют 24-контактные вилки - даже несмотря на использование дополнительного разъёма питания. В отличие от MSI, ASUS объясняет, что две карты GeForce 6800 Ultra могут нагружать 12-В линию блока питания током до 14,8 ампер. Если вы используется Athlon FX-55, то добавьте ещё 8,6 А. Старые 20-контактные вилки питания ATX (1.0) подают только одну линию 12 В. В результате из-за высокой продолжительной нагрузки на эту линию блок питания может выйти из строя. Новые блоки питания стандарта ATX 2.0 используют 24-контактный разъём, где присутствует две линии 12 В, что позволяет распределить нагрузку между ними. Благодаря разъёму ASUS EZ Plug блок питания может ещё лучше распределить нагрузку. ASUS рекомендует использовать блок питания на 450 Вт или выше для систем SLI с Athlon FX-55 и GeForce 6800 Ultra, поскольку только эти компоненты потребуют не меньше 281 Вт.

Единственным недостатком, как нам кажется, является активное охлаждение северного моста. Как показывает опыт, вентилятор может относительно быстро выйти из строя. Лучше бы ASUS использовала только радиатор.

Внешний вид A8N-SLI (нажмите для увеличения).

Эта маленькая карточка переводит материнскую плату в режим работы с одним или двумя слотами.

ASUS обеспечивает два дополнительных слота x1 PCI Express и три PCI.

Дополнительное питание для второй видеокарты в режиме SLI. Если вы забудете его подключить, то при использовании второй карты зажжётся красный светодиод.

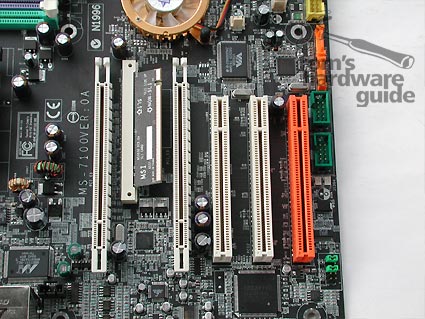

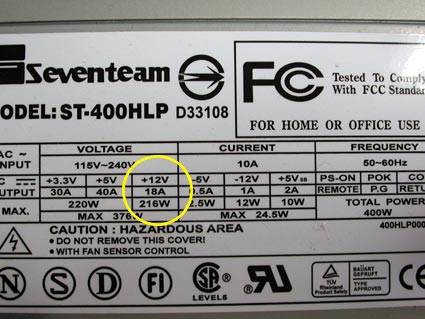

На первый взгляд, плата MSI K8N Diamond очень похожа на модель ASUS. В то же время, MSI расположила два слота x16 ближе друг к другу. Между ними тоже располагается небольшая плата для установки режимов работы (одна или две видеокарты), но на этот раз она закреплена под углом. MSI решила не добавлять дополнительные слоты PCI Express. Для второго слота x16 дополнительного питания тоже не предусмотрено. Чтобы система с двумя картами работала без проблем, рекомендуется использовать мощный блок питания с 24-контактной вилкой питания. По информации MSI, использовать 20-контактную вилку ATX тоже можно, если по линии 12 В блок питания выдаёт не меньше 18 А. Здесь утверждения MSI и ASUS несколько различаются, поскольку последняя указывает, что для системы SLI требуется больше.

Вентилятор северного моста располагается рядом со вторым слотом x16, и видеокарта его закрывает. Впрочем, он имеет небольшую толщину, поэтому карте не мешает.

Внешний вид материнской платы K8N Diamond (нажмите для увеличения).

Небольшая карта переключает материнскую плату в режим работы с одной или двумя графическими картами.

MSI не предоставляет дополнительных слотов x1 PCI Express, поэтому придётся довольствоваться тремя слотами PCI.

MSI рекомендует для систем SLI блок питания на 450 Вт. При использовании 20-контактной вилки ATX необходимо удостовериться, что линия 12 В даёт не меньше 18 А.

Отсутствие дополнительного питания может привести к появлению проблем с блоками питания ATX, оснащёнными 20-контактными вилками.

Тестовая конфигурация

Мы протестировали конфигурацию SLI с картами GeForce 6800 Ultra и GT с обеими материнскими платами ASUS и MSI. Для тестирования производительности одной видеокарты мы использовали только плату ASUS. В качестве процессора мы взяли Athlon 64 4000+ (он соответствует Athlon 64 FX-53) и оснастили систему 1 Гбайт памяти. Мы использовали блок питания Antec True Control ATX (1.0) с 20-контактной вилкой. Отметим, что во время тестирования никаких проблем мы не обнаружили. Мы также протестировали и 760-Вт блок питания для рабочей станции, когда проверяли, не связаны ли проблемы стабильности с недостаточным питанием.

Из-за проблем со стабильностью, описанных выше, мы решили не проводить тестов по "разгону".

| Тестовая система 1 | |

| CPU | AMD Athlon 64 4000+ |

| Материнская плата | ASUS A8N-SLI Deluxe (nForce4 SLI) |

| Память | |

| HDD | |

| DVD | Hitachi GD-7000 |

| LAN | Netgear FA-312 |

| Блок питания | Antec True Control 550W |

| Тестовая система 2 | |

| CPU | AMD Athlon 64 4000+ |

| Материнская плата | MSI K8N Diamond (nForce4 SLI) |

| Память | 2x Kingston DDR400 KHX3200/512, 1024 Мбайт |

| HDD | Seagate Barracuda 7200.7 120GB S-ATA (8 Мбайт) |

| DVD | Hitachi GD-7000 |

| LAN | Netgear FA-312 |

| Блок питания | Antec True Control 550W |

| Драйверы и конфигурация | |

| Видеокарты | ATi Catalyst v4.11 nVidia v66.93 |

| Чипсет | Intel Inf. Update |

| ОС | Windows XP Prof. SP1a |

| DirectX | DirectX 9.0c |

| Видеокарты, использованные для тестов | |

| ATi | Radeon X800 XT PE PCIe (520/560 МГц, 256 Мбайт) |

| nVidia | GeForce 6800 Ultra PCIe (420/550 МГц, 256 Мбайт) GeForce 6800 GT PCIe (350/500 МГц, 256 Мбайт) GeForce 6600 GT PCIe (420/550 МГц, 128 Мбайт) |

| Тесты | |

| 3DMark 2005 | Standard Resolution |

| Custom Timedemo Max Details/Quality Map: Assault-FallenCity |

|

| Call Of Duty v1.4 | Max Details/Quality Demo: VGA |

| Doom3 | Demo: Demo1 High Quality |

v1.3 |

Custom Timedemo cooler01 Very High Quality Flashlight: On |

| Custom Video Custom Quality Scenario: Hong Kong at Dusk |

|

v1.2 |

FRAPS Max Details/Quality Map: Ho Chi Minh Trail |

| The Sims 2 | FRAPS Max Details/Quality Custom Scene |

| Half-Life 2 | Three custom Timedemos Max Details/Quality |

Результаты тестирования

Unreal Tournament 2004, специальная timedemo (уровень Fallen City, Assault):

Call Of Duty, версия 1.4, встроенная timedemo timedemo1:

Doom 3, встроенная timedemo demo1

Farcy, версия 1.3, специальная timedemo cooler01, фонарик включён

The Sims2, выбранная сцена Goth Family (5 секунд с FRAPS)

Flight Simulator 2004, версия v9.1, специально записанный ролик, сценарий "Hong Kong At Dusk" (FRAPS):

Battlefield Vietnam, версия 1.2, карта "Ho Chi Minh Trail", Gameplay Measurement (FRAPS)

Half-Life 2, специальная timedemo THG2

Half-Life 2, специальная timedemo THG5

Half-Life 2, специальная timedemo THG8

Анализ производительности

Наши первые тесты сразу же показали, что режим SLI требует очень мощного CPU. При работе самых скоростных карт GeForce 6800 GT и Ultra в режиме SLI даже самый быстрый процессор не успевает обеспечивать их данными. Вся мощь SLI заметна только при высоких разрешениях 1280x1024 или, лучше, 1600x1200 с включением FSAA и анизотропной фильтрации - то есть в тех сценариях, которые максимально нагружают современные видеокарты. При снижении разрешения и выключенных FSAA и AF режим SLI даёт незначительные преимущества. Кстати, на некоторых играх переход на SLI дал даже некоторое замедление (UT 2004), что, возможно, связано с дополнительными вычислительными затратами по распределению нагрузки, которые SLI возлагает на CPU. В то же время, мы обнаружили падение производительности в режиме SLI даже на Flight Simulator 2004, по сравнению с одной картой, несмотря на то, что FS2004 не поддерживает режим SLI вообще. Или, говоря другими словами, если в системе SLI работает только одна карта, производительность будет снижаться по сравнению с компьютером, где установлена только одна карта. Не сильно, но ощутимо.

Ниже мы привели пример игры Unreal Tournament 2004. Мы использовали GeForce 6800 GT в разрешении 1024x768 без FSAA и AF. Как в режиме SLI, так и в обычном, центральный процессор не мог угнаться за графической картой и нагрузить её достаточным количеством данных, являясь "узким местом". Чем мощнее будет процессор, тем выше будет производительность:

- режим SLI включён (2 карты): 157,2 FPS;

- режим SLI выключен (2 карты): 163,2 FPS;

- одна карта (1 карта): 163,4 FPS.

Если этот феномен в UT2004 и других играх можно объяснить (вероятно, распределение нагрузки SLI возлагает на процессор дополнительные вычисления), то мы не понимаем, почему подобная ситуация происходит и в играх, которые не поддерживают SLI, где даже при включении SLI работает только одна карта (Flight Simulator 2004). Кстати, в играх OpenGL, типа Call of Duty, эта проблема не так ощутима.

Если игра активно использует программы-шейдеры (например, Doom 3 и FarCry), то прирост производительности SLI компенсирует любые недостатки при высоких разрешениях и включённых настройках качества.

Тип игры тоже немало влияет на эффективность SLI. Игры со старыми 3D-движками типа Call of Duty выигрывают от SLI только на высоких разрешениях и включённых настройках качества. Но производительность здесь уже очень высока и без SLI, так что никаких проблем не возникнет. В то же время, современные игры, активно использующие шейдеры (например, Doom 3 и FarCry), демонстрируют преимущество от SLI даже при небольших разрешениях.

Чтобы рассеять все сомнения в наблюдающемся феномене падения производительности при низких разрешениях в SLI, мы проанализировали производительность работы одной карты в режимах x8 PCIe и x16 PCI. Результаты оказались полностью идентичными.

Наконец, наше последнее измерение касается UT2004 без подключённого мостика SLI в разрешении 1600x1200 4xAA/8xAF:

- с мостиком SLI (2 карты): 153,3 FPS;

- без мостика SLI (2 карты): 133.0 FPS;

- одна карта (1 карта): 101,1 FPS.

Помимо стандартной работы SLI на материнских платах, можно реализовать ещё два сценария. Вместо того, чтобы две видеокарты работали совместно, можно использовать их для подключения к компьютеру до четырёх мониторов. Причём этот режим работы не ограничен только картами nVidia - мы не испытали каких-либо проблем при установке X800 или X700. После загрузки Windows распознала вторую карту и установила драйвер.

В то же время, у последних драйверов ATi CCC (Catalyst v4.11) наблюдаются определённые проблемы с распознаванием данного режима работы. Display Manager Wizard распознаёт выходы только первой карты, хотя Display Manager показывает три монитора. В любом случае, вы не сможете менять параметры типа разрешения и т.д. для всех мониторов. CCC позволяет устанавливать эти параметры только для первой карты X800. Когда вы пытаетесь нажать на дисплей, подключённый к другой карте, то CCC сразу же переходит к первому дисплею. С другой стороны, регулировка настроек в Windows Display Manager проходит без всяких проблем.

Microsoft Flight Simulator 9 без всяких проблем запустился на трёх дисплеях в режиме двух и трёх дисплеев на картах X800 и X700. В то же время, режим "3D-span" на двух картах ATi пока невозможен. Мы попытаемся узнать причину у ATi и сообщим позднее.

Теперь перейдём к nVidia. Мы решили установить во второй слот GeForce PCX 5750, а в первый - GeForce 6800 Ultra. Вторая карта вновь была распознана Windows без всяких проблем. В меню драйвера nVidia появились обе карты, так что настройки можно осуществлять по отдельности. Впрочем, режим "span" по объединению трёх мониторов в один большой экран (наподобие функции Matrox Surround Gaming) с картами nVidia невозможен, даже если второй картой установить GeForce 6800 Ultra. Режим "span" ограничен только одной картой - не слишком хорошо! Почему-то при использовании двух карт в настройках nView Мастер nView Display Wizard был недоступен.

Итог будет таков. Поддержка трёх или четырёх дисплеев через две видеокарты на материнских платах SLI ещё требует доработки драйверов. Если бы режим "span" был не ограничен одной картой и двумя дисплеями, то мы получили бы неплохую конфигурацию для игр (surround gaming). В конце концов, у Matrox, которая и разработала Surround Gaming, все три монитора работают от одной карты.

![]()

Наконец, мы не смогли отказать себе в удовольствии провести один последний тест. Даже во времена Voodoo2 пользователи могли запускать 3D-игры через стандартную видеокарту или отдельную карту Voodoo2. Так почему бы сейчас не попробовать установить Radeon X800 XT PE вместе с GeForce 6800 Ultra и не подключить обе карты к монитору, оснащённому двумя входами? Так мы и поступили.

Установка драйвера ATi Catalyst v4.11 вместе с nVidia Detonator v66.93 никаких проблем не вызвала. После перезагрузки драйвер ATi вывел ошибку, поскольку не смог активировать второй дисплей. После того, как мы исправили ситуацию в меню Windows Display, мы получили доступ к опциям драйвера ATi.

ATi и nVidia в гармонии - по крайней мере, на нашем компьютере.

Теперь на панели задач появились значки ATi и nVidia.

На первой карте GeForce 6800 игры запускались без проблем. После того, как мы переключили основной дисплей на ATi X800, при запуске игры мы получили ошибку D3D. Перезапуск компьютера не помог.

Поменяв карты, мы установили X800 в верхний слот - система не заработала вообще. После определения графических карт и перезагрузки драйвер GeForce 6800 не смог корректно загрузиться, хотя карта по-прежнему присутствовала в Device Manager.

Но мы так легко не сдаёмся! Поэтому мы вернулись к конфигурации, когда GeForce 6800 Ultra занимала первый слот, а X800 XT - второй. И вновь мы определили X800 как основной монитор. Кроме того, мы выключили дисплей GeForce 6800, отключив функцию "Extend my Windows Desktop onto this Monitor" (расширение рабочего стола Windows на этот монитор). Перезапустились - и теперь все 3D-игры заработали и на X800!

Ниже мы привели пошаговые инструкции. Сначала активирована только GeForce 6800 Ultra. Драйверы nVidia и ATi установлены, как описано выше.

3D Mark 2003 запускается на GeForce 6800 Ultra.

В Windows Display Manager карта Radeon X800 XT отключена (дисплей 2).

После нажатия на второй дисплей выберите опцию "Extend my desktop onto this monitor", а затем опцию "Use this device as the primary monitor" и нажмите "Apply". Теперь переключите ваш монитор на второй вход VGA.

Теперь выберите мышью первый дисплей и отключите его, сняв флажок опции "Extend my desktop onto this monitor".

После того, как вы нажмёте "Apply", карта GeForce 6800 будет выключена.

Запуск 3D-приложения выдаёт сообщение об ошибке - время перезагрузиться!

Во время загрузки ПК экран поначалу будет чёрным, поскольку все сообщения загрузки выводятся через первую карту (GF 6800), а вход нашего монитора подключён к X800. После загрузки Windows появится картинка, а карта GeForce 6800 выключится.

После перезагрузки: запускаем 3D Mark 2005 - всё успешно!

Переключение обратно на GeForce 6800 происходит точно так же. Но почему-то GF 6800 поначалу стартует только с глубиной цвета в 4 бита! Не волнуйтесь. После перезагрузки компьютера вы сможете установить правильное разрешение и глубину цвета.

Конечно, подобный режим не назовёшь удобным, поскольку он требует перезагрузки компьютера, но он всё же работает. Вы можете выбирать между картами ATi и nVidia на одном компьютере!

Заключение

Этого можно было ожидать: компьютер с поддержкой SLI, оснащённый двумя картами GeForce 6800 Ultra или GT побеждает по производительности всех остальных! Резервы производительности системы SLI просто великолепны. Даже с процессором Athlon 64 4000+ производительность почти всегда упиралась в CPU - он просто не успевал просчитывать и выдавать на карты информацию. Только в разрешении 1600x1200 пикселей с включением 4x FSAA и 8x анизотропной фильтрации карты SLI смогли получить достаточную нагрузку. Вид игры тоже в немалой степени влияет на прирост производительности, обеспечиваемый SLI. Если игра интенсивно использует шейдеры (например, Doom 3 и FarCry), то преимущество от SLI будет заметно даже при низких разрешениях. В то же время, на относительно старых играх типа UT 2004 и Call of Duty прирост оказывается меньше. Кстати, даже Half-Life2 получает от SLI сравнительно небольшой прирост. Следует отметить, что некоторые игры в режиме SLI вообще не смогут запуститься.

Производительность системы SLI на двух картах GeForce 6600 GT мы сможем оценить, только когда в нашу лабораторию поступят новые тестовые карты. Одно понятно уже сейчас: задёшево систему SLI собрать не получится.

При покупке системы SLI учитывайте, что этот режим поддерживают не все игры. Если драйвер не обнаружит у себя подходящего профиля SLI для игры, то игра будет работать с одной картой даже при включении SLI - причём производительность в этом случае может даже снизиться по сравнению с системой, в которую установлена только одна карта. На это в немалой степени влияет возраст игры и уровень 3D-технологий в ней. Ещё одна финансовая проблема связана с тем, что пока неизвестны розничные цены на карты GeForce 6800 PCIe и SLI-совместимые материнские платы. Пока что мы слышали об увеличении цены примерно на $50 по сравнению со стандартными материнскими платами на nForce4 Ultra.

Среди протестированных SLI-совместимых материнских плат на nForce4 наш выбор пал на ASUS A8N-SLI Deluxe. И не только из-за лучшей производительности. Хотя MSI, без всякого сомнения, решит проблемы с пропускной способностью памяти в финальной версии платы, модель ASUS обеспечивает два дополнительных слота x1 PCI Express, которые у MSI отсутствуют. Ещё одним фактором является дополнительное питание для второй видеокарты на плате ASUS - похоже, здесь производитель подошёл более продуманно.

Мы не согласны с тем, что поддержка SLI сегодня возможна только на играх, выпущенных совместно с nVidia. Подобно "разгону", неплохо бы получить в драйверах опцию, принудительно включающую работу SLI, даже если это приведёт к потенциальным ошибкам и краху. Ведь технология SLI нацелена на энтузиастов! Любой, кто согласен вложить $1000 в графическую подсистему своего компьютера, может смириться с риском того, что игра или компьютер будут иногда "вылетать" в режиме SLI. По нашему мнению, очень не весело ждать следующей версии драйвера или использовать "утечку" драйвера для новой игры. Вряд ли так следует поступать с целевой аудиторией, для которой предназначена технология SLI.

Другим применением материнских плат SLI можно считать использование конфигураций с более чем двумя мониторами. Да и некоторые фанатики могут установить в свой компьютер одновременно карты ATi и nVidia.

Если судить по тестам современных адаптеров с двумя топовыми GPU (Radeon HD 7990, GeForce GTX 690) либо аналогичных конфигураций на базе отдельных карточек, технологии NVIDIA SLI и AMD CrossFireX в целом преодолели период мучительного взросления. Во многих играх двухпроцессорная система демонстрирует почти двукратное преимущество над таким же одиночным GPU, а в прочих вполне можно рассчитывать на бонус в пределах 50-70%. По крайней мере именно так обстоят дела среди игр категории ААА. Менее популярные игрушки обычно ускользают от внимания IT-изданий, и насколько хорошо их оптимизируют под SLI и CrossFireX, судить не беремся. Кроме того, в целом оптимистичную картину портят неудачи в отдельных играх, где либо производительность все-таки плохо масштабируется, либо разработчики питают пристрастие к одной из конкурирующих технологий, игнорируя другую.

В целом видеокарты с двумя GPU уже доказали право на существование на самом верху модельных рядов NVIDIA и AMD. Между тем разъемы SLI и CrossFireX теперь устанавливают даже на слабенькие по меркам геймеров адаптеры вроде Radeon HD 7770 и GeForce GTX 650 Ti BOOST. И каждый раз, когда в руки попадает очередная дешёвая видеокарта с поддержкой SLI или CrossFireX, возникает желание проверить — а как себя ведет пара таких малышек? С одной стороны, интерес чисто академический. Процессоры в геймерских видеокартах младшего эшелона по числу функциональных блоков представляют собой приблизительно половинки от топовых GPU. Вот вам еще один способ протестировать эффективность технологий, распараллеливающих вычислительную нагрузку между двумя GPU, — попытаться получить из двух половинок производительность, близкую к 100% результата топового процессора.

⇡ А оно нам надо?

Но попробуем найти в таком эксперименте и долю практической пользы. В теории тандем слабых видеокарт может стать более выгодной покупкой, чем один топовый адаптер. Старшими моделями AMD ныне являются бессменный Radeon HD 7970 и его разогнанный собрат HD 7970 GHz Edition. Среди продукции NVIDIA аналогичной парочкой можно считать GeForce GTX 680 и GTX 770. Ну а на роль их приблизительных половинок подходят Radeon HD 7790 и HD 7850 (для AMD), GTX 650 Ti BOOST и GTX 660 (для NVIDIA).

Сопоставим розничные цены этих моделей. Radeon HD 7790 со стандартным объемом памяти 1 Гбайт в московских интернет-магазинах можно купить за сумму от 4 100 рублей, HD 7850 2 Гбайт — за 4 800 рублей. В то же время Radeon HD 7970 продается по цене от 9 800 рублей, что лишь на 200 рублей дороже, чем пара HD 7850. Но вот HD 7970 GHz Edition уже трудно найти менее чем за 14 000 рублей.

Таким образом, CrossFireX на двух недорогих карточках AMD кажется сомнительной затеей хотя бы потому, что Radeon HD 7850, хоть и является половинкой HD 7970 по числу активных вычислительных блоков в GPU, существенно уступает последнему по тактовой частоте ядра и памяти. HD 7790 крутит процессор на частоте 1 ГГц, что отчасти компенсирует его более скромную конфигурацию по сравнению с HD 7850, но слабым местом HD 7790 является 128-битная шина памяти, а главное — её объем в 1 Гбайт, что обязательно скажется на производительности в тяжелых графических режимах (а именно для них мы и собираем такой тандем).

С точки зрения чистого эксперимента, не обремененного финансовыми соображениями, по конфигурации вычислительных блоков и частоты GPU совокупная мощь пары младших адаптеров AMD, способных работать в режиме CrossFireX (Radeon HD 7770 в расчет не берем, сборка из двух таких — это было бы совсем нелепо), немного не достает до флагманской отметки. Не будем забывать это обстоятельство, обсуждая результаты бенчмарков. Впрочем, в пользу пары HD 7850 играет 256-битная шина памяти — то, что NVIDIA не может предложить в этом ценовом сегменте.

| Модель | Radeon HD 7790 | Radeon HD 7850 | HD 7970 | HD 7970 GHz Edition |

|---|---|---|---|---|

| Основные компоненты | ||||

| GPU | Bonaire | Pitcairn Pro | Tahiti XT | Tahiti XT |

| Число транзисторов, млн | 2080 | 2800 | 4313 | 4313 |

| Техпроцесс, нм | 28 | 28 | 28 | 28 |

| 1000/НД | 860/НД | 925/НД | 1000/1050 | |

| Потоковые процессоры | 896 | 1024 | 2048 | 2048 |

| Текстурные блоки | 56 | 64 | 128 | 128 |

| ROP | 16 | 32 | 32 | 32 |

| GDDR5, 1024 | GDDR5, 2048 | GDDR5, 3072 | GDDR5, 3072 | |

| Ширина шины памяти, бит | 128 | 256 | 384 | 384 |

| 1500 (6000) | 1200 (4800) | 1375 (5500) | 1500 (6000) | |

| Интерфейс | PCI-Express 3.0 x16 | |||

| Вывод изображения | ||||

| Интерфейсы | 1 х DL DVI-I, 1 x DL DVI-D, 1 x HDMI 1.4a, 1 x DisplayPort 1.2 | 1 х DL DVI-I, 1 x HDMI 1.4a, 2 x Mini DisplayPort 1.2 |

||

| Макс. разрешение | VGA: 2048x1536, DVI: 2560x1600, HDMI: 4096х2160, DP: 4096х2160 |

|||

| 85 | 130 | 250 | 250+ | |

| Средняя розничная цена, руб. | 4 100 | 4 800 | 9 800 | 14 000 |

Расклад цен среди видеокарт NVIDIA более благоприятен для сборки тандема из двух SKU небольшой производительности по сравнению с единственным мощным адаптером. GeForce GTX 650 Ti BOOST можно купить по цене начиная с 5 200 рублей, GeForce GTX 660 — за 5 800 рублей. Обе — с двумя гигабайтами набортной памяти. В то же время цены на GeForce GTX 680 и новоприбывший GTX 770, который является фактически обновленной версией GTX 680, начинаются с 13 000 рублей. По спецификациям GTX 650 Ti BOOST — самый младший графический ускоритель в ассортименте NVIDIA, поддерживающий SLI, — соответствует половинке GTX 680 (GTX 770) и даже располагает большим числом ROP, только работает на более низких частотах. GTX 660, при равной с GTX 650 Ti BOOST частоте, более плотно укомплектован ядрами CUDA и текстурными блоками. Обе модели обременяет относительно узкая 192-битная шина памяти.

| Модель | GeForce GTX 650 Ti BOOST | GeForce GTX 660 | GTX 680 | GTX 770 |

|---|---|---|---|---|

| Основные компоненты | ||||

| GPU | GK106 | GK106 | GK104 | GK104 |

| Число транзисторов, млн | 2 540 | 2 540 | 3 540 | 3 540 |

| Техпроцесс, нм | 28 | 28 | 28 | 28 |

| Тактовая частота GPU, МГц: Base Clock / Boost Clock | 980/1033 | 980/1033 | 1006/1058 | 1046/1085 |

| Потоковые процессоры | 768 | 960 | 1536 | 1536 |

| Текстурные блоки | 64 | 80 | 128 | 128 |

| ROP | 24 | 24 | 32 | 32 |

| Видеопамять: тип, объем, Мбайт | GDDR5, 1024/2048 | GDDR5, 2048 | GDDR5, 2048 | GDDR5, 2048 |

| Ширина шины памяти, бит | 1502 (6008) | 1502 (6008) | 1502 (6008) | 1753 (7010) |

| Тактовая частота памяти: реальная (эффективная), МГц | 192 | 192 | 256 | 256 |

| Интерфейс | PCI-Express 3.0 x16 | |||

| Вывод изображения | ||||

| Интерфейсы | 1 х DL DVI-I, 1 x DL DVI-D, 1 x HDMI 1.4a, 1 x DisplayPort 1.2 |

|||

| Макс. разрешение | - | - | - | - |

| Типичная потребляемая мощность, Вт | 140 | 140 | 195 | 230 |

| Средняя розничная цена, руб. | 5 200 | 5 800 | 13 000 | 13 000 |

⇡ Обманчивые гигабайты

Существенную проблему в любых конфигурациях с множественными GPU составляет объем памяти видеоадаптеров. Дело в том, что ОЗУ индивидуальных видеокарт не складывается в один большой массив. Вместо этого их содержимое дублируется. Таким образом, даже если совокупная вычислительная способность двух «обрезанных» GPU сопоставима с мощью единственного флагманского ядра, тандем располагает кадровым буфером в размере памяти одной карты. А тяжелые графические режимы, знаете ли, бывают чрезвычайно требовательными к объему памяти. Возьмем игры, известные своей жаждой дополнительных мегабайтов, которые мы используем в качестве бенчмарков . Metro 2033 при разрешении 2560х1440 с максимальными настройками оккупирует до 1,5 Гбайт RAM, Far Cry 3 — 1,7, а Crysis 3 — почти 2 Гбайт.

Ну а поскольку именно для таких игр и таких настроек мы и готовы прибегнуть к столь странному решению, как две относительно бюджетные карты в конфигурации SLI/CrossFireX, то видеоадаптеры с объемом RAM меньше 2 Гбайт нам подходят плохо. В этом плане немного больше повезло продуктам NVIDIA, поскольку даже GeForce GTX 650 Ti BOOST, согласно официальным спецификациям, поставляется в разновидности с 2 Гбайт памяти, не говоря уж о GTX 660. Кроме того, даже GTX 680 имеет не больше памяти (только для GTX 770 допустимы версии с 4 Гбайт GDDR 5).

Radeon HD 7790 задуман как адаптер исключительно с 1 Гбайт памяти, хотя партнеры AMD и производят модели с удвоенным кадровым буфером по собственной инициативе. Версия HD 7850 с 1 Гбайт памяти в связи с появлением HD 7790, напротив, официально прекратила существование. И главное, флагман-то, Radeon HD 7970 GHz Edition, комплектуется 3 Гбайт памяти — в полтора раза больше, чем у «середнячков» от AMD.

А вообще — прекратим гадать. Честное слово, производительность сборки двух геймерских видеокарт средней категории в SLI или CrossFireX трудно предсказать на основании голой теории. Нужно тестировать, и мы готовы к любым неожиданностям. Но прежде чем перейти к практической работе, обсудим еще один аспект нашего экзотического проекта — энергопотребление. Если исходить из типичной мощности адаптеров AMD, тандем HD 7850 не должен потреблять намного больше энергии, чем единственный Radeon HD 7970: 2х130 против 250 Вт соответственно. Сборка HD 7790 еще более экономична: это дважды по 85 Вт.

Сопоставимые по производительности карты NVIDIA более прожорливы. GeForce GTX 650 Ti BOOST и GTX 660 обладают одинаковым TDP — 140 Вт. В паре такие адаптеры намного превосходят GeForce GTX 680 (195 Вт) и даже GTX 770 (230 Вт).

⇡ Участники тестирования

Наша задача — собрать четыре двухпроцессорные конфигурации: на базе GeForce GTX 650 Ti BOOST и GeForce GTX 660, с одной стороны, и на Radeon HD 7790 и HD 7850 — с другой, а затем сравнить их производительность с производительностью мощных адаптеров на одном GPU.

- 2 x GeForce GTX 660 (980/6008 МГц, 2 Гбайт)

- 2 x GeForce GTX 650 Ti BOOST (980/6008 МГц, 2 Гбайт)

- 2 x Radeon HD 7850 (860/4800 МГц, 2 Гбайт)

- 2 x Radeon HD 7790 (1000/6000 МГц, 1 Гбайт)

А эти модели были выбраны в качестве конкурентов:

- AMD Radeon HD 7970 GHz Edition (1050/6000 МГц, 3 Гбайт)

- AMD Radeon HD 7970 (925/5500 МГц, 3 Гбайт)

- AMD Radeon HD 7950 (800/5000 МГц, 3 Гбайт)

- NVIDIA GeForce GTX 780 (863/6008 МГц, 3 Гбайт)

- NVIDIA GeForce GTX 770 (1046/7012 МГц, 2 Гбайт)

- NVIDIA GeForce GTX 680 (1006/6008 МГц, 2 Гбайт)

- NVIDIA GeForce GTX 670 (915/6008 МГц, 2 Гбайт)

⇡ Участники тестирования, подробно

Большинство из карт в многопроцессорных сборках предоставлены для тестирования партнерами NVIDIA, и отличаются от адаптеров референсного дизайна по тактовым частотам. Для чистоты исследования их пришлось привести к референсным спецификациям. Впрочем, проявляя уважение к труду производителей, ниже кратко перечислим достоинства каждого из участников тестирования.

- AMD Radeon HD 7850

- ASUS GeForce GTX 650 Ti BOOST DirectCU II OC (GTX650TIB-DC2OC-2GD5)

- ASUS Radeon HD 7790 DirectCU II OC (HD7790-DC2OC-1GD5)

- Gainward GeForce GTX 650 Ti BOOST 2GB Golden Sample (426018336-2876)

- GIGABYTE Radeon HD 7790 (GV-R779OC-1GD)

- MSI GeForce GTX 660 (N660 TF 2GD5/OC)

- ZOTAC GeForce GTX 660 (ZT-60901-10M)

ASUS GeForce GTX 650 Ti BOOST DirectCU II OC (GTX650TIB-DC2OC-2GD5)

ASUS прислала нам немного разогнанную версию GeForce GTX 650 Ti BOOST 2 Гбайт с базовой частотой ядра, увеличенной на 40 МГц по сравнению с референсной спецификацией. На плату установлена хорошо знакомая система охлаждения DirectCU II, которая включает тепловые трубки, напрямую контактирующие с кристаллом GPU. Отсюда и название DirectCU. Вот только, в отличие от более дорогих моделей, в кулере GTX 650 Ti BOOST теплотрубок всего две штуки, а не три.

Gainward GeForce GTX 650 Ti BOOST 2GB Golden Sample (426018336-2876)

Gainward также производит разогнанную версию GeForce GTX 650 Ti BOOST с тем отличием от реализации ASUS, что базовая частота GPU увеличена лишь на 26 МГц, зато есть прибавка в 100 МГц к результирующей частоте видеопамяти. Кулер видеокарты также принадлежит к открытому типу и содержит две медные теплотрубки.

MSI GeForce GTX 660 (N660 TF 2GD5/OC)

GeForce GTX 660 в исполнении MSI оснащен солидной системой охлаждения Twin Frozr III уже с тремя тепловыми трубками. Базовую тактовую частоту GPU производитель увеличил на 53 МГц относительно референсного значения, не коснувшись частоты видеопамяти.

ZOTAC GeForce GTX 660 (ZT-60901-10M)

Эта видеокарта уже засветилась на 3DNews в изначальном тестировании GeForce GTX 660. Имеется небольшой разгон графического процессора: с базовой частоты 980 до 993 МГц. Система охлаждения представляет собой конструкцию открытого типа с двумя тепловыми трубками и медной пластиной в основании.

AMD Radeon HD 7850

Это на сто процентов референсный видеоадаптер, предоставленный самой компанией AMD. Соответственно, частоты ядра и памяти с точностью до мегагерца соответствуют эталонным. В отличие от всех остальных участников тестирования, референсный Radeon HD 7850 оснащен турбинным кулером. Радиатор имеет медную подошву и пронизан тремя тепловыми трубками.

ASUS Radeon HD 7790 DirectCU II OC (HD7790-DC2OC-1GD5)

Оверклокерская версия Radeon HD 7790 от ASUS разогнана на 75 МГц по частоте процессора и на 400 МГц — по видеопамяти. В целом GPU производства AMD допускают больший заводской разгон по сравнению с аналогами от NVIDIA. Система охлаждения карты аналогична таковой у вышеописанного ASUS GeForce GTX 650 Ti BOOST DirectCU II OC. Это упрощенный вариант кулера DirectCU II с двумя тепловыми трубками, прижатыми к кристаллу GPU.

GIGABYTE Radeon HD 7790 (GV-R779OC-1GD)

Эта карточка по конфигурации похожа на Radeon HD 7990 от ASUS: GPU работает на такой же частоте 1075 МГц, а вот частота памяти оставлена на уровне стандартных 6000 МГц. Кулер представляет собой простейшую конструкцию, образованную цельным алюминиевым радиатором и большой вертушкой. Ни теплотрубками, ни дополнительной металлической подошвой радиатора адаптер GIGABYTE похвастаться не может.

Экстенсивность и интенсивность – вот два ключевых понятия развития прогресса человечества. Экстенсивный и интенсивный пути развития общества, технологий, да и всего человечества в целом сменяли друг друга на протяжении многих веков. Примеров тому много во всех сферах хозяйственной деятельности. Но земледелие и скотоводство нас сегодня не интересуют, нас интересуют информационные технологии и компьютеры. Для примера, кратко рассмотрим развитие центральных процессоров.

Не будем углубляться в далекие 80-90-е, начнем сразу с Pentium 4. После продолжительного интенсивного развития технологии NetBurst, наращивания «стероидных» мегагерц, индустрия уперлась в стену – дальше «разгонять» одноядерные процессоры оказалось очень сложно и, что бы получить еще более мощный процессор, необходимы большие затраты. И тогда появились двухъядерные процессоры – экстенсивное решение проблемы. Вскоре и они перестали обеспечивать нужную производительность, и появляется новая архитектура Core, которая при меньших тактовых частотах дает большую производительность – интенсивное решение проблемы. И так будет продолжаться далее.

А что же происходит с развитием второго компонента, немаловажного для любителя зрелищных игр на ПК – видеокартой? А происходит тоже самое, что и с процессорами. На данном этапе развития, одночиповые видеокарты уже не могут обеспечить требуемую производительность. Поэтому обе лидирующие компании рынка видеокарт (NVIDIA и AMD) разрабатывают и активно внедряют собственные технологии увеличение производительности видеосистемы путем объединения двух, трех, и даже четырех видеокарт в одном ПК. В данной статье мы рассмотрим первую компанию (так как именно она представила свою разработку первой) NVIDIA и ее технологию SLI.

Что такое технология SLI?

Технология NVIDIA SLI - это революционный подход к масштабированию графической производительности путем объединения нескольких видеокарт NVIDIA в одной системе.

История

В 1998 году компания 3dfx представила графический процессор Voodoo2, среди прочих нововведений которого была технология SLI (англ. Scan Line Interleave - чередование строчек), которая предполагала совместную работу двух чипов Voodoo2 над формированием изображения. С технологией SLI могли работать даже карты различных производителей, а также карты с разным объёмом памяти. SLI-система позволяла работать с разрешением до 1024x768, что в то время казалось невероятным. Недостатками SLI от 3dfx были высокая стоимость ускорителей ($600) и большое тепловыделение. Однако вскоре видеокарты переходят с шины PCI на более быстрый выделенный графический AGP-порт. Так как на материнских платах этот порт был только один, то выпуск видеокарт с поддержкой SLI на время прекратился.

В 2000 году с выпуском нового чипа VSA-100 3dfx удалось реализовать SLI на AGP, но на этот раз в рамках одной платы, на которой размещались два или четыре таких чипа.

Однако платы на базе SLI-системы обладали большим энергопотреблением и выходили из строя из-за проблем с электропитанием. На весь мир плат Voodoo5 6000 было продано около 200 штук, причем реально рабочими из них оказались лишь 100. Столь неудачное продвижение многообещающего ускорителя, в который были вложены очень большие средства, привели фактически к банкротству компании. В 2001 году NVIDIA покупает 3dfx за 110 млн. долларов.

В 2004 году с выходом первых решений на базе новой шины PCI Express NVIDIA объявляет о поддержке в своих продуктах технологии мультичиповой обработки данных SLI, которая расшифровывается уже по-другому - Scalable Link Interface (масштабируемый интерфейс).

![]()

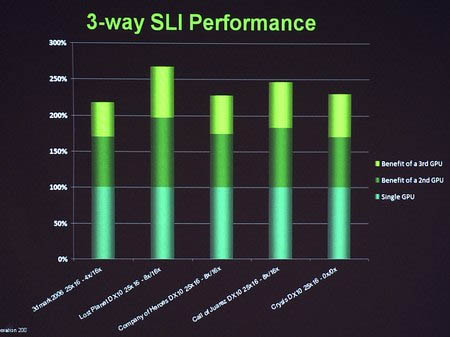

Поначалу продвижение технологии SLI шло не очень гладко, в первую очередь из-за постоянно выявляемых недоработок в драйверах, а также из-за необходимости «затачивать» их под каждое конкретное приложение, а иначе игрок не получал никакой пользы от покупки пары ускорителей. Но сменялись поколения ускорителей, дорабатывались драйвера, расширялся список поддерживаемых игр. И вот, в конце 2007 года была введена в эксплуатацию технология Triple SLI, позволяющая объединять в связке 3 видеокарты NVIDIA:

![]()

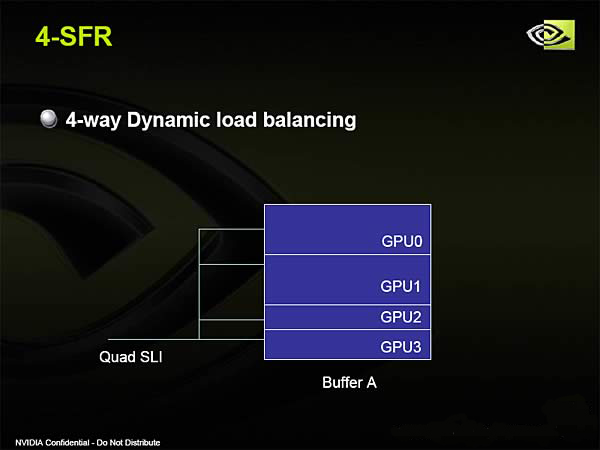

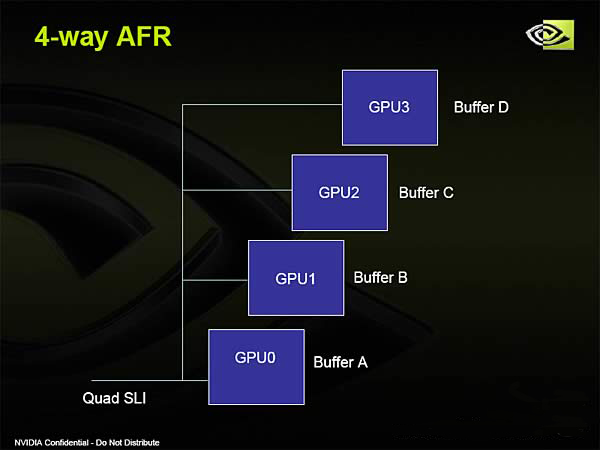

Производитель обещает прирост производительности до 250% по сравнению с одиночным чипом. Но и это не стало пределом, сейчас на очереди уже Quad SLI, позволяющая заставить работать над визуализацией игровой сцены уже 4 GPU, правда, в составе пары двухчиповых видеокарт.

Алгоритмы построения изображений

Split Frame Rendering

Схема алгоритма Split Frame Rendering

Это часто используемый режим, когда изображение разбивается на несколько частей, количество которых соответствует количеству видеокарт в связке. Каждая часть изображения обрабатывается одной видеокартой полностью, включая геометрическую и пиксельную составляющие. (Аналог в CrossFire - алгоритм Scissor )

Алгоритм Split Frame Rendering легко масштабируется на 3, 4, а в будущем, возможно, и на большее чило графических процессоров.

Alternate Frame Rendering

Схема алгоритма Alternate Frame Rendering

Обработка кадров происходит поочередно: одна видеокарта обрабатывает только четные кадры, а вторая - только нечетные. Однако у этого алгоритма есть недостаток. Дело в том, что один кадр может быть простым, а другой сложным для обработки. К тому же этот алгоритм, запатентован ATI во время выпуска двухчиповой видеокарты.

В технологии Quad SLI используется и гибридный режим, который объединяет в себе SFR и AFR.

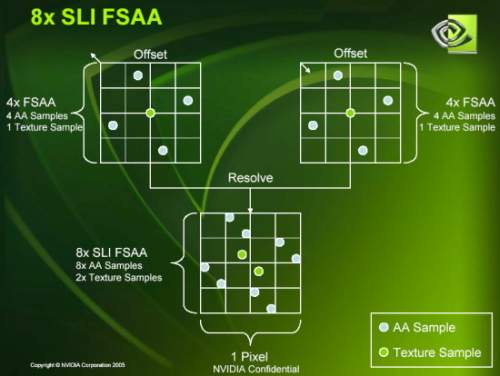

SLI AA (Anti Aliasing), SLI FSAA (Full Scene Anti Aliasing)

Данный алгоритм нацелен на повышение качества изображения. Одна и та же картинка генерируется на всех видеокартах с разными шаблонами сглаживания. Видеокарта производит сглаживание кадра с некоторым шагом относительно изображения другой видеокарты. Затем полученные изображения смешиваются и выводятся. Таким образом, достигается максимальные четкость и детализация изображения. Доступны следующие режимы сглаживания: 8x, 10x, 12x, 14x, 16x и 32x. (Аналог в CrossFire - SuperAA )

Принципы построения

Для построения компьютера на основе SLI необходимо иметь:

- материнскую плату с двумя и более разъемами PCI Express, поддерживающую технологию SLI (как правило, в названии материнской платы присутствует слово SLI).

- Достаточно мощный блок питания (обычно рекомендуется от 550 Вт);

- видеокарты GeForce 6/7/8/9/GTX или Quadro FX с шиной PCI Express;

- мост, объединяющий видеокарты.

При этом отметим, что поддержка чипсетов для работы со SLI осуществляется программно, а не аппаратно. Но видеокарты должны принадлежать к одному классу, при этом версия BIOS плат и их производитель значения не имеют.

На данный момент, технология SLI поддерживается следующими операционными системами:

- Windows XP 32-bit

- Windows XP 64-bit

- Windows Vista 32-bit

- Windows Vista 64-bit

- Linux 32-bit

- Linux 64-bit (AMD-64/EM64T)

SLI-систему можно организовать двумя способами:

- С помощью специального мостика;

- Программным путем.

В последнем случае нагрузка на шину PCIe возрастает, что плохо сказывается на производительности, поэтому широкого распространения этот способ не получил. Такой режим может быть использован только с относительно слабыми ускорителями.

Если мост SLI не установлен, то драйвер выдаёт предупреждение, что режим SLI будет работать не в полную силу.

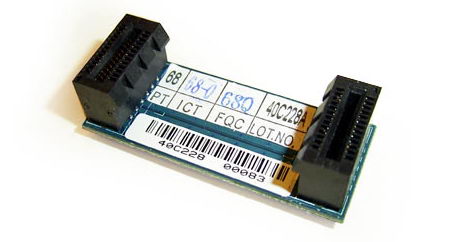

Например, вот так может выглядеть специальный мостик для соединения видеокарт, если он выполнен на текстолите. Кроме того сейчас получили распространение и гибкие мосты, как более дешевые в производстве. Но для активации технологии 3-Way SLI используется пока только жесткий специальный мост, который фактически вмещает в себя три обычных в «кольцевом» режиме.

Как было сказано выше, популяризируется и система Quad SLI. Она предполагает объединение в единую систему двух двухчиповых плат. Таким образом, получается, что в построении изображения участвуют 4 чипа, однако это пока удел заядлых энтузиастов и для обычных пользователей практического значения не имеет.

Для простого пользователя важно другое, то, ради чего собственно и задумывалась данная технология. Покупая материнскую плату с поддержкой SLI, вы делаете хороший задел для модернизации ПК в будущем, так как она предоставляет возможность добавления еще одной видеокарты. Никакой другой способ «апгрейда», кроме полной смены системы, даже близко не дает тот прирост игровой производительности, который обеспечивает вторая видеокарта.

Выглядит это приблизительно так. Вы покупаете хороший ПК с хорошей современной видеокартой. Спокойно играете в современные игры, но через год-полтора ваша система уже не может удовлетворить Вас качеством изображения и скоростью в последних играх. Тогда Вы вместо замены старой видеокарты (или даже всего ПК) просто добавляете еще одну и получаете почти удвоенную мощность видеосистемы.

Однако, так просто звучит все в теории. А вот на практике пользователю придется столкнуться с множеством трудностей.

Первая – это сами игры и приложения. От страшного слова «оптимизация» никто еще не придумал лекарства – да, не только драйверы, но и игры должны быть оптимизированы для технологии SLI, чтобы корректно с ней работать. NVIDIA заявляет, что технология SLI поддерживает «самый длинный список игр ». Если интересующей вас игры нет в списке, компания предлагает создать собственный профиль настроек для нее.

К сожалению, все еще остается очень много игр, не совместимых с SLI, и создание профиля никак это не исправляет. Выход один – ждать патчей от разработчиков игр и новых драйверов от компании NVIDIA. Однако к этим играм относятся в основном старые, с которыми без проблем справляется и одиночная современная видеокарта, или мало популярные, которые подавляющему большинству игроков не интересны вследствие плохой «играбельности». А вот новые мощные игры уже заранее предусматривают использование двух видеокарт. К примеру, в игре Call of Duty 4 в разделе настроек графики есть вполне конкретный переключатель.

О включении функции SLI Вы можете узнать по специальным индикаторам прямо в игре, при соответствующей «тестовой» настройке драйвера.

Если на экране монитора Вы видите горизонтальные или вертикальные зеленые полосы, это означает, что режим «Показывать визуальные индикаторы SLI» включен в панели управления NVIDIA Display. При включении этой опции можно увидеть, как распределяется графическая нагрузка на GPU, а названия SLI компонентов в Вашей системе будут изменены: SLI для двух GPU будет назван “SLI”, название 3-way NVIDIA SLI будет заменено на “SLI x3”, а Quad SLI будет назван “Quad SLI”. Для игр, при визуализации которых используется технология Alternate Frame Rendering (AFR), вертикальная зеленая полоса будет расти либо уменьшаться в зависимости от масштаба расширения. Для игр, при визуализации которых используется технология Split-Frame Rendering (SFR), горизонтальная зеленая полоса будет подниматься и опускаться, показывая, как распределяется нагрузка между всеми GPU. Если уровень детализации верхней и нижней половины экрана одинаков, то горизонтальная полоса будет находиться близко к середине. Для того чтобы включить или отключить эту возможность, просто откройте панель управления NVIDIA и выберите «Настройки 3D».

Второй распространенной проблемой вычислений несколькими графическими чипами является синхронизация последних. Как было сказано выше, метод рендеринга AFR имеет одну особенность: один кадр может быть простым, а другой сложным для обработки. При большой разности в сложности обработки кадра одна видеокарта может намного быстрей его обработать, чем вторая. Это приводит к «микролагам» – маленькие задержки изображения, как бы рывки, но при этом общее число FPS выглядит комфортным. Такой эффект появляется довольно редко, но вот как бороться с ним не знают даже разработчики. Для пользователя есть простой выход – в играх, где наблюдаются «микролаги» с методом AFR переходить на метод SFR, указав его в профиле игры.

В режиме SFR дисплей разбит на две части. Первая карта выдаёт верхнюю часть картинки, а вторая - нижнюю. Благодаря динамической балансировке нагрузки драйвер равномерно распределяет нагрузку между двумя картами.

Третья проблема – это процессор. Дело в том, что при использовании нескольких видеоадаптеров нагрузка на процессор возрастает не только за счет использования тяжелых графических режимов, но и за счет синхронизации видеочипов. Поэтому, для того, чтобы раскрыть весь потенциал связки из нескольких видеокарт вам потребуется мощный процессор. Хотя на сегодняшний день это уже не такой острый вопрос, как пару лет назад.

Дополнительные функции новой технологии

Новое поколение материнских плат и видеокарт с поддержкой SLI предоставляют пользователям намного больше функций, чем обычное ускорение трехмерной графики.

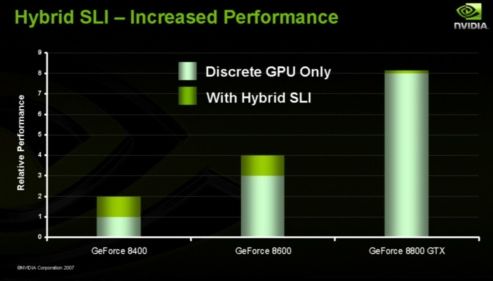

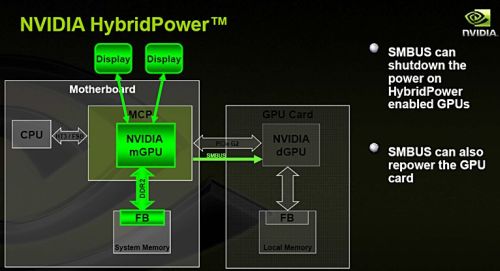

Hybrid SLI предусматривает более рациональное использование режима совместного использования графического ядра, встроенного в чипсет, и дискретной видеокарты.

Технология состоит из двух частей: GeForce Boost и HybridPower .

Первая будет задействована в приложениях, интенсивно работающих с 3D-графикой. С GeForce Boost часть расчетов трёхмерной сцены возьмет на себя ускоритель, интегрированный в набор системной логики, что даст заметную прибавку в производительности тем системам, где установлен не самый быстрый дискретный адаптер, например GeForce 8500 GT или GeForce 8400 GS.

HybridPower же, напротив, позволит использовать встроенную графику, отключая внешний ускоритель, когда пользователь работает в интернет, офисных приложениях или смотрит видео. Наибольшую выгоду, по словам NVIDIA, от данной технологии получат владельцы ноутбуков с выделенной видеокартой, время автономной работы которых заметно возрастет.

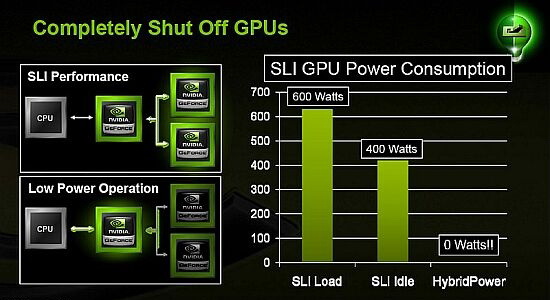

В настоящее время Hybrid SLI поддерживается: настольными GPU GeForce 8500 GT и GeForce 8400 GS для организации GeForce Boost; производительными GeForce GTX 280, GeForce 9800 GX2, GeForce GTX 260, GeForce 9800 GTX+, GeForce 9800 GTX и GeForce 9800 GT в режиме HybridPower; а также системными платами для процессоров AMD на nForce 780a, nForce 750a, nForce 730a (только функция GeForce Boost) со встроенным графическим ускорителем GeForce 8200.

Как видно, экономия электроэнергии может достигать впечатляющих значений.

Очень полезная функция и для оверклокеров, так как она кроме экономии электроэнергии позволяет основной видеокарте «отдохнуть» в момент простоя и продлить ее срок службы, особенно если используется экстремальный разгон.

Еще одной полезной дополнительной особенностью SLI-связки является возможность использования до 4-х мониторов одновременно.

Практическое применение

Мы уже неоднократно тестировали различные видеокарты в режиме SLI. Давайте попробуем немного обобщить полученную информацию.

При подготовке статьи использовалась информация с официального сайта