L'information est la force motrice des entreprises modernes et est actuellement considérée comme l'actif stratégique le plus précieux de toute entreprise. Le volume d'informations augmente de manière exponentielle avec la croissance des réseaux mondiaux et le développement du commerce électronique. Pour réussir dans une guerre de l’information, vous devez disposer d’une stratégie efficace de stockage, de protection, de partage et de gestion des ressources numériques les plus importantes - les données - d’aujourd’hui et dans un avenir proche.

La gestion des ressources de stockage est devenue l'un des problèmes stratégiques les plus brûlants pour le personnel informatique. En raison du développement d'Internet et des changements fondamentaux dans les processus métier, les informations s'accumulent à un rythme sans précédent. Outre le problème urgent de la possibilité d'une augmentation constante de la quantité d'informations stockées, le problème de la fiabilité du stockage des données et de l'accès constant à l'information est également à l'ordre du jour. Pour de nombreuses entreprises, la formule d'accès aux données «24 heures sur 24, 7 jours sur 7, 365 jours par an» est devenue la norme.

Dans le cas d’un PC séparé, un système de stockage (DSS) peut être compris comme un système interne distinct. disque dur ou système de disque. En matière de stockage d'entreprise, il existe traditionnellement trois technologies d'organisation de stockage: le stockage DAS (Direct Attached Storage), le stockage NAS (Network Attach Storage) et le réseau SAN (Storage Area Network).

DAS (Direct Attached Storage)

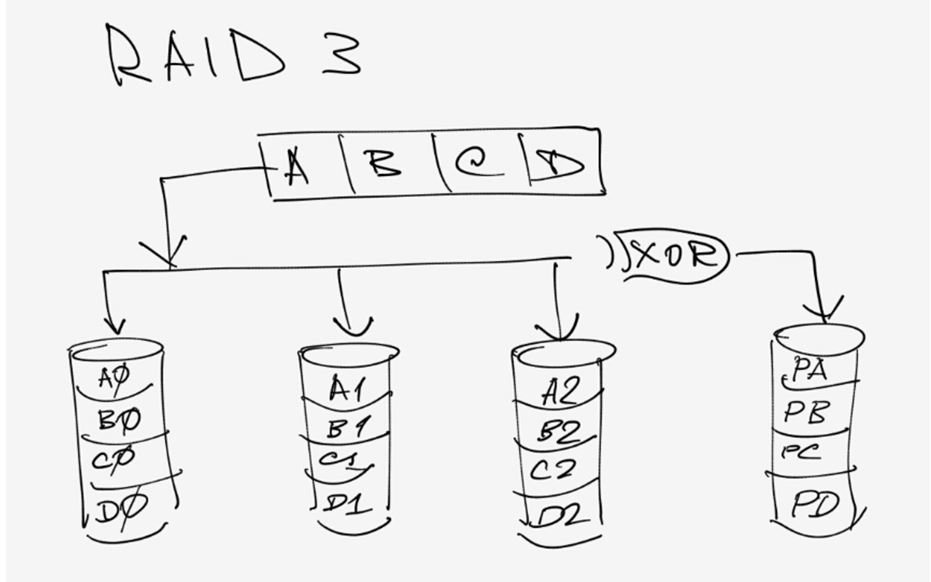

La technologie DAS implique la connexion directe (directe) des lecteurs à un serveur ou à un PC. Dans le même temps, les lecteurs ( disques durs, lecteurs de bande) peuvent être à la fois internes et externes. Le cas le plus simple d’un système DAS est un seul disque dans un serveur ou un PC. De plus, l'organisation d'une grappe de disques RAID interne à l'aide d'un contrôleur RAID peut également être attribuée au système DAS.

Il convient de noter que, malgré la possibilité formelle d'utiliser le terme système DAS en relation avec un seul disque ou une matrice de disques interne, un système DAS est généralement compris comme un rack ou un panier externe avec des disques, qui peut être considéré comme un système de stockage autonome (Fig. 1). Outre une alimentation indépendante, ces systèmes DAS autonomes disposent d'un contrôleur spécialisé (processeur) pour contrôler la matrice de disques. Par exemple, un contrôleur RAID capable d’organiser des matrices RAID de différents niveaux peut jouer le rôle d’un tel contrôleur.

Fig. 1. Exemple de système de stockage DAS

Il convient de noter que les systèmes DAS autonomes peuvent avoir plusieurs canaux d’entrée-sortie externes, ce qui permet de connecter simultanément plusieurs ordinateurs au système DAS.

Les interfaces de connexion de lecteurs (internes ou externes) en technologie DAS peuvent être les interfaces des interfaces SCSI (Small Computer Systems Interface), SATA, PATA et Fibre Channel. Si les interfaces SCSI, SATA et PATA sont principalement utilisées pour la connexion de lecteurs internes, l’interface Fibre Channel est exclusivement utilisée pour la connexion. disques externes et systèmes de stockage autonomes. Dans ce cas, l’avantage de l’interface Fibre Channel est qu’elle n’a pas de limite stricte en longueur et peut être utilisée lorsque le serveur ou le PC connecté au système DAS est très éloigné de celui-ci. Les interfaces SCSI et SATA peuvent également être utilisées pour connecter des systèmes de stockage externes (dans ce cas, l'interface SATA est appelée eSATA), mais ces interfaces sont strictement limitées à la longueur maximale du câble reliant le système DAS et le serveur connecté.

Les principaux avantages des systèmes DAS sont leur faible coût (par rapport à d'autres solutions de stockage), leur facilité de déploiement et d'administration, ainsi que l'échange de données à haute vitesse entre le système de stockage et le serveur. En fait, précisément à cause de cela, ils ont acquis une grande popularité dans le segment des petits bureaux et des réseaux de petites entreprises. Dans le même temps, les systèmes DAS ont leurs propres inconvénients, notamment une mauvaise contrôlabilité et une utilisation non optimale des ressources, car chaque système DAS nécessite la connexion d’un serveur dédié.

Actuellement, les systèmes DAS occupent une position de leader, mais la part des ventes de ces systèmes diminue constamment. Les systèmes DAS sont progressivement remplacés par des solutions universelles offrant la possibilité d'une migration en douceur à partir de systèmes NAS ou offrant la possibilité de les utiliser en tant que systèmes DAS et NAS, voire même de systèmes SAN.

Les systèmes DAS doivent être utilisés lorsque vous devez augmenter espace disque un serveur et le prendre à l'affaire. Il est également recommandé d'utiliser les systèmes DAS pour les stations de travail traitant de grandes quantités d'informations (par exemple, pour les stations de montage vidéo non linéaires).

Stockage en réseau (NAS)

Les systèmes NAS sont des systèmes de stockage réseau qui se connectent directement au réseau de la même manière qu'un serveur d'impression réseau, un routeur ou tout autre périphérique réseau (Figure 2). En fait, les systèmes NAS représentent une évolution des serveurs de fichiers: la différence entre un serveur de fichiers traditionnel et un périphérique NAS est à peu près identique à celle existant entre un routeur réseau matériel et un routeur logiciel basé sur un serveur dédié.

Fig. 2. Exemple de système de stockage NAS

Afin de comprendre la différence entre un serveur de fichiers traditionnel et un périphérique NAS, rappelons qu'un serveur de fichiers traditionnel est un ordinateur dédié (serveur) qui stocke les informations disponibles pour les utilisateurs du réseau. Les disques durs installés sur le serveur peuvent être utilisés pour stocker des informations (en règle générale, ils sont installés dans des paniers spéciaux), ou des périphériques DAS peuvent être connectés au serveur. L'administration du serveur de fichiers est effectuée à l'aide d'un système d'exploitation serveur. Cette approche de l’organisation des systèmes de stockage est actuellement la plus répandue dans le segment des petits réseaux locaux, mais elle présente un inconvénient majeur. Le fait est qu’un serveur universel (et même en combinaison avec un système d’exploitation serveur) n’est pas une solution bon marché. Dans le même temps, la plupart des fonctionnalités inhérentes au serveur universel ne sont tout simplement pas utilisées par le serveur de fichiers. L'idée est de créer un serveur de fichiers optimisé avec un système d'exploitation optimisé et une configuration équilibrée. C'est ce concept que le périphérique NAS incarne. En ce sens, les périphériques NAS peuvent être considérés comme des serveurs de fichiers «légers», ou encore comme des fichiers.

Outre le système d'exploitation optimisé, qui est exempt de toutes les fonctions qui ne sont pas liées à la maintenance du système de fichiers et à la mise en œuvre de l'entrée / sortie des données, les systèmes NAS disposent d'un système de fichiers optimisé pour la vitesse d'accès. Les systèmes NAS sont conçus de telle sorte que toute leur puissance de calcul se concentre exclusivement sur la maintenance des fichiers et les opérations de stockage. Le système d'exploitation lui-même est situé dans une mémoire flash et est pré-installé par le fabricant. Naturellement, à la sortie nouvelle version L'utilisateur du système d'exploitation peut indépendamment "flasher" le système. La connexion de périphériques NAS au réseau et leur configuration sont une tâche assez simple et peuvent être effectuées par tout utilisateur expérimenté, sans parler de l'administrateur système.

Ainsi, par rapport aux serveurs de fichiers traditionnels, les périphériques NAS sont plus productifs et moins coûteux. Actuellement, presque tous les périphériques NAS sont conçus pour une utilisation sur des réseaux Ethernet (Fast Ethernet, Gigabit Ethernet) basés sur les protocoles TCP / IP. L'accès aux périphériques NAS est effectué à l'aide de protocoles d'accès de fichier spéciaux. Les protocoles d'accès aux fichiers les plus courants sont CIFS, NFS et DAFS.

CIFS(Système de fichiers Internet commun - Commun système de fichiers Internet) est un protocole qui permet d’accéder aux fichiers et services sur ordinateurs distants (y compris Internet) et utilise un modèle d’interaction client-serveur. Le client crée une demande d'accès aux fichiers au serveur. Le serveur exécute la demande du client et renvoie le résultat de son travail. Le protocole CIFS est traditionnellement utilisé dans les réseaux locaux avec Windows pour accéder aux fichiers. CIFS utilise le protocole TCP / IP pour transporter les données. CIFS offre des fonctionnalités similaires à FTP (File Transfer Protocol), mais offre aux clients un meilleur contrôle des fichiers. Il permet également le partage de l'accès aux fichiers entre les clients utilisant le blocage et la reconnexion automatique au serveur en cas de défaillance du réseau.

Protocole Nfs (Network File System) est traditionnellement utilisé sur les plates-formes UNIX. Il s'agit d'une collection de systèmes de fichiers distribués et protocole de réseau. Le protocole NFS utilise également un modèle d'interaction client-serveur. Le protocole NFS permet d'accéder aux fichiers d'un hôte distant (serveur) comme s'ils se trouvaient sur l'ordinateur de l'utilisateur. NFS utilise TCP / IP pour transporter les données. Le protocole WebNFS a été développé pour le travail de NFS sur Internet.

Protocole DAFS(Système de fichiers à accès direct - Accès au système de fichiers direct) est un protocole d’accès aux fichiers standard basé sur NFS. Ce protocole permet aux tâches d'application de contourner le système d'exploitation et son espace tampon directement pour transporter des ressources. Le protocole DAFS fournit des vitesses d’E / S de fichier élevées et réduit l’utilisation du processeur en raison d’une réduction significative du nombre d’opérations et d’interruptions généralement nécessaires lors du traitement des protocoles réseau.

DAFS a été conçu pour être utilisé dans un environnement de cluster et serveur pour des bases de données et diverses applications Internet axées sur un fonctionnement continu. Il fournit le moins de temps possible d'accès aux ressources de fichiers partagées et aux données, et prend également en charge des mécanismes de récupération intelligents du système et des données, ce qui le rend attrayant pour une utilisation dans les systèmes NAS.

En résumé, les systèmes NAS peuvent être recommandés pour une utilisation dans des réseaux multiplateformes dans les cas où un accès réseau aux fichiers est requis et où la facilité d’installation de l’administration du système de stockage est un facteur très important. Un bon exemple est l’utilisation du NAS en tant que serveur de fichiers au bureau d’une petite entreprise.

Réseau de stockage (SAN)

En réalité, SAN n'est plus un périphérique séparé, mais une solution complète, une infrastructure réseau spécialisée pour le stockage de données. Les réseaux de stockage sont intégrés en tant que sous-réseaux spécialisés distincts dans un réseau local (LAN) ou global (WAN).

En fait, les réseaux SAN connectent un ou plusieurs serveurs (serveurs SAN) à un ou plusieurs périphériques de stockage. Les SAN permettent à n’importe quel serveur SAN d’accéder à un périphérique de stockage sans charger d’autres serveurs réseau local. De plus, il est possible d'échanger des données entre des périphériques de stockage sans la participation de serveurs. En fait, les réseaux SAN permettent à un très grand nombre d'utilisateurs de stocker et de partager des informations en un seul endroit (avec un accès rapide et centralisé). Des matrices RAID, diverses bibliothèques (bande, magnéto-optique, etc.), ainsi que des systèmes JBOD (matrices de disques non intégrées à RAID) peuvent être utilisés comme périphériques de stockage.

Les réseaux de stockage de données ont commencé à se développer de manière intensive et à être introduits seulement depuis 1999.

Tout comme les réseaux locaux peuvent en principe être construits sur la base de différentes technologies et normes, différentes technologies peuvent également être utilisées pour créer des réseaux de stockage (SAN). Mais tout comme Ethernet (Fast Ethernet, Gigabit Ethernet) est devenu le standard de facto pour les réseaux locaux, le standard Fibre Channel (FC) domine les réseaux de stockage. En réalité, c’est le développement de la norme Fibre Channel qui a conduit au développement du concept même de SAN. Dans le même temps, il convient de noter que le standard iSCSI est en train de devenir de plus en plus populaire et que la construction de réseaux SAN est également possible.

Outre les paramètres de vitesse, l'un des principaux avantages du Fibre Channel est sa capacité à travailler sur de longues distances et la flexibilité de la topologie. Le concept de construction d'une topologie de stockage réseau repose sur les mêmes principes que les réseaux locaux traditionnels basés sur des commutateurs et des routeurs, ce qui simplifie grandement la construction de configurations de systèmes multi-nœuds.

Il convient de noter que les câbles Fibre Channel et Cuivre sont utilisés pour transférer des données dans la norme Fibre Channel. Lors de l'organisation de l'accès à des sites géographiquement distants jusqu'à 10 km, un équipement standard et une fibre optique monomode sont utilisés pour la transmission du signal. Si les nœuds sont espacés d'une plus grande distance (des dizaines voire des centaines de kilomètres), des amplificateurs spéciaux sont utilisés.

Topologie SAN

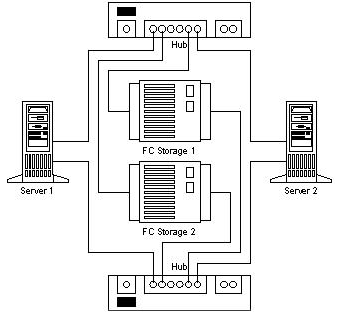

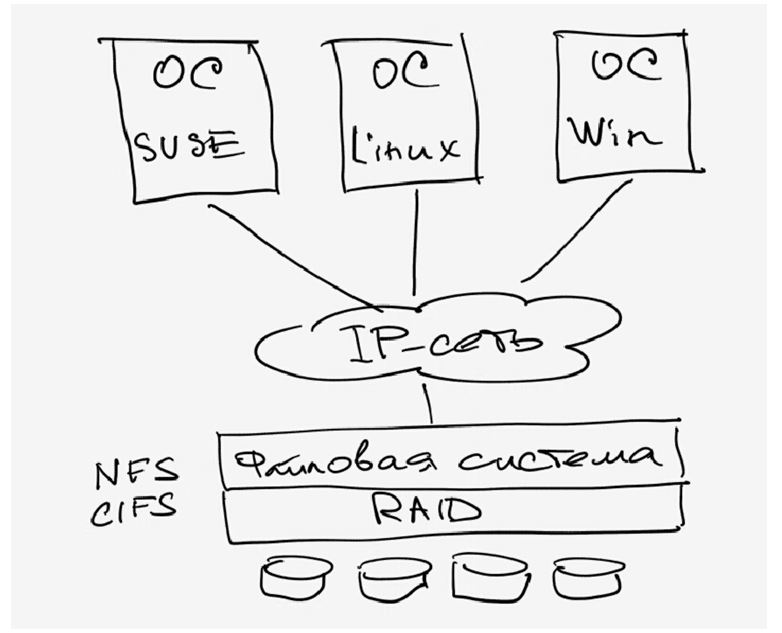

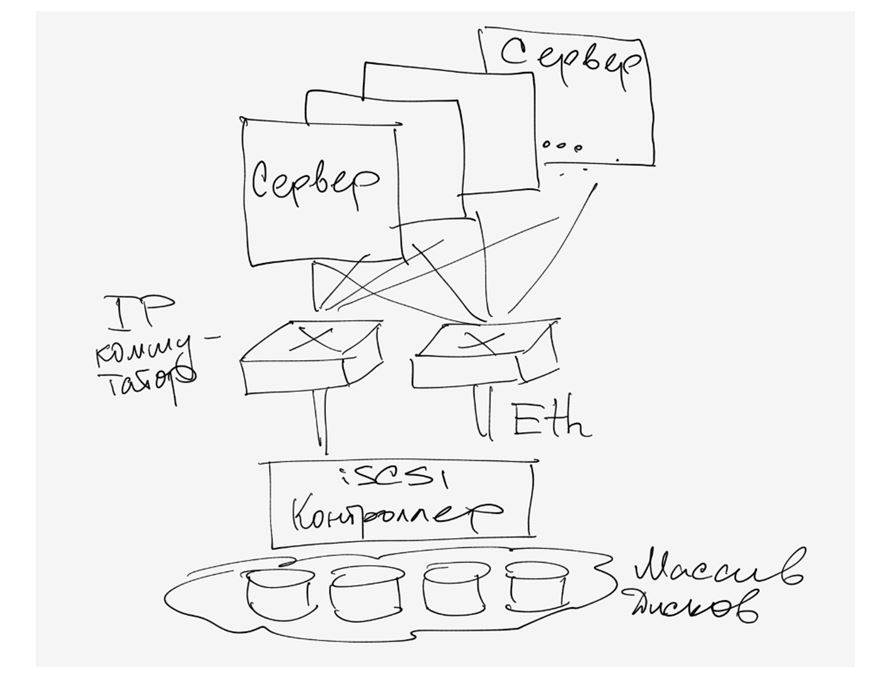

La figure 2 montre une version typique du réseau SAN basée sur la norme Fibre Channel. 3. L'infrastructure d'un tel réseau SAN est constituée de périphériques de stockage dotés d'une interface Fibre Channel, de serveurs SAN (serveurs connectés au réseau local via l'interface Ethernet et au réseau SAN via l'interface Fibre Channel) et d'une matrice de commutation (Fibre Channel Fabric). basé sur des commutateurs Fibre Channel (concentrateurs) et optimisé pour le transfert de gros blocs de données. L'accès des utilisateurs réseau au système de stockage est implémenté via des serveurs SAN. Il est important que le trafic à l'intérieur du réseau SAN soit séparé du trafic IP du réseau local, ce qui, bien entendu, réduit la charge sur le réseau local.

Fig. 3. Conception typique du réseau SAN

Avantages des réseaux SAN

Les principaux avantages de la technologie SAN sont les suivants: hautes performances, haute disponibilité des données, excellente évolutivité et facilité de gestion, capacité de consolidation et de virtualisation des données.

La matrice de commutation Fibre Channel avec une architecture non bloquante permet un accès simultané de plusieurs serveurs SAN aux périphériques de stockage.

Dans l'architecture SAN, les données peuvent facilement être déplacées d'un périphérique de stockage à un autre, ce qui vous permet d'optimiser le placement des données. Cela est particulièrement important lorsque plusieurs serveurs SAN nécessitent un accès simultané aux mêmes périphériques de stockage. Notez que le processus de consolidation des données est impossible dans le cas de l'utilisation d'autres technologies, telles que, par exemple, l'utilisation de périphériques DAS, c'est-à-dire de périphériques de stockage directement connectés aux serveurs.

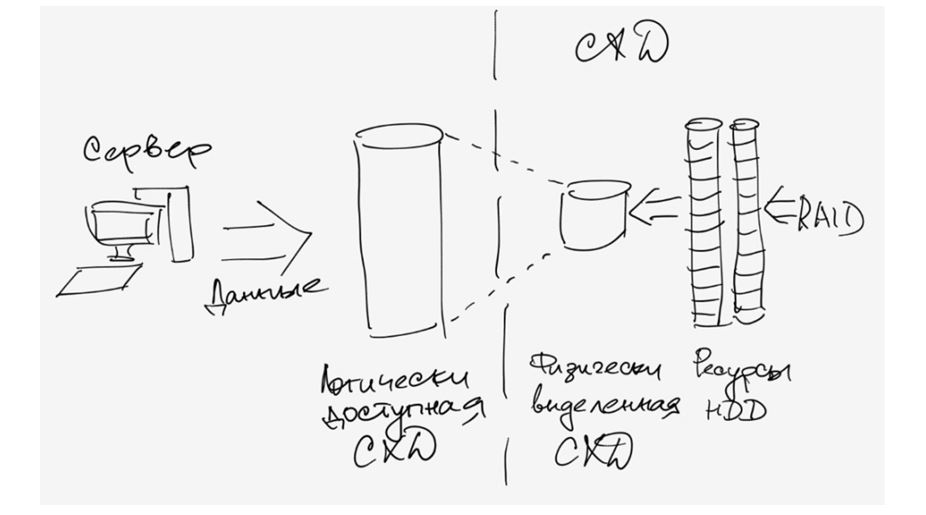

Une autre possibilité offerte par l'architecture SAN est la virtualisation des données. L'idée de la virtualisation est de fournir aux serveurs SAN un accès non pas à des périphériques de stockage individuels, mais à des ressources. Autrement dit, les serveurs doivent "voir" non pas les périphériques de stockage, mais les ressources virtuelles. Pour la mise en œuvre pratique de la virtualisation, un périphérique de virtualisation spécial peut être placé entre les serveurs SAN et les unités de disque, auxquels les périphériques de stockage sont connectés d'un côté et les serveurs SAN de l'autre. En outre, de nombreux commutateurs FC et adaptateurs HBA modernes permettent d’implémenter la virtualisation.

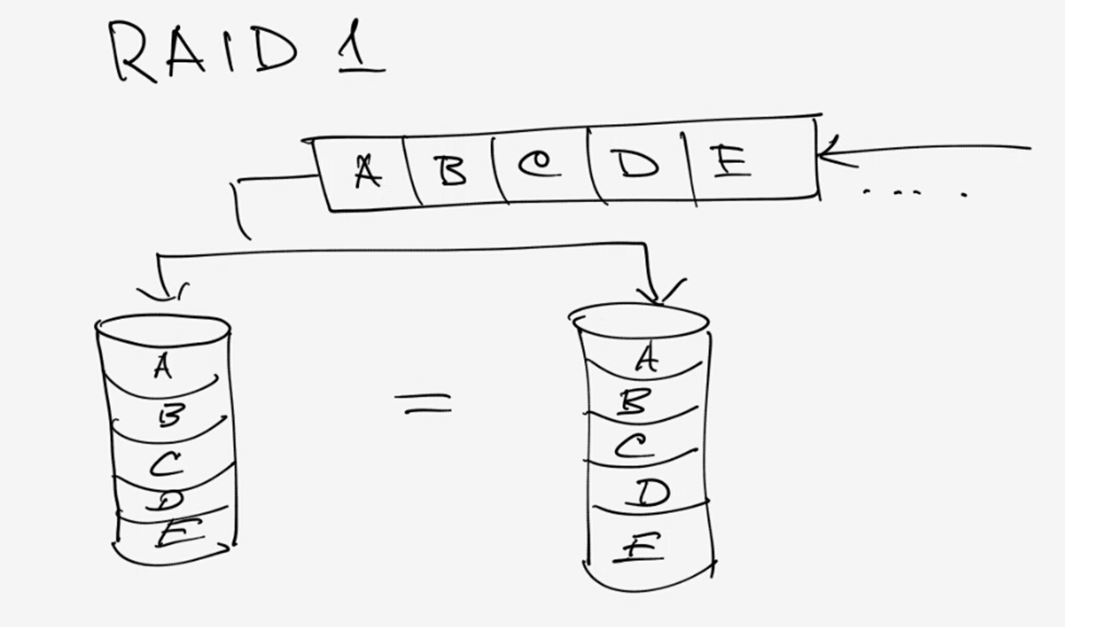

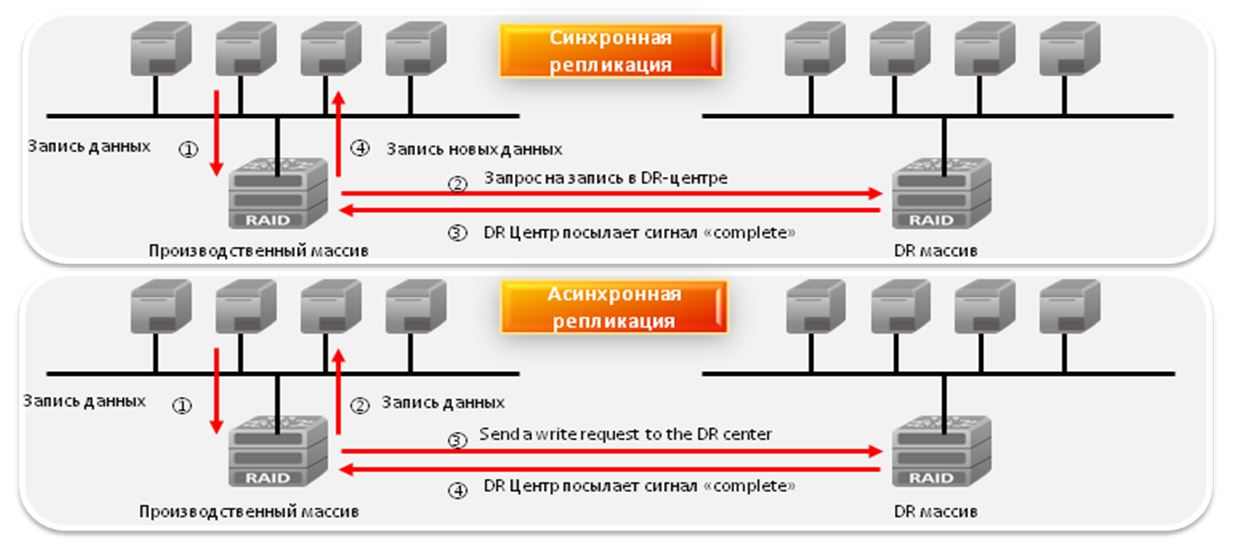

La prochaine opportunité offerte par les réseaux SAN est la mise en œuvre de la mise en miroir de données à distance. Le principe de la mise en miroir des données consiste à dupliquer des informations sur plusieurs supports, ce qui augmente la fiabilité du stockage des informations. Un exemple du cas le plus simple de mise en miroir de données peut être la combinaison de deux disques dans une matrice RAID de niveau 1. Dans ce cas, la même information est enregistrée simultanément sur deux disques. L'inconvénient de cette méthode est l'emplacement local des deux disques (en règle générale, les disques se trouvent dans le même panier ou dans le même rack). Les réseaux de stockage peuvent remédier à cet inconvénient et permettent d'organiser la mise en miroir non pas de périphériques de stockage individuels, mais également des réseaux SAN eux-mêmes, qui peuvent être distants de plusieurs centaines de kilomètres.

Un autre avantage des réseaux SAN est la simplicité d’organisation. sauvegarde données. La technologie de sauvegarde traditionnelle, utilisée dans la plupart des réseaux locaux, nécessite un serveur de sauvegarde dédié et, plus important encore, une bande passante réseau dédiée. En fait, lors d’une opération de sauvegarde, le serveur lui-même devient inaccessible aux utilisateurs du réseau local. En fait, c’est pourquoi la sauvegarde est généralement effectuée la nuit.

L'architecture des réseaux de stockage permet une approche fondamentalement différente du problème de la sauvegarde. Dans ce cas, le serveur de sauvegarde fait partie intégrante du réseau SAN et est connecté directement à la matrice de commutation. Dans ce cas, le trafic de sauvegarde est isolé du trafic du réseau local.

Equipement utilisé pour créer des réseaux SAN

Comme indiqué précédemment, le réseau SAN nécessite des périphériques de stockage, des serveurs SAN et un équipement pour la construction d'une matrice de commutation. Les usines de commutation comprennent à la fois des périphériques de couche physique (câbles, connecteurs) et des périphériques d'interconnexion pour la connexion de nœuds SAN, ainsi que des périphériques de traduction (périphériques de traduction) assurant la conversion d'un protocole Fibre Channel (FC) vers d'autres protocoles, par exemple. SCSI, FCP, FICON, Ethernet, ATM ou SONET.

Câbles

Comme indiqué plus haut, la norme Fibre Channel permet d’utiliser des câbles en cuivre et en fibre optique pour connecter des périphériques SAN. Dans ce cas, différents types de câbles peuvent être utilisés dans le même réseau SAN. Le câble en cuivre est utilisé pour les courtes distances (jusqu'à 30 m) et le câble à fibre optique pour les courtes distances et les distances jusqu'à 10 km et plus. Des câbles à fibres optiques multimode (multimode) et monomode (monomode) sont utilisés, et le multimode est utilisé pour des distances allant jusqu'à 2 km, et monomode pour les longues distances.

La coexistence différents types le câblage au sein d'un réseau SAN est assuré par des convertisseurs d'interface spéciaux GBIC (Gigabit Interface Converter) et MIA (Media Interface Adapter).

La norme Fibre Channel fournit plusieurs vitesses de transmission possibles (voir tableau). Notez qu'actuellement, les normes de périphériques FC les plus courantes sont les normes 1, 2 et 4 GFC. Cela garantit la compatibilité en amont des périphériques haut débit avec des périphériques moins rapides, c'est-à-dire que le périphérique de la norme 4 GFC prend automatiquement en charge la connexion des périphériques des normes 1 et 2 du GFC.

Dispositif d'interconnexion

Fibre Channel permet l’utilisation de diverses topologies de réseau pour la connexion de périphériques, tels que la boucle point-à-point, la boucle arbitrée (FC-AL) et la structure commutée (structure commutée).

Une topologie point à point peut être utilisée pour connecter un serveur à un système de stockage dédié. Dans ce cas, les données ne sont pas partagées avec les serveurs du réseau SAN. En fait, cette topologie est une variante du système DAS.

Pour implémenter une topologie point à point, vous avez besoin au minimum d'un serveur équipé d'un adaptateur Fibre Channel et d'un périphérique de stockage avec une interface Fibre Channel.

La topologie d'un anneau d'accès partagé (FC-AL) implique un schéma de connexion de périphérique dans lequel les données sont transmises sur une boucle fermée de manière logique. Dans la topologie en anneau FC-AL, les concentrateurs ou les commutateurs Fibre Channel peuvent jouer le rôle de périphériques de connectivité. Lors de l'utilisation de concentrateurs, la bande passante est divisée entre tous les nœuds de l'anneau, chaque port de commutateur fournissant la bande passante de protocole pour chaque nœud.

Sur la fig. La figure 4 montre un exemple d'anneau divisé Fibre Channel.

Fig. 4. Exemple d'anneau Fibre Channel avec partage d'accès

La configuration est similaire à une étoile physique et à un anneau logique utilisé dans les réseaux locaux basés sur la technologie Token Ring. De plus, comme dans les réseaux Token Ring, les données circulent dans l’anneau dans un sens. Toutefois, contrairement aux réseaux Token Ring, un périphérique peut demander le droit de transférer des données, au lieu d’attendre qu’un jeton vide sorte du commutateur. Les anneaux d'accès fractionné Fibre Channel peuvent adresser jusqu'à 127 ports. Toutefois, comme le montre la pratique, les anneaux FC-AL classiques contiennent jusqu'à 12 nœuds et, après la connexion de 50 nœuds, les performances chutent considérablement.

La topologie de l'architecture à commutation commutée (Fibre Channel à structure commutée) est implémentée sur la base de commutateurs Fibre Channel. Dans cette topologie, chaque périphérique dispose d'une connexion logique à un autre périphérique. En fait, les commutateurs Fibre Channel de l’architecture de communication remplissent les mêmes fonctions que les commutateurs Ethernet classiques. Rappelons que, contrairement à un concentrateur, un commutateur est un périphérique haute vitesse qui fournit une connexion un à un et gère plusieurs connexions simultanées. Tout nœud connecté à un commutateur Fibre Channel reçoit la bande passante du protocole.

Dans la plupart des cas, lors de la création de grands réseaux SAN, une topologie mixte est utilisée. Au niveau inférieur, des anneaux FC-AL sont utilisés, connectés à des commutateurs peu performants, qui, à leur tour, sont connectés à des commutateurs haute vitesse offrant le débit le plus élevé possible. Plusieurs commutateurs peuvent être connectés les uns aux autres.

Appareils de diffusion

Les périphériques de traduction sont des périphériques intermédiaires qui convertissent le protocole Fibre Channel en protocoles de couche supérieure. Ces périphériques sont conçus pour connecter un réseau Fibre Channel à un réseau WAN externe, un réseau local, ainsi que pour connecter divers périphériques et serveurs au réseau Fibre Channel. Ces périphériques comprennent des ponts (pont), des adaptateurs Fibre Channel (adaptateurs de bus hôte), des routeurs, des passerelles et des adaptateurs réseau. La classification des périphériques de traduction est illustrée à la figure 5.

Fig. 5. Classification des appareils de diffusion

Les périphériques de traduction les plus courants sont les adaptateurs HBA PCI utilisés pour connecter des serveurs au réseau Fibre Channel. Adaptateurs de réseau vous permettent de connecter des réseaux Ethernet locaux à des réseaux Fibre Channel. Les ponts permettent de connecter des périphériques de stockage dotés d'une interface SCSI à un réseau Fibre Channel. Il convient de noter que récemment, presque tous les périphériques de stockage de données destinés à être utilisés dans des réseaux de stockage ont un Fibre Channel intégré et ne nécessitent pas l'utilisation de ponts.

Dispositifs de stockage

Les disques durs et les lecteurs de bande peuvent être utilisés comme périphériques de stockage dans les réseaux SAN. Si on parle de configurations possibles d'utilisation disques durs en tant que périphériques de stockage sur les réseaux SAN, il peut s'agir de baies de disques JBOD ou de baies de disques RAID. Traditionnellement, les périphériques de stockage pour les réseaux SAN se présentent sous la forme de racks ou de paniers externes équipés d'un contrôleur RAID dédié. Contrairement aux périphériques NAS ou DAS, les périphériques pour systèmes SAN sont équipés d'une interface Fibre Channel. Dans le même temps, les disques eux-mêmes peuvent avoir à la fois des interfaces SCSI et SATA.

Outre les périphériques de stockage basés sur des disques durs, les lecteurs de bande et les bibliothèques sont largement utilisés dans les réseaux SAN.

Serveurs SAN

Les serveurs des réseaux de stockage diffèrent des serveurs d'applications classiques par un détail. Outre l'adaptateur réseau Ethernet, ils sont équipés d'un adaptateur HBA pour l'interaction serveur avec le réseau local, ce qui leur permet d'être connectés à des réseaux SAN basés sur Fibre Channel.

Systèmes de stockage Intel

Ensuite, nous examinons quelques exemples spécifiques de périphériques de stockage Intel. Strictement parlant, Intel ne publie pas de solutions complètes et s’engage dans le développement et la production de plates-formes et de composants individuels pour la construction de systèmes de stockage. Sur la base de ces plates-formes, de nombreuses sociétés (y compris un certain nombre de sociétés russes) produisent des solutions déjà complétées et les vendent sous leurs logos.

Système de stockage Intel Entry SS4000-E

Le système de stockage SS4000-E d'Intel Entry System est un périphérique NAS conçu pour les petites et moyennes entreprises et les réseaux multi-plateformes. Lorsque vous utilisez le système de stockage Intel Entry SS4000-E, un accès réseau partagé aux données est obtenu pour les clients basés sur les plates-formes Windows, Linux et Macintosh. En outre, le système de stockage Intel Entry SS4000-E peut faire office de serveur et de client DHCP.

Le système de stockage SS4000-E d'Intel Entry System est un rack externe compact pouvant installer jusqu'à quatre disques SATA (Figure 6). Ainsi, la capacité maximale du système peut atteindre 2 To avec l'utilisation de disques d'une capacité de 500 Go.

Fig. 6. Système de stockage Intel Entry SS4000-E

Le système de stockage Intel Entry SS4000-E utilise un contrôleur RAID SATA prenant en charge les niveaux RAID 1, 5 et 10. Depuis ce système est un périphérique NAS, c’est-à-dire un serveur de fichiers «léger», le système de stockage des données doit disposer d’un processeur spécialisé, d’une mémoire et d’un système d’exploitation cousu. En tant que processeur, Intel Entry Storage System SS4000-E utilise Intel 80219 avec une fréquence d'horloge de 400 MHz. De plus, le système est équipé de 256 Mo mémoire DDR et 32 Mo de mémoire flash pour stocker le système d'exploitation. Le système d'exploitation utilise Linux Kernel 2.6.

Pour vous connecter au réseau local, le système dispose d'un contrôleur de réseau Gigabit à deux canaux. En outre, il existe également deux ports USB.

Le périphérique de stockage SS4000-E du système Entry Entry d'Intel prend en charge les systèmes CIFS / SMB, NFS et FTP, et la configuration du périphérique est mise en œuvre à l'aide d'une interface Web.

En cas d'utilisation de clients Windows (prise en charge du système d'exploitation Windows 2000/2003 / XP), il existe une possibilité supplémentaire d'implémenter des données de sauvegarde et de restauration.

Système de stockage Intel SSR212CC

Le système de stockage Intel SSR212CC est une plate-forme universelle pour la création de systèmes de stockage tels que DAS, NAS et SAN. Ce système est fabriqué dans un boîtier 2 U et est conçu pour être installé dans un rack 19 pouces standard (Fig. 7). Le système de stockage Intel SSR212CC prend en charge jusqu'à 12 disques avec une interface SATA ou SATA II (la fonction de remplacement à chaud est prise en charge), ce qui permet au système d'augmenter sa capacité jusqu'à 6 To à l'aide de disques de 550 Go.

Fig. 7. Système de stockage Intel Storage System SSR212CC

En fait, le système de stockage SSR212CC d'Intel Storage System est un serveur complet hautes performances exécutant les systèmes d'exploitation Red Hat Enterprise Linux 4.0. Microsoft Windows Storage Server 2003, Microsoft Windows Server 2003 Édition Entreprise et Microsoft Windows Server 2003 Édition Standard.

Le serveur est basé sur un processeur Intel Xeon avec une vitesse d'horloge de 2,8 GHz (fréquence FSB 800 MHz, taille du cache L2 de 1 Mo). Le système prend en charge l'utilisation de mémoire sdram DDR2-400 avec un ECC d’une capacité maximale de 12 Go (six emplacements DIMM sont fournis pour l’installation de modules de mémoire).

Le système de stockage Intel SSR212CC est équipé de deux contrôleurs RAID Intel RAID Controller SRCS28X pouvant créer des grappes RAID de niveaux 0, 1, 10, 5 et 50. De plus, le système de stockage SSR212CC d’Intel Storage System dispose d’un contrôleur réseau gigabit à deux canaux.

Système de stockage Intel SSR212MA

Intel Storage System SSR212MA est une plate-forme permettant de créer des systèmes de stockage dans des réseaux IP SAN basés sur iSCSI.

Ce système est fabriqué dans un boîtier 2 U et est conçu pour être installé dans un rack 19 pouces standard. Le système SSR212MA d’Intel Storage System prend en charge l’installation d’un maximum de 12 disques SATA (la fonction de remplacement à chaud est prise en charge), ce qui permet au système d’augmenter sa capacité jusqu’à 6 To avec l’utilisation de disques d’une capacité de 550 Go.

En termes de configuration matérielle, le système de stockage Intel Storage System SSR212MA n'est pas différent du système de stockage Intel Storage System SSR212CC.

SAS, NAS, SAN: une étape vers les réseaux de stockage

Entrée

Avec la complication quotidienne des systèmes informatiques en réseau et des solutions d'entreprise globales, le monde a commencé à demander des technologies qui donneraient une impulsion à la relance des systèmes de stockage d'informations d'entreprise (systèmes de magasin). Ainsi, une seule technologie apporte au trésor mondial des réalisations dans le domaine du stockage, une rapidité sans précédent, une évolutivité énorme et des avantages exceptionnels du coût total de possession. Les circonstances qui ont émergé avec l’avènement du standard FC-AL (Fibre Channel - Arbitrated Loop) et du SAN (Storage Area Network), développé sur cette base, promettent une révolution dans les technologies informatiques orientées données.

"Le développement le plus important en matière de stockage que nous ayons vu depuis 15 ans"

Data Communications International, le 21 mars 1998

Définition formelle du SAN dans l'interprétation de la SNIA (Storage Network Industry Association):

«Un réseau dont la tâche principale est de transférer des données entre des systèmes informatiques et des périphériques de stockage de données, ainsi qu'entre les systèmes de stockage eux-mêmes. Un SAN consiste en une infrastructure de communication fournissant des communications physiques. Il est également responsable de la couche de gestion (couche de gestion), qui intègre les systèmes de communication, de stockage et les systèmes informatiques, assurant le transfert des données de manière sûre et fiable. ”

Dictionnaire technique SNIA, Association de l'industrie du réseau de stockage sous copyright, 2000

Options pour organiser l'accès aux systèmes en veille

Il existe trois options principales pour organiser l’accès aux systèmes de stockage:

- SAS (Server Attached Storage), stocké et connecté au serveur;

- NAS (Network Attached Storage), stockage connecté au réseau;

- SAN (Storage Area Network), réseau de stockage.

Considérons les topologies des systèmes de stockage correspondants et leurs fonctionnalités.

SAS

Système de stockage connecté au serveur. Familier pour tout le monde, la manière traditionnelle de connecter un système de stockage à une interface haut débit sur un serveur est généralement une interface SCSI parallèle.

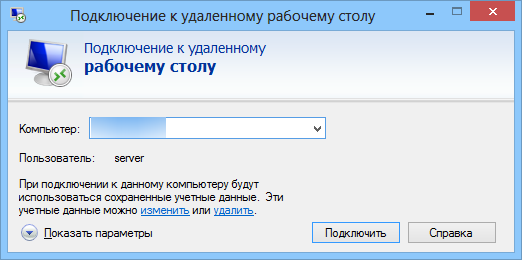

Figure 1. Stockage sur serveur

L'utilisation d'un boîtier distinct pour le système de stockage dans la topologie SAS est facultative.

Le principal avantage du stockage connecté au serveur par rapport aux autres options est son faible coût et sa grande vitesse, à un rythme d'un stockage pour un serveur. Cette topologie est la plus optimale dans le cas de l'utilisation d'un serveur unique via lequel l'accès au tableau de données est organisé. Mais elle a eu un certain nombre de problèmes qui ont amené les concepteurs à rechercher d'autres options pour organiser l'accès aux systèmes de stockage.

Les fonctionnalités de SAS comprennent:

- L'accès aux données dépend du système d'exploitation et du système de fichiers (en général);

- La complexité de l'organisation des systèmes à haute disponibilité;

- Faible coût;

- Haute vitesse dans un noeud;

- Réduire la vitesse de réponse lorsque le serveur qui dessert le stockage est chargé.

NAS

Système de stockage connecté au réseau. Cette version de l'organisation de l'accès est apparue relativement récemment. Son principal avantage réside dans la possibilité d'intégrer du stockage supplémentaire dans les réseaux existants, mais n'apporte aucune amélioration radicale de l'architecture de stockage. En fait, le NAS est un serveur de fichiers vierge et vous pouvez trouver aujourd'hui de nombreuses nouvelles implémentations de type NAS basées sur la technologie de serveur léger (Thin Server).

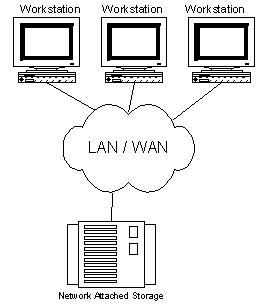

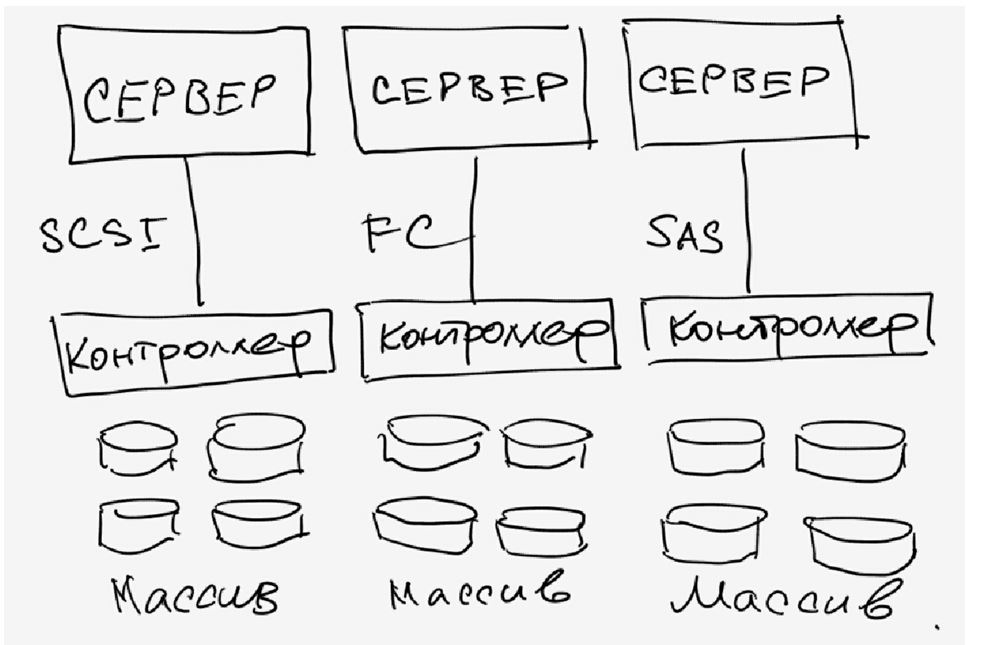

Figure 2. Stockage en réseau.

Caractéristiques du NAS:

- Serveur de fichiers dédié;

- L'accès aux données est indépendant du système d'exploitation et de la plate-forme.

- Facilité d'administration;

- Facilité d'installation maximale;

- Faible évolutivité;

- Conflit avec le trafic LAN / WAN.

Le stockage, construit sur la technologie NAS, est idéal pour les serveurs peu coûteux avec un ensemble de fonctions minimal.

SAN

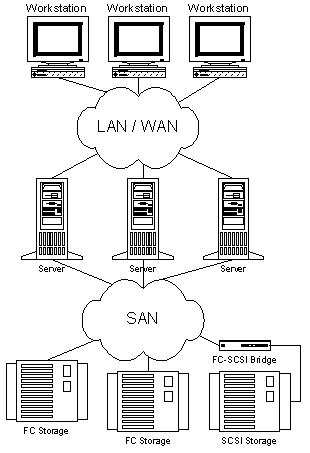

Les réseaux de stockage de données ont commencé à se développer de manière intensive et à être introduits seulement depuis 1999. Le SAN repose sur un réseau distinct du réseau LAN / WAN, qui permet d’accéder aux données des serveurs et des postes de travail impliqués dans leur traitement direct. Un tel réseau est créé sur la base du standard Fibre Channel, ce qui confère aux systèmes avantageux les avantages des technologies LAN / WAN et la possibilité d’organiser des plates-formes standard pour des systèmes à haute disponibilité et à forte demande. Le prix relativement élevé des composants constitue aujourd'hui le seul inconvénient d'un réseau de stockage, mais le coût total de possession des systèmes d'entreprise construits à l'aide de la technologie de réseau de stockage est plutôt faible.

Figure 3. Réseau de stockage.

Les principaux avantages de SAN incluent presque toutes ses fonctionnalités:

- Indépendance de la topologie SAN par rapport aux systèmes de stockage et aux serveurs;

- Gestion centralisée pratique;

- Pas de conflit avec le trafic LAN / WAN;

- Sauvegarde pratique des données sans charger le réseau local ni les serveurs;

- Haute vitesse;

- Grande évolutivité

- Grande flexibilité;

- Haute disponibilité et tolérance aux pannes.

Il convient également de noter que cette technologie est encore relativement récente et qu’elle devra faire l’objet de nombreuses améliorations dans le domaine de la normalisation de la gestion et de l’interaction des sous-réseaux SAN. Mais on peut espérer que cela ne menace les pionniers qu'avec des perspectives supplémentaires pour le championnat.

FC comme base pour la construction de SAN

À l'instar d'un réseau local, un réseau SAN peut être créé à l'aide de diverses topologies et de plusieurs opérateurs. Lors de la création d'un réseau SAN, vous pouvez utiliser à la fois une interface SCSI parallèle et un canal Fibre Channel ou, disons, une interface Scalable Coherent (Interface évolutive cohérente), mais la popularité croissante d'un réseau de stockage est due à Fibre Channel. Des spécialistes expérimentés dans le développement d’interfaces canal et réseau ont participé à la conception de cette interface et ont réussi à combiner toutes les caractéristiques positives importantes des deux technologies afin d’obtenir quelque chose de vraiment nouveau. Quoi exactement?

Principale caractéristiques clés canal:

- Faible latence

- Des vitesses élevées

- Haute fiabilité

- Topologie point à point

- Courtes distances entre les nœuds

- Dépendance de la plateforme

- Topologies multipoints

- Longue distance

- Grande évolutivité

- Faibles vitesses

- Gros retards

- Des vitesses élevées

- Indépendance du protocole (niveaux 0 à 3)

- Longue distance

- Faible latence

- Haute fiabilité

- Grande évolutivité

- Topologies multipoints

Traditionnellement, les interfaces de stockage (entre l’hôte et les périphériques de stockage) constituaient un obstacle à l’accélération et à l’augmentation du nombre de systèmes de stockage. Dans le même temps, les tâches appliquées nécessitent une augmentation significative de la capacité matérielle, ce qui entraîne une augmentation de la bande passante des interfaces pour la communication avec les systèmes de stockage. Fibre Channel résout les problèmes posés par la création d’un accès aux données haut débit flexible.

La norme Fibre Channel a finalement été définie au cours des dernières années (de 1997 à 1999), au cours desquelles un travail énorme a été réalisé pour harmoniser les interactions des fabricants de différents composants, et tout a été mis en oeuvre pour transformer Fibre Channel de la technologie purement conceptuelle en real, qui a reçu un soutien sous la forme d'installations dans des laboratoires et des centres informatiques. En 1997, les premiers échantillons commerciaux des composants de base pour la construction d'un réseau SAN basé sur FC, tels que des adaptateurs, des concentrateurs, des commutateurs et des ponts, ont été conçus. Ainsi, déjà depuis 1998, FC est utilisé à des fins commerciales dans le monde des affaires, dans la production et dans des projets de grande envergure mettant en œuvre des systèmes critiques en cas de défaillance.

Fibre Channel est une interface série haute vitesse standard ouverte. Il permet de connecter des serveurs et des systèmes de stockage à une distance maximale de 10 km (avec un équipement standard) à une vitesse de 100 Mo / s (à Cebit "2000). Des échantillons de produits utilisant le nouveau standard Fibre Channel à une vitesse de 200 Mo / s pour un anneau, et en laboratoire, le nouveau standard avec des débits de 400 Mo / s, soit 800 Mo / s en cas de double anneau, est déjà opérationnel. (Au moment de la publication de l'article, un certain nombre de fabricants avaient déjà commencé à expédier des cartes réseau et des commutateurs à 200 MB / s. .) Fibre Channel simultanément Il prend en charge une variété de protocoles standard (notamment TCP / IP et SCSI-3) lorsqu’on utilise un support physique, ce qui simplifie potentiellement la construction de l’infrastructure réseau, offre en outre des possibilités de réduction des coûts d’installation et de maintenance. Toutefois, l’utilisation de sous-réseaux distincts pour les réseaux LAN / WAN et SAN présente plusieurs avantages et est recommandée par défaut.

L'un des avantages les plus importants de Fibre Channel, ainsi que les paramètres de vitesse (qui ne sont d'ailleurs pas toujours centraux pour les utilisateurs de SAN et peuvent être mis en œuvre à l'aide d'autres technologies), sont la capacité de travailler sur de longues distances et la flexibilité de la topologie issue des nouvelles technologies réseau. Ainsi, le concept de construction d'une topologie de stockage réseau repose sur les mêmes principes que les réseaux traditionnels, généralement basés sur des concentrateurs et des commutateurs, ce qui permet d'éviter une perte de vitesse avec un nombre croissant de nœuds et crée des opportunités pour une organisation commode des systèmes sans point de défaillance unique.

Pour mieux comprendre les avantages et les caractéristiques de cette interface, nous présentons une caractéristique comparative de FC et de SCSI parallèle sous forme de tableau.

Tableau 1. Comparaison des technologies Fibre Channel et SCSI parallèle

La norme Fibre Channel suppose l’utilisation de diverses topologies, telles que point à point (point à point), un concentrateur en anneau ou FC-AL (boucle ou concentrateur FC-AL), un commutateur de jonction (structure / commutateur).

La topologie point à point permet de connecter un seul système de stockage au serveur.

Loop ou Hub FC-AL - pour connecter plusieurs périphériques de stockage à plusieurs hôtes. Lorsque vous organisez une double sonnerie, la vitesse et la tolérance de panne du système augmentent.

Les commutateurs sont utilisés pour assurer une performance et une tolérance de panne maximales aux systèmes complexes, de grande taille et étendus.

Grâce à la flexibilité du réseau, le réseau SAN présente une caractéristique extrêmement importante: la possibilité pratique de créer des systèmes tolérants aux pannes.

En proposant des solutions de stockage alternatives et la possibilité de combiner plusieurs installations de stockage pour la redondance matérielle, SAN aide à garantir que les systèmes matériels et logiciels sont protégés contre les pannes matérielles. Pour démonstration, nous donnons un exemple de création d’un système de deux ans sans points d’échec.

Figure 4. Pas de point de défaillance unique.

La construction de systèmes à trois nœuds ou plus est réalisée en ajoutant simplement des serveurs supplémentaires au réseau FC et en les connectant aux deux concentrateurs / commutateurs).

Lors de l'utilisation de FC, la construction de systèmes tolérants aux sinistres (tolérants aux sinistres) devient transparente. Les canaux de réseau pour le stockage et le réseau local peuvent être établis sur la base de la fibre optique (jusqu'à 10 km et plus en utilisant des amplificateurs de signal) en tant que support physique pour FC, en utilisant un équipement standard permettant de réduire considérablement le coût de tels systèmes.

Avec la possibilité d'accéder à tous les composants SAN depuis n'importe quel point, nous disposons d'un réseau de données extrêmement flexible. Il convient de noter que le réseau de stockage fournit la transparence (possibilité de voir) de tous les composants jusqu'aux disques des systèmes de stockage. Cette fonctionnalité a poussé les fabricants de composants à utiliser leur expérience considérable dans la création de systèmes de gestion pour réseau local / étendu afin d'intégrer de vastes capacités de surveillance et de gestion à tous les composants SAN. Ces fonctionnalités incluent la surveillance et le contrôle de nœuds individuels, de composants de stockage, de boîtiers, de périphériques réseau et de sous-structures réseau.

Le système de gestion et de surveillance SAN utilise des normes ouvertes telles que:

- Jeu de commandes SCSI

- Services de boîtier SCSI (SES)

- Technologie d'analyse et de génération de rapports d'autosurveillance SCSI (S.M.A.R.T.)

- SAF-TE (boîtiers acceptant les pannes acceptables SCSI)

- Protocole de gestion de réseau simple (SNMP)

- Gestion d'entreprise basée sur le Web (WBEM)

Les systèmes construits à l'aide de technologies SAN offrent non seulement à l'administrateur la possibilité de surveiller le développement et l'état des ressources, mais ouvrent également des possibilités de surveillance et de contrôle du trafic. Grâce à ces ressources, le logiciel de gestion SAN met en œuvre les outils les plus efficaces pour la planification des volumes et l'équilibrage de la charge des composants système.

Les réseaux de stockage sont bien intégrés aux infrastructures d’information existantes. Leur mise en œuvre ne nécessite aucune modification des réseaux LAN et WAN existants, mais élargit les possibilités systèmes existants, en les sauvant de tâches axées sur le transfert de grandes quantités de données. De plus, lors de l'intégration et de l'administration d'un réseau de stockage, il est essentiel que les principaux éléments du réseau prennent en charge le remplacement à chaud et l'installation, avec des fonctionnalités de configuration dynamiques. Ainsi, un administrateur peut ajouter un ou plusieurs composants ou le remplacer sans arrêter le système. Et tout ce processus d'intégration peut être affiché visuellement dans le système de gestion graphique SAN.

Après avoir examiné les avantages ci-dessus, vous pouvez identifier un certain nombre de points clés qui affectent directement l'un des principaux avantages du réseau de stockage, à savoir le coût total de possession (Total Cost Ownership).

Une évolutivité incroyable permet à une entreprise utilisant un réseau de stockage d’investir autant que nécessaire dans les serveurs et le stockage. Et aussi de conserver leurs investissements dans les équipements déjà installés lors de l’évolution des générations technologiques. Chaque nouveau serveur sera en mesure de fournir un accès haute vitesse au stockage et chaque stockage supplémentaire, en gigaoctets, sera accessible à tous les serveurs du sous-réseau par l'administrateur.

Les excellentes possibilités de construction de systèmes tolérants aux pannes peuvent apporter des avantages commerciaux directs en minimisant les temps d'arrêt et en épargnant le système en cas de catastrophe naturelle ou de tout autre cataclysme.

La contrôlabilité des composants et la transparence du système permettent une administration centralisée de toutes les ressources, ce qui réduit considérablement le coût de leur support, dont le coût est généralement supérieur à 50% du coût de l'équipement.

Impact du SAN sur les tâches appliquées

Pour que nos lecteurs comprennent à quel point les technologies présentées dans cet article sont pratiques, donnons quelques exemples de tâches appliquées qui ne seraient pas résolues efficacement, qui nécessiteraient d’énormes investissements financiers ou qui ne seraient pas résolues par des méthodes standard sans utiliser de réseaux de stockage.

Sauvegarde et récupération de données

À l'aide de l'interface SCSI traditionnelle, l'utilisateur, lors de la création de systèmes de sauvegarde et de récupération de données, est confronté à un certain nombre de problèmes complexes pouvant être résolus très simplement à l'aide des technologies SAN et FC.

Ainsi, l’utilisation des réseaux de stockage apporte une nouvelle solution au problème de la sauvegarde et de la restauration et offre la possibilité de sauvegarder plusieurs fois plus rapidement qu’avant, sans charger le réseau local ni les serveurs en sauvegardant les données.

Clustering de serveurs

L'une des tâches classiques pour lesquelles le réseau SAN est utilisé efficacement est la mise en cluster de serveurs. L’accès aux installations de stockage étant l’un des points clés de l’organisation de systèmes de clusters à haut débit fonctionnant avec des données, l’avènement du SAN a permis de construire des clusters multimodes au niveau matériel en ajoutant simplement un serveur avec une connexion au réseau de stockage (sans même arrêter le système). commutateurs FC prennent en charge le branchement à chaud). Lorsque vous utilisez une interface SCSI parallèle dont la connectivité et l'évolutivité sont bien pires que celles de FC, les clusters orientés traitement de données seraient difficiles à faire avec plus de deux nœuds. Les commutateurs SCSI parallèles sont des périphériques très complexes et coûteux. Pour FC, il s'agit d'un composant standard. Pour créer un cluster qui n'aura pas un seul point de défaillance, il suffit d'intégrer le SAN en miroir (technologie DUAL Path) au système.

Dans le cadre du clustering, l’une des technologies de RAIS (Redundant Array of Inexpensive Servers) semble particulièrement intéressante pour la création de systèmes de commerce électronique évolutifs puissants et pour d’autres types de tâches nécessitant une consommation électrique accrue. Selon Alistair A. Croll, cofondateur de Networkshop Inc, l’utilisation de RAIS est relativement efficace: «Par exemple, pour 12 000 à 15 000 dollars, vous pouvez acheter environ six serveurs Linux / Apache peu coûteux à un seul processeur (Pentium III). La puissance, l’évolutivité et la résilience d’un tel système seront bien plus élevées que, par exemple, un serveur à quatre processeurs unique basé sur des processeurs Xeon, et le coût est identique. "

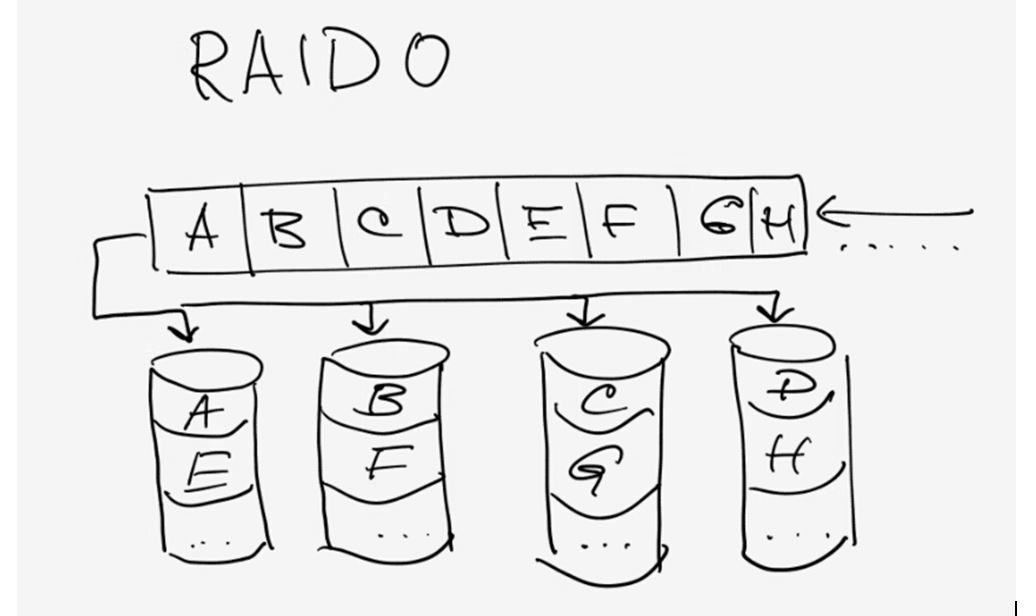

Accès vidéo simultané et distribution de données (streaming vidéo simultané, partage de données)

Imaginez une tâche lorsque vous devez éditer une vidéo sur plusieurs stations (par exemple,\u003e 5) ou tout simplement travailler sur des données volumineuses. Le transfert d’un fichier de 100 Go sur un réseau local vous prendra quelques minutes. travail général ce sera une tâche très difficile. Avec SAN, chaque poste de travail et serveur de réseau accède au fichier à un débit équivalent à un disque à grande vitesse local. Si vous avez besoin d'une autre station / serveur pour traiter les données, vous pouvez les ajouter au réseau de stockage sans arrêter le réseau, en connectant simplement la station au commutateur SAN et en lui accordant les droits d'accès au stockage. Si les performances du sous-système de données ne sont plus satisfaisantes, vous pouvez simplement ajouter un stockage supplémentaire et utiliser la technologie de distribution de données (par exemple, RAID 0) deux fois plus vite.

Composants SAN Core

Le mercredi

Les câbles en cuivre et en fibre optique sont utilisés pour connecter des composants conformes à la norme Fibre Channel. Les deux types de câbles peuvent être utilisés simultanément lors de la création d'un réseau SAN. La conversion d'interface est effectuée à l'aide de GBIC (convertisseur d'interface gigabit) et de MIA (adaptateur d'interface multimédia). Les deux types de câbles offrent aujourd'hui le même débit de données. Le câble en cuivre est utilisé pour les distances courtes (jusqu’à 30 mètres), à fibres optiques - aussi bien pour les distances courtes que pour les distances jusqu’à 10 km et plus. Utilisez des câbles optiques multimodes et monomodes. Le câble multimode est utilisé pour les courtes distances (jusqu'à 2 km). Le diamètre interne de la fibre multimode est de 62,5 ou 50 microns. Pour garantir un taux de transfert de 100 Mo / s (200 Mo / s en duplex) avec une fibre multimode, la longueur du câble ne doit pas dépasser 200 mètres. Le câble monomode est utilisé pour les longues distances. La longueur de ce câble est limitée par la puissance laser utilisée dans l'émetteur de signal. Le diamètre interne d'un câble à fibre optique monomode est de 7 ou 9 microns, il assure le passage d'un faisceau unique.

Connecteurs, adaptateurs

Pour connecter des câbles en cuivre, les connecteurs utilisés sont du type DB-9 ou HSSD. Le HSSD est considéré comme plus fiable, mais le DB-9 est utilisé aussi souvent parce qu’il est plus simple et moins cher. Le connecteur standard (le plus courant) pour les câbles optiques est le connecteur SC, qui fournit une connexion claire de haute qualité. Des connecteurs SC multimodes sont utilisés pour la connexion habituelle, ainsi que pour le mode distant monomode. Les adaptateurs multiport utilisent des microconnecteurs.

Les adaptateurs les plus courants pour le bus FC PCI 64 bits. En outre, de nombreux adaptateurs FC sont produits pour S-BUS, des adaptateurs pour MCA, EISA, GIO, HIO, PMC, Compact PCI sont disponibles pour une utilisation spécialisée. Les plus populaires sont les ports simples, les cartes à deux et quatre ports. Sur les cartes PCI, utilisez en règle générale les connecteurs DB-9, HSSD et SC. Nous avons également souvent trouvé des adaptateurs basés sur GBIC fournis avec les modules et GBIC, et sans eux. Les adaptateurs Fibre Channel se distinguent par les classes qu’ils prennent en charge et diverses fonctionnalités. Pour comprendre les différences, nous présentons un tableau comparatif des adaptateurs fabriqués par QLogic.

| Tableau de famille de l'adaptateur de bus hôte Fibre Channel | ||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Sanblade | 64 bits | FCAL Publ. Boucle Pvt | Port FL | Classe 3 | Port F | Classe 2 | Point à point | IP / SCSI | Duplex intégral | FC bande | Spécification enfichable à chaud PCI 1.0 | Reconfig dynamique Solaris | Vib | 2 Go |

| Série 2100 | PCI 33 et 66 MHz | X | X | X | ||||||||||

| Série 2200 | PCI 33 et 66 MHz | X | X | X | X | X | X | X | X | X | ||||

| PCI 33 MHz | X | X | X | X | X | X | X | X | X | X | ||||

| Sbus 25 MHZ | X | X | X | X | X | X | X | X | X | X | ||||

| Série 2300 | PCI-X 66 MHz / 133 MHz PCI-X | X | X | X | X | X | X | X | X | X | X | X | ||

Hubs

Les concentrateurs HUB Fibre Channel sont utilisés pour connecter des nœuds à la boucle FC (boucle FC) et ont une structure similaire à celle des concentrateurs Token Ring. La rupture de sonnerie pouvant entraîner la terminaison du réseau, les concentrateurs FC modernes utilisent des ports de contournement d'anneau (circuit de contournement de port PBC), qui permettent d'ouvrir / fermer automatiquement l'anneau (connexion / déconnexion de systèmes connectés au concentrateur). Normalement, les hubs FC prennent en charge jusqu'à 10 connexions et peuvent empiler jusqu'à 127 ports par sonnerie. Tous les périphériques connectés au HUB reçoivent une bande passante totale, qu'ils peuvent partager entre eux.

Interrupteurs

Les commutateurs Fibre Channel (commutateurs) ont les mêmes fonctions que les commutateurs LAN bien connus du lecteur. Ils fournissent une connexion non bloquante à pleine vitesse entre les nœuds. Tout nœud connecté au commutateur FC reçoit la totalité de la bande passante (évolutive). À mesure que le nombre de ports dans un réseau commuté augmente, son débit augmente. Les commutateurs peuvent être utilisés avec des concentrateurs (utilisés dans les zones ne nécessitant pas de bande passante dédiée pour chaque nœud) afin d'obtenir un rapport qualité / prix optimal. Grâce à la mise en cascade, les commutateurs peuvent potentiellement être utilisés pour créer des réseaux FC avec 2 24 adresses (plus de 16 millions).

Les ponts

Les ponts FC (ponts ou multiplexeurs) permettent de connecter des périphériques SCSI parallèles à un réseau FC. Ils fournissent des paquets SCSI de diffusion entre des périphériques Fibre Channel et SCSI parallèles, comme par exemple les disques SSD (Solid State Disk) ou les bibliothèques de bandes. Il convient de noter que ces derniers temps, presque tous les périphériques pouvant être mis au rebut dans le réseau SAN, les fabricants commencent à produire avec une interface FC intégrée pour leur connexion directe aux réseaux de stockage.

Serveurs et stockage

Bien que les serveurs et le stockage ne soient pas les derniers composants SAN importants, nous ne nous attarderons pas à leur description, car nous sommes certains que tous nos lecteurs les connaissent bien.

En fin de compte, je voudrais ajouter que cet article n’est que la première étape vers les réseaux de stockage. Pour bien comprendre le sujet, le lecteur doit accorder une attention particulière aux fonctionnalités d'implémentation des composants par les fabricants de SAN et aux outils de gestion de logiciels, car sans eux, le Storage Area Network n'est qu'un ensemble d'éléments pour la commutation de systèmes de stockage qui ne vous apporteront pas tous les avantages de la mise en œuvre.

Conclusion

Aujourd'hui, le réseau de stockage est une technologie relativement nouvelle qui pourrait bientôt devenir populaire parmi les entreprises. En Europe et aux États-Unis, les entreprises disposant d'une flotte suffisamment importante de systèmes de stockage installés commencent déjà à passer à des réseaux de stockage pour organiser le stockage avec le meilleur indicateur de coût total de possession.

Selon les analystes, un nombre important de serveurs des niveaux intermédiaire et supérieur disposeront d’une interface Fibre Channel préinstallée (cette tendance est déjà perceptible aujourd’hui), et les serveurs n’utiliseront une interface SCSI parallèle que pour la connexion interne de disques. Déjà aujourd'hui, lors de la construction de systèmes de magasins et de l'acquisition de serveurs intermédiaires et supérieurs, il convient de prêter attention à cette technologie prometteuse, d'autant plus qu'aujourd'hui, elle permet de réaliser de nombreuses tâches beaucoup moins chères qu'avec des solutions spécialisées. De plus, en investissant dans la technologie SAN aujourd'hui, vous ne perdrez pas votre investissement demain, car les fonctionnalités de la Fibre Channel créent d'excellentes opportunités d'investissement.

P.S.

La version précédente de l'article avait été écrite en juin 2000, mais en raison du manque d'intérêt général pour la technologie des réseaux de stockage, la publication a été reportée à une date ultérieure. Cet avenir est aujourd’hui aujourd’hui, et j’espère que cet article incitera le lecteur à prendre conscience de la nécessité de passer à la technologie des réseaux de stockage, en tant que technologie avancée pour la création de systèmes de stockage et l’accès aux données.

Jamais auparavant le problème du stockage de fichiers n'avait été aussi aigu qu'aujourd'hui.

L’émergence de disques durs d’une capacité de 3 voire 4 To, de disques Blu-Ray d’une capacité allant de 25 à 50 Go, stockage en nuage - ne résout pas le problème. Autour de nous, de plus en plus d'appareils générant un contenu lourd: appareils photo et caméscopes, smartphones, téléviseurs et vidéos HD, consoles de jeux, etc. Nous générons et consommons (principalement à partir d'Internet) des centaines et des milliers de gigaoctets.

Cela signifie que l'ordinateur de l'utilisateur moyen stocke un nombre considérable de fichiers, des centaines de gigaoctets: une archive de photos, une collection de films, jeux, programmes, documents de travail, etc. préférés.

Tout cela doit non seulement être stocké, mais également protégé contre les pannes et autres menaces.

Pseudo-solutions

Vous pouvez équiper votre ordinateur volumineux disque dur. Mais dans ce cas, la question se pose: comment et où archiver, par exemple, les données d'un disque de 3 téraoctets?

Vous pouvez mettre deux disques et les utiliser en mode RAID «miroir» ou simplement effectuer des sauvegardes régulières d'un disque à l'autre. Ce n'est également pas la meilleure option. Supposons qu'un ordinateur soit attaqué par des virus: très probablement, ils infecteront les données des deux disques.

Vous pouvez stocker des données importantes sur disques optiquesen organisant une archive Blu-ray à domicile. Mais il sera extrêmement gênant de l'utiliser.

Stockage réseau - la solution! En partie ...

Stockage en réseau (NAS) - stockage de fichiers en réseau. Mais cela s’explique encore plus facilement:

Supposons que vous ayez deux ou trois ordinateurs à la maison. Très probablement, ils sont connectés à un réseau local (filaire ou sans fil) et à Internet. Le stockage réseau est un ordinateur spécialisé intégré à votre réseau domestique et se connecte à Internet.

En conséquence, le NAS peut stocker n’importe laquelle de vos données et vous pouvez y accéder depuis n’importe quel PC ou ordinateur portable à la maison. Pour l’avenir, il convient de préciser que le réseau local doit être suffisamment moderne pour pouvoir pomper rapidement et facilement plus de 10 000 gigaoctets entre celui-ci et les ordinateurs. Mais plus à ce sujet plus tard.

Où trouver un NAS?

Méthode 1: achat. Des NAS plus ou moins décents sur 2 ou 4 disques durs peuvent être achetés pour 500-800 dollars. Un tel serveur sera emballé dans une petite mallette et prêt à fonctionner, comme on dit, hors de la boîte.

Méthode 1: achat. Des NAS plus ou moins décents sur 2 ou 4 disques durs peuvent être achetés pour 500-800 dollars. Un tel serveur sera emballé dans une petite mallette et prêt à fonctionner, comme on dit, hors de la boîte.

Cependant, le plus à ces 500-800 dollars est ajouté par le coût des disques durs! Comme d'habitude, les NAS sont en vente sans eux.

Avantages: vous obtenez le périphérique fini et vous passez le moins de temps possible.

Les inconvénients de cette solution: le NAS coûte cher en tant qu'ordinateur de bureau, mais en même temps, ses capacités sont incomparablement plus petites. En fait, il ne s'agit que d'un réseau. lecteur externe pour beaucoup d'argent. Pour beaucoup d'argent, vous obtenez un ensemble limité de fonctionnalités non rentables.

Ma solution: construire soi-même!

Il est beaucoup moins coûteux d’acheter un NAS séparé, même si la construction de la voiture prend un peu plus de temps). Cependant, vous disposez d'un serveur domestique à part entière qui, s'il le souhaite, peut être utilisé dans toute la gamme de ses capacités.

ATTENTION!Je recommande fortement de ne pas construire un serveur domestique en utilisant ancien ordinateur ou vieux, ont passé leurs composants. N'oubliez pas que le serveur de fichiers est le stockage de vos données. Ne soyez pas avare de le rendre aussi fiable que possible afin qu’un jour, tous vos fichiers ne se "brûlent" pas avec les disques durs, par exemple en raison d’une défaillance du circuit d’alimentation de la carte mère ...

Nous avons donc décidé de créer un serveur de fichiers domestique. Un ordinateur dont les disques durs sont disponibles sur votre réseau domestique pour être utilisés. En conséquence, un tel ordinateur doit être économique en termes de consommation d'énergie, silencieux, compact, ne pas émettre beaucoup de chaleur et avoir des performances suffisantes.

La solution idéale à cet égard est une carte mère avec processeur intégré et système de refroidissement passif de taille compacte.

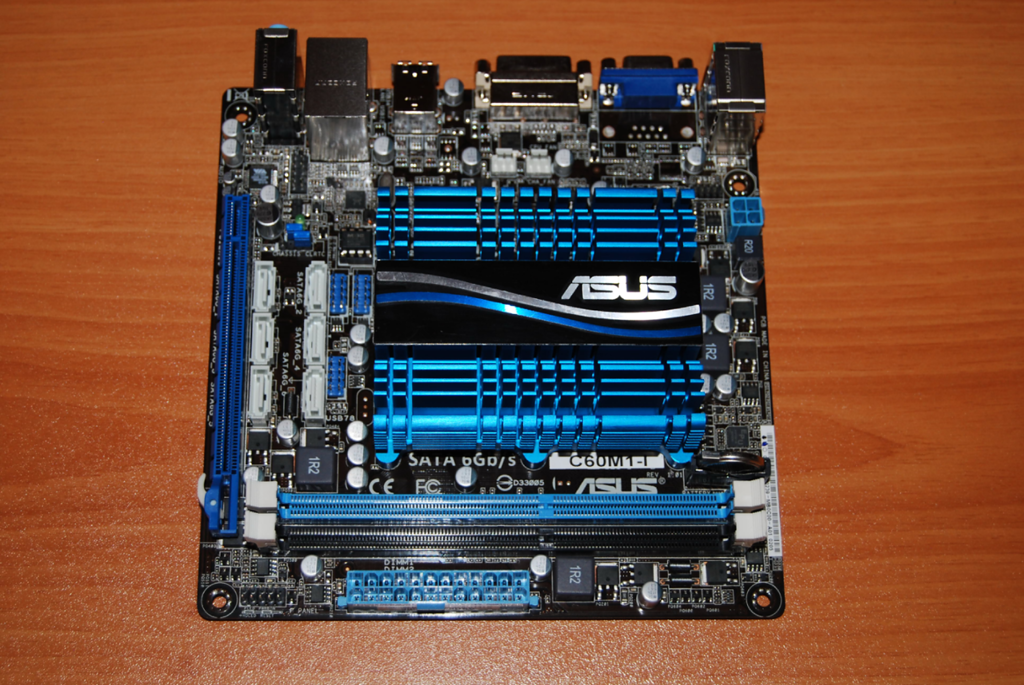

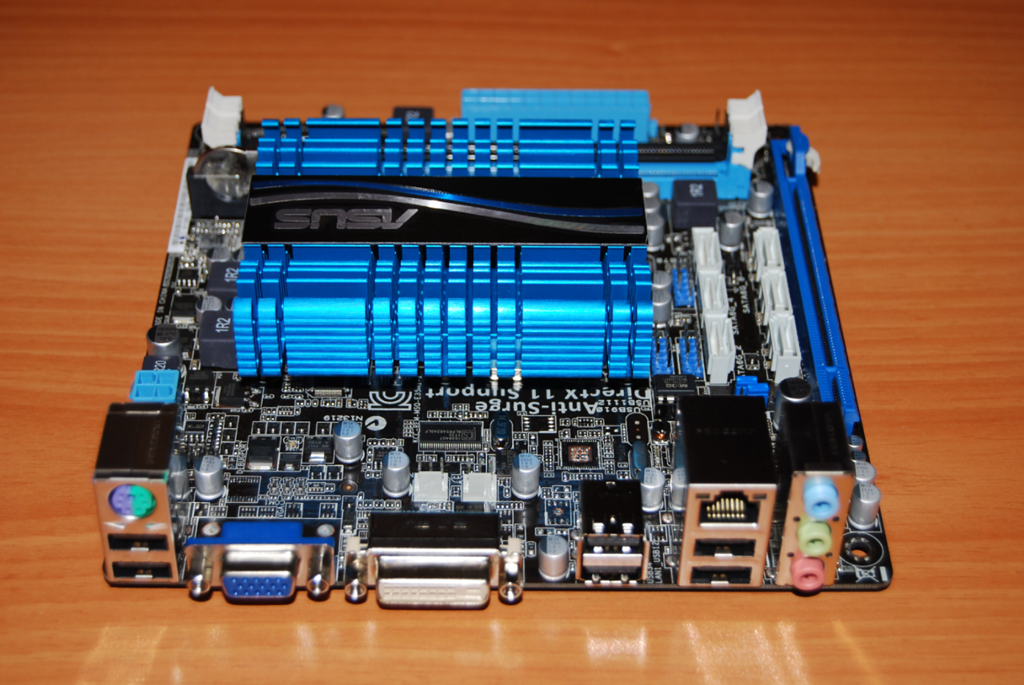

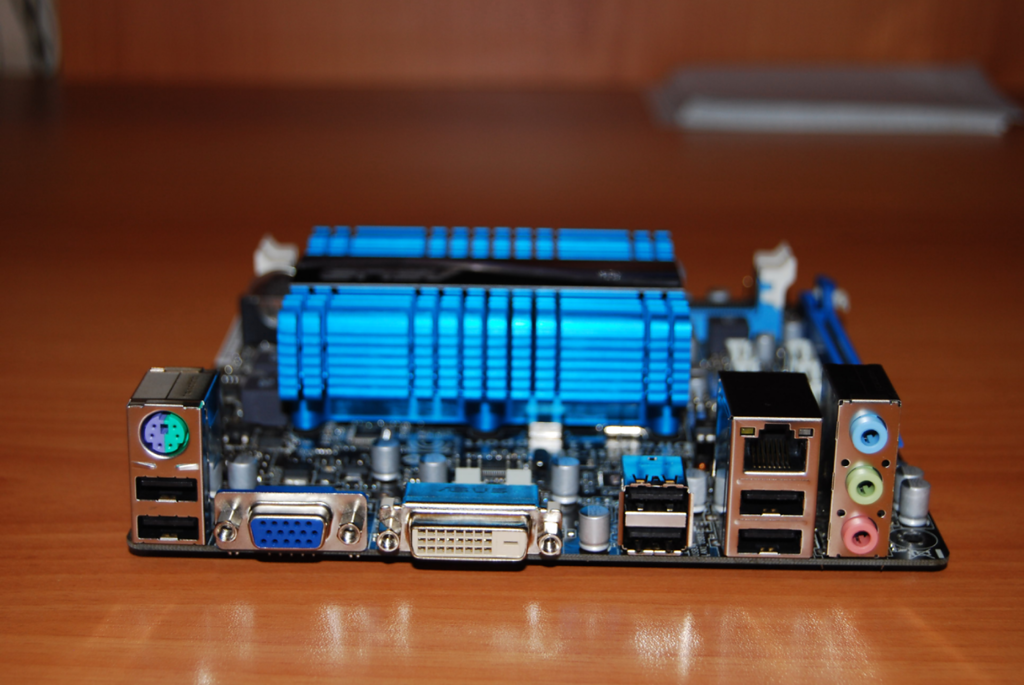

J'ai choisi la carte mère ASUS C-60M1-I . Il a été acheté dans la boutique en ligne dostavka.ru:

Le kit de livraison comprend un manuel d’utilisation de qualité, un disque de pilote, un autocollant sur le boîtier, 2 câbles SATA et un panneau arrière pour le boîtier:

ASUS, comme toujours, a complété le tableau avec beaucoup de générosité. Les spécifications complètes de la carte, vous pouvez trouver ici: http://www.asus.com/Motherboard/C60M1I/#specifications. Je ne dirai que quelques points importants.

À un coût de seulement 3300 roubles - Il fournit 80% de tout ce dont nous avons besoin pour le serveur.

On board est un processeur dual-core AMD C-60 avec puce graphique intégrée. Le processeur a une fréquence 1 GHz(peut augmenter automatiquement à 1,3 GHz). Aujourd'hui, il est installé dans certains netbooks et même des ordinateurs portables. Classe de processeur Intel Atom D2700. Mais tout le monde sait qu'Atom a des problèmes avec l'informatique parallèle, ce qui réduit souvent ses performances à "non". Mais le C-60 est privé de cet inconvénient et dispose en outre de graphiques assez puissants pour cette classe.

Il y a deux emplacements de mémoire DDR3-1066, avec la possibilité d'installer jusqu'à 8 Go de mémoire.

La carte contient 6 ports à bord. SATA 6 Gbps. Cela vous permet de connecter au système jusqu'à 6 disques (!), Et pas seulement 4, comme dans un NAS domestique normal.

Quel est le plus important - le conseil est basé sur UEFI, et pas le BIOS habituel. Cela signifie que le système pourra fonctionner normalement avec des disques durs supérieurs à 2,2 To. Elle va "voir" tout leur volume. Cartes mères le BIOS ne peut pas fonctionner avec des disques durs supérieurs à 2,2 Go sans «utilitaires de béquilles» spéciaux. Bien entendu, l’utilisation de tels utilitaires est inacceptable s’agissant de la fiabilité du stockage des données et des serveurs.

Le C-60 est un processeur plutôt froid, il est donc refroidi avec un seul radiateur en aluminium. Cela suffit pour que, même en pleine charge, la température du processeur n'augmente pas de plus de 50 à 55 degrés. Quelle est la norme

Un ensemble de ports est assez standard, triste que l’absence d’un nouvel USB 3.0. Et je veux surtout répondre à la présence d'un port réseau gigabit complet:

Sur cette carte, j'ai installé 2 modules de 2 Go DDR3-1333 de Patriot:

Windows 7 Ultimate a été installé sur un disque dur WD 500 Go Green et, pour les données, j'ai acheté un disque dur Hitachi-Toshiba 3 To:

Tout mon équipement est alimenté par une alimentation FSP de 400 watts, ce qui, bien sûr, avec une marge.

La dernière étape a été l’assemblage de tous ces équipements dans un châssis mini-ATX.

Immédiatement après le montage, j’ai installé sur ordinateur sous Windows 7 Ultimate (l’installation a pris environ 2 heures, ce qui est normal compte tenu de la faible vitesse du processeur).

Après tout cela, je me suis déconnecté du clavier, de la souris et du moniteur de l'ordinateur. En fait, une seule unité centrale est connectée au réseau local via un câble.

Il suffit de se rappeler l'adresse IP locale de ce PC sur le réseau pour pouvoir s'y connecter à partir de n'importe quel ordinateur utilisant l'utilitaire Windows standard «Connect to remote desktop»:

Je n'ai délibérément pas installé spécialisé systèmes d'exploitation pour organiser le stockage de fichiers, tel que FreeNAS. En effet, dans ce cas, il ne serait pas très utile d’assembler un PC séparé pour ces besoins. On pourrait simplement acheter un NAS.

Mais un serveur domestique séparé pouvant être chargé pour la nuit et laissé est plus intéressant. En outre, l'interface familière de Windows 7 est facile à gérer.

Le coût total total d'un serveur domestique SANS disques durs s'élevait à 6 000 roubles.

Ajout important

Lorsque vous utilisez un stockage réseau, la bande passante du réseau est très importante. De plus, même le réseau de câble habituel de 100 mégabits ne vous plaît pas, par exemple, lorsque vous effectuez un archivage de votre ordinateur sur votre serveur domestique. Transférer 100 Go sur un réseau de 100 mégabits, cela prend déjà quelques heures.

Que pouvons-nous dire sur le Wi-Fi. Eh bien, si vous utilisez le Wi-Fi 802.11n - dans ce cas, la vitesse du réseau est d’environ 100 mégabits. Et si la norme est 802.11g, où la vitesse est rarement supérieure à 30 mégabits? C'est très très petit.

Idéal pour interagir avec le serveur via un réseau câblé Ethernet Gigabit. Dans ce cas, c'est vraiment rapide.

Mais comment créer un tel réseau rapidement et à un coût minimal - je vais le dire dans un article séparé.

Et d'autres choses encore, le support de transfert de données et les serveurs qui y sont connectés. Il est généralement utilisé par de grandes entreprises disposant d'une infrastructure informatique développée pour un stockage de données fiable et un accès haute vitesse.

Le stockage simplifié est un système qui permet aux serveurs de distribuer des disques fiables, rapides et à capacité variable de différents périphériques de stockage aux serveurs.

Un peu de théorie.

Le serveur peut être connecté au stockage de données de plusieurs manières.

Le premier et le plus simple - DAS, Direct Attached Storage (connexion directe), place simplement les disques dans le serveur ou la matrice dans l'adaptateur de serveur - et nous obtenons beaucoup de gigaoctets d'espace disque avec un accès relativement rapide et, lors de l'utilisation d'une matrice RAID - une fiabilité suffisante, bien que Les lances de fiabilité sont brisées depuis longtemps.

Toutefois, une telle utilisation de l’espace disque n’est pas optimale: sur un serveur, l’emplacement est en train de s’épuiser, sur l’autre, il y en a beaucoup. La solution à ce problème est NAS, stockage en réseau (stockage en réseau). Cependant, avec tous les avantages de cette solution - flexibilité et gestion centralisée - un inconvénient majeur - la vitesse d'accès, toutes les organisations ne disposent pas d'un réseau de 10 gigabits. Et nous arrivons au stockage en réseau.

La principale différence entre SAN et NAS (en plus de l'ordre des lettres dans les abréviations) réside dans la façon dont les ressources connectées sont visualisées sur le serveur. Si les ressources NAS sont connectées aux protocoles NFS ou SMB, nous obtenons une connexion de disque au réseau de stockage, avec laquelle nous pouvons travailler au niveau des opérations d'E / S de bloc, ce qui est beaucoup plus rapide que la connexion réseau (plus un contrôleur multidisque avec un cache important augmente la vitesse de nombreuses opérations).

En utilisant SAN, nous combinons les avantages du DAS - rapidité et simplicité, et NAS - flexibilité et contrôlabilité. De plus, nous obtenons la capacité de dimensionner les systèmes de stockage tant que nous disposons de suffisamment d’argent, ce qui tue plusieurs oiseaux en même temps, ce qui n’est pas immédiatement visible:

* supprimer les restrictions sur la distance de connexion des périphériques SCSI, généralement limités à 12 mètres de fil,

* nous réduisons le temps de sauvegarde,

* nous pouvons démarrer à partir de SAN,

* en cas de panne du NAS décharger le réseau,

* nous obtenons plus de vitesse d'E / S en optimisant le système de stockage,

* nous sommes en mesure de connecter plusieurs serveurs à une ressource, ce qui nous donne les deux oiseaux suivants avec une pierre:

- utilisation complète des fonctionnalités VMWare - par exemple, VMotion (migration de machine virtuelle entre physiques) et d’autres,

- nous pouvons construire des clusters tolérants aux pannes et organiser des réseaux répartis géographiquement.

Qu'est-ce que cela donne?

En plus de maîtriser le budget pour optimiser le système de stockage, nous obtenons, en plus de ce que j'ai écrit ci-dessus:

* augmentation des performances, de l'équilibrage de la charge et de la haute disponibilité des systèmes de stockage via de multiples chemins d'accès aux baies;

* des économies sur les disques en optimisant la localisation des informations;

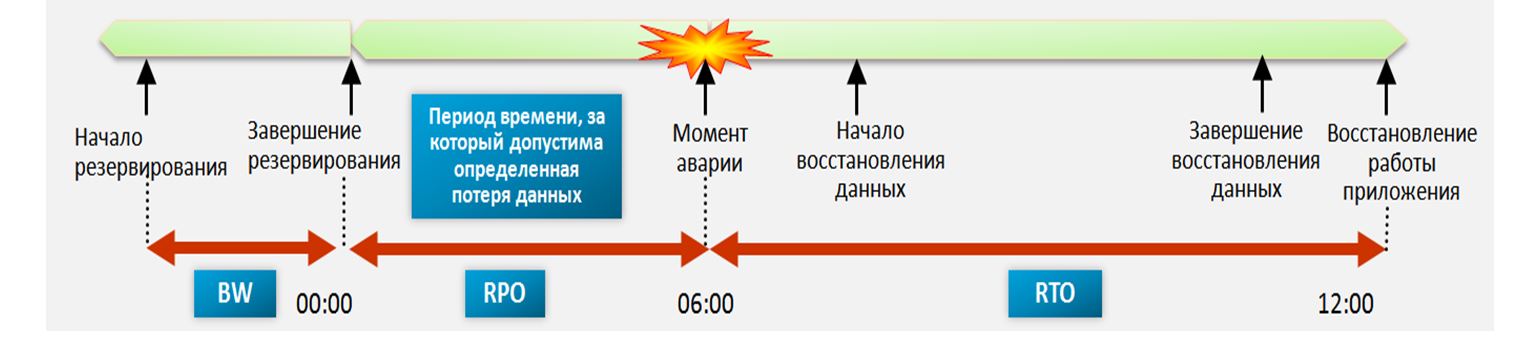

* Récupération accélérée après des pannes: vous pouvez créer des ressources temporaires, y déployer des sauvegardes, y connecter des serveurs et récupérer des informations sans hâte, ou transférer des ressources vers d'autres serveurs et gérer calmement le problème.

* réduire le temps de sauvegarde - en raison de la vitesse de transfert élevée, vous pouvez sauvegarder sur la bandothèque plus rapidement, ou même prendre un instantané (instantané) à partir du système de fichiers et l'archiver discrètement;

* espace disque à la demande - lorsque nous en avons besoin - vous pouvez toujours ajouter une paire d'étagères au système de stockage.

* nous réduisons le coût de stockage d'un mégaoctet d'informations - naturellement, il existe un certain seuil à partir duquel ces systèmes sont rentables.

* un endroit fiable pour stocker des données critiques et critiques pour l'entreprise (sans lesquelles une organisation ne peut exister et fonctionner normalement).

* séparément, je tiens à mentionner VMWare: toutes les fonctionnalités, telles que la migration de machine virtuelle d'un serveur à un autre, sont disponibles uniquement sur le réseau SAN.

En quoi consiste-t-il?

Comme je l'ai écrit plus haut, le système de stockage comprend des périphériques de stockage, des supports de transmission et des serveurs connectés. Considérez dans l'ordre:

Systèmes de stockage de données généralement constitués de disques durs et de contrôleurs, dans un système qui se respecte, généralement de 2 à 2 contrôleurs, 2 chemins d'accès à chaque disque, 2 interfaces, 2 alimentations, 2 administrateurs. Parmi les fabricants de systèmes les plus respectés, il convient de mentionner HP, IBM, EMC et Hitachi. Je citerai ici un représentant d’EMC au séminaire: «HP fabrique d’excellentes imprimantes. Laissez-la les fabriquer! ”Je suppose que HP aime également beaucoup CEM. La concurrence entre fabricants est cependant grave, comme ailleurs. Les effets de la concurrence sont parfois des prix par mégaoctet de problèmes de stockage et de compatibilité imputés, ainsi que le respect des normes des concurrents, en particulier pour les équipements plus anciens.

Support de transmission de données.

En règle générale, le SAN est construit sur l'optique, il donne actuellement la vitesse de 4, parfois 8 gigabits par canal. Lors de la construction de hubs spécialisés précédemment utilisés, de plus en plus de commutateurs, principalement de Qlogic, Brocade, McData et Cisco (les deux derniers sur les sites n’ont pas encore été vus). Les câbles sont utilisés traditionnellement pour les réseaux optiques - monomode et multimode, monomode plus longue portée.

À l'intérieur, il utilise FCP - Fibre Channel Protocol, un protocole de transport. En général, le SCSI classique s’exécute à l’intérieur de celui-ci et FCP assure l’adressage et la remise. Il existe une option avec un réseau traditionnel et une connexion iSCSI, mais elle utilise généralement (et charge fortement) un réseau local, plutôt qu'un réseau dédié pour le transfert de données, et nécessite des adaptateurs prenant en charge iSCSI, et la vitesse est plus lente que dans l'optique.

Il existe également une topologie de mots à la mode, qui se trouve dans tous les manuels SAN. Il existe plusieurs topologies. L'option la plus simple est la liaison point à point, reliant deux systèmes. Ce n'est pas un DAS, mais un cheval sphérique sous vide, la version la plus simple du SAN. Ensuite, il y a la boucle contrôlée (FC-AL), elle fonctionne sur le principe de la transmission: l’émetteur de chaque appareil est connecté au récepteur suivant, les appareils sont fermés en anneau. Les longues chaînes ont la propriété d'une longue initialisation.

Eh bien, la dernière option - la structure commutée (Fabric), est créée à l'aide de commutateurs. La structure des connexions est basée sur le nombre de ports connectés, ainsi que lors de la construction d'un réseau local. Le principe de base de la construction est que tous les chemins et toutes les connexions sont dupliqués. Cela signifie que chaque périphérique du réseau a au moins 2 chemins différents. Ici aussi, le mot topologie est utilisé, dans le sens d'organiser le schéma de connexion de périphériques et de commutateurs. Dans ce cas, en règle générale, les commutateurs sont configurés de sorte que les serveurs ne voient rien sauf les ressources qui leur sont affectées. Ceci est réalisé par la création de réseaux virtuels et s'appelle zonage, l'analogie la plus proche est le VLAN. Chaque périphérique du réseau se voit attribuer un analogue de l’adresse MAC d’un réseau Ethernet, il s’appelle WWN - World Wide Name. Il est attribué à chaque interface et à chaque ressource (LUN) des systèmes de stockage. Les tableaux et les commutateurs peuvent différencier l'accès au WWN pour les serveurs.

Serveur connectez-vous au stockage via HBA - Host Bus Adapter. Semblable à cartes réseau Il existe des adaptateurs à un, deux ou quatre ports. Les meilleurs "éleveurs de chiens" recommandent l'installation de 2 adaptateurs par serveur, ce qui permet à la fois l'équilibrage de la charge et la fiabilité.

Et puis les ressources sont réduites sur les systèmes de stockage, ce sont les mêmes lecteurs (LUN) pour chaque serveur et l'espace est laissé dans le magasin, tout est activé, les installateurs système prescrivent la topologie, des problèmes dans la configuration des commutateurs et des accès, tout commence et tout le monde vit heureux pour toujours *

Je ne parle pas spécifiquement des différents types de ports du réseau optique, qui en a besoin - il sait déjà ou lit déjà, qui n'a pas besoin de - juste se cogner la tête. Mais comme d'habitude, si le type de port n'est pas défini correctement, rien ne fonctionnera.

Par expérience.

Habituellement, lors de la création d’un réseau SAN, les baies sont commandées avec plusieurs types de disques: FC pour les applications à grande vitesse et SATA ou SAS pour les moins rapides. Cela se traduit par 2 groupes de disques avec un coût différent en mégaoctets - coûteux et rapide, et lent et peu coûteux. Habituellement, toutes les bases de données et autres applications avec E / S actives et rapides sont bloquées sur le rapide, les ressources de fichiers et tout le reste sont lents sur le lent.

Si un réseau SAN est créé à partir de rien, il est judicieux de le créer à partir des solutions d'un seul fabricant. Le fait est que, malgré le respect des normes, il existe des problèmes de compatibilité des équipements sous-marins, et il n’est pas certain que certains équipements fonctionneront les uns avec les autres sans danser au tambourin et consulter les fabricants. Habituellement, pour résoudre de tels problèmes, il est plus facile d'appeler l'intégrateur et de lui donner de l'argent que de communiquer avec les fabricants qui se donnent la main.

Si un SAN est créé sur la base de l'infrastructure existante, tout peut être difficile, surtout s'il existe d'anciennes baies SCSI et un zoo. ancienne technologie de différents fabricants. Dans ce cas, il est judicieux de faire appel à la bête effrayante de l'intégrateur, qui résoudra les problèmes de compatibilité et construira une troisième villa aux Canaries.

Souvent, lors de la création d'un système de stockage, les entreprises ne commandent pas le support du système par le fabricant. Cela se justifie généralement si l'entreprise dispose d'un personnel composé d'administrateurs compétents et compétents (qui m'ont appelé une théière 100 fois) et d'un capital suffisant vous permettant d'acheter des pièces de rechange en quantité suffisante. Cependant, les intégrateurs (il a vu lui-même) ont souvent séduit les administrateurs compétents, mais ils n’allouent aucune somme pour l’achat. Après des échecs, le cirque commence par crier: «Laissons tout le monde aller!». Au lieu d’appeler le soutien et l’arrivée d’un ingénieur avec une pièce de rechange.