Les pages en double sont l'une des nombreuses raisons de réduire les positions dans les résultats de la recherche et même d'entrer dans le filtre. Pour éviter cela, vous devez les avertir dans l'index des moteurs de recherche.

Déterminez la présence d'un double sur le site et de vous en débarrasser de différentes manières, mais la gravité du problème est que la duplication n'est pas toujours des pages inutiles, elles ne devraient tout simplement pas être dans l'index.

Nous résoudrons ce problème maintenant, seulement pour commencer à découvrir ce qu'un duplicata est et comment ils se présentent.

Qu'est-ce que les pages en double

Les pages d'élèves sont une copie du contenu de la page Canonicale (principale), mais avec une autre URL. Il est important de noter qu'il peut être à la fois complet et partiel.

Duplication complète C'est une copie précise, mais avec son adresse, dont la différence peut se manifester dans la barre oblique, l'abréviation www, la substitution des paramètres index.php?, Page \u003d 1, page / 1, etc.

Duplication partielle Il est manifesté dans la copie incomplète du contenu et associée à la structure du site, lorsque les annonces du répertoire des articles, des archives, du contenu de la barre latérale, de la page et d'autres éléments de la ressource contenues sur la page canonique sont indexées. Ceci est inhérent à la plupart des magasins CMS et en ligne dans lesquels le catalogue fait partie intégrante de la structure.

Nous avons déjà parlé des conséquences de l'apparition du chêne, et cela est dû à la répartition de la masse de référence entre des doublons, des pages de sous-menus dans l'indice, la perte du caractère unique du contenu, etc.

Comment trouver des pages Ducky sur place

Les méthodes suivantes peuvent être utilisées pour rechercher un double:

- string de recherche Google. Avec la conception du site: myblog.ru, où myBlog.ru est votre URL, les pages à partir de l'indice principal sont détectées. Pour voir les Duplicas, vous devez accéder à la dernière page des résultats de la recherche et cliquer sur la ligne "Afficher les résultats cachés";

- Équipe "Recherche avancée" dans Yandex. Pointant dans une adresse de fenêtre spéciale de votre site et d'entrer dans les citations L'une des propositions d'un article indexé exposé au chèque, nous ne devons obtenir qu'un seul résultat. Si leur plus est un duplicata;

- barre d'outils Pour webmasters en PS;

- manuellement, Substituant dans la barre d'adresse, la barre oblique, www, HTML, ASP, PHP, les lettres des registres supérieurs et inférieurs. Dans tous les cas, la redirection doit se produire sur la page avec l'adresse principale;

- programmes et services spéciaux: Xenu, Megaindex, etc.

Supprimer des feuilles de pages

La suppression des doubles en a également plusieurs. Chacun d'entre eux a son impact et ses conséquencesPar conséquent, il n'est pas nécessaire de parler de plus efficace. Il convient de rappeler que la destruction physique d'un duplicaté indexé n'est pas une solution: les moteurs de recherche se souviendront encore. Par conséquent, la meilleure méthode de traitement des dubs - empêcher leur apparence En utilisant les réglages de droite du site.

Voici quelques-uns des moyens d'éliminer les doubles:

- Régler des robots.txt. Cela permettra des pages spécifiques d'indexation. Mais si les robots Yandex sont susceptibles de ce fichier, Google capture même les pages clôturées par lui, sans notamment en considérant ses recommandations. De plus, avec l'aide de robots.txt, supprimer des duplicas indexés est très difficile;

- 301 Rediriger. Il contribue à coller un double avec une page canonique. La méthode est valide, mais pas toujours utile. Il ne peut pas être utilisé dans le cas où des doublons doivent rester des pages indépendantes, mais ne doivent pas être indexées;

- Affectation 404 erreurs DUBS INFÉTURES. La méthode est très bonne pour leur retrait, mais nécessitera un peu de temps avant que l'effet se manifeste lui-même.

Lorsque rien à coller et ne supprime rien, mais je ne veux pas perdre du poids de la page et obtenir une punition des moteurs de recherche, il est utilisé attribut HREF CANONICAL REIN.

Attribut canonique relâché sur la lutte contre les doubles

Je vais commencer par l'exemple. Dans la boutique en ligne, il y a deux pages avec des cartes de contenu identiques, mais sur les mêmes marchandises sont alphabétiquement et de l'autre. Les deux sont nécessaires et redirigés n'est pas autorisé. Dans le même temps, pour les moteurs de recherche, il s'agit d'un double clair.

Dans ce cas, l'utilisation rationnelle de la balise lien rel canoniqueindiquant la page canonique indexée, mais la page principale reste disponible pour les utilisateurs.

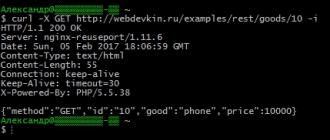

Ceci est fait comme suit: Dans le bloc-tête des pages-duplicata, la référence est spécifiée. "Link rel \u003d" canonique "href \u003d" http://site.ru/osnovnaya stranitsa "/"où Stranitsa est l'adresse de la page canonique.

Avec cette approche, l'utilisateur peut visiter librement n'importe quelle page du site, mais un robot, la lecture du code d'attribut Candonical Rel, ira indexer uniquement l'adresse indiquée dans le lien.

Cet attribut peut être utile et pour les pages de pagation. Dans ce cas, créez une page "Afficher tout" (ce "Portalylight") et prends pour les pages canonique et de pagination envoie un robot à travers relier Candonical.

Ainsi, le choix de la méthode de lutte contre la duplication de pages dépend de la nature de leur émergence et nécessité Présence sur le site.

La raison de la rédaction de cet article était le prochain appel d'un comptable avec une panique avant de se rendre compte des rapports sur la TVA. Le dernier trimestre a passé beaucoup de temps à nettoyer les doubles contreparties. Et encore ils, les mêmes et les nouveaux. Où?

J'ai décidé de passer du temps et de faire face à la cause, pas une conséquence. La situation est principalement pertinente avec le déchargement automatique personnalisé via les plans d'échange du programme de contrôle (dans mon cas de l'UT 10.3) dans le service de comptabilité de la société (dans mon cas 2.0).

Il y a plusieurs années, ces configurations ont été installées et l'échange automatique entre eux est configuré. Face au problème de la particularité du livre de référence des contreparties au département des ventes, qui a commencé à démarrer la manière de contreparties (avec la même auberge / chat / nom) pour une ou plusieurs raisons (la même contrepartie qu'ils se propagent dans différents groupes) . La comptabilité a exprimé son "fi" et a décidé - peu importe qu'ils ont, combinent des cartes lors du chargement en un. Je devais intervenir dans le processus de transfert d'objets par les règles d'échange. Enlevé pour les contreparties Recherche par identifiant interne et laissé une recherche par Inn + GPP + Nom. Cependant, puis il y avait leurs pièges sous la forme de fans de renommer les noms de contreparties (par conséquent, les dupils du BP sont déjà créés par les règles elles-mêmes). Ils se sont tous rassemblés, discutés, ont décidé, convaincu que, dans l'URT, nous avons eu dupliqué, ils les ont supprimés, sont retournés dans les règles standard.

C'est juste après que les doubles "peigneurs" dans UT et en BP - Les identificateurs internes de nombreuses contreparties différaient. Et puisque le type de règles d'échange effectue la recherche d'objets exclusivement sur l'identifiant interne, puis avec la partie suivante des documents dans le BP, une nouvelle double contrepartie double (dans le cas échéant que ces identificateurs diffèrent). Mais l'échange universel de données XML ne serait pas universel, si ce problème était impossible de se déplacer. Parce que Il est impossible de modifier l'identifiant de l'objet existant par des moyens standard, alors vous pouvez contourner cette situation à l'aide d'un registre de conformité spécial "Conformité d'objets d'échange d'échange", disponible dans toutes les configurations standard de 1c.

Pour ne pas avoir les nouveaux doubles, l'algorithme de nettoyage des doubles est devenu comme suit:

1. En BP à l'aide du traitement "Recherche et remplacement des éléments en double" (il est typique, il peut être prélevé à partir de la configuration. Commande de commerce ou sur le disque, ou sélectionnez le plus approprié parmi l'ensemble des variations sur l'infostar lui-même. ) Je trouve un double, je définis l'élément fidèle, cliquez sur Exécuter le remplacement.

2. Je reçois l'identifiant interne du seul (après le remplacement) de l'objet de notre double (systémarisé spécifiquement un traitement simple pour cela afin que l'identifiant interne soit automatiquement copié dans le presse-papiers).

3. J'ouvre la "conformité d'objets d'échange" dans UT, je fais une sélection par mon propre lien.

Combattre double page

Le propriétaire peut ne pas suspecter que sur son site Web certaines pages ont des copies - le plus souvent, cela se produit. Les pages sont ouvertes, leur contenu est tout en ordre, mais si seulement pour faire attention, on peut noter qu'avec le même contenu de l'adresse différente. Qu'est-ce que ça veut dire? Pour les utilisateurs vivants, rien, puisqu'ils sont intéressés par des informations sur les pages, mais les moteurs de recherche sans âme perçoivent un tel phénomène complètement différemment - pour eux, ce sont des pages complètement différentes avec le même contenu.

Les deux pages sont-elles nuisibles? Donc, si l'utilisateur ordinaire ne peut même pas remarquer la présence d'un double sur votre site, les moteurs de recherche détermineront immédiatement. Quelle réaction d'eux à attendre? Ainsi, en fait, les copies sont considérées comme des pages différentes, puis le contenu sur eux cesse d'être unique. Et cela affecte déjà négativement le classement.

En outre, la présence d'un DUB est bloquée, que l'optimiseur a essayé de se concentrer sur la page cible. En raison du double, il peut ne pas être du tout sur cette page qu'il voulait bouger. C'est-à-dire que l'effet des transparlements internes et des références externes peut être réduit de plusieurs reprises.

Dans la majorité écrasante de l'apparition du double, il est à blâmer - en raison des mauvais paramètres et que l'absence d'attention de l'optimiseur est générée des copies claires. Avec cela, de nombreux CM sont péchants, par exemple, Joomla. Pour résoudre le problème, il est difficile de choisir une recette universelle, mais vous pouvez essayer d'utiliser l'un des plug-ins pour supprimer des copies.

L'émergence de doubles flous, dans lesquelles le contenu n'est pas entièrement identique, se produit généralement en raison de la faute du webmaster. Ces pages se trouvent souvent sur les sites Web des magasins en ligne, où les pages avec des marchandises se caractérisent que de quelques phrases avec une description et le reste du contenu constitué de blocs via des blocs et d'autres éléments est identique.

De nombreux spécialistes font valoir qu'une petite quantité de doubles ne fera pas de mal à un site, mais si plus de 40 à 50% de plus de 40 à 50%, la ressource peut alors attendre de graves difficultés. En tout état de cause, même si les copies ne sont pas tellement, il est utile de faire avec leur élimination. Vous êtes donc garanti de vous débarrasser des problèmes avec les dubs.

Copie de la page de recherche Il existe plusieurs façons de rechercher des pages en double, mais vous devez d'abord contacter plusieurs moteurs de recherche et voir comment ils voient votre site - il vous suffit de comparer le nombre de pages dans l'index de chacun. C'est assez simple, sans recourir à aucun moyen supplémentaire: à Yandex ou à Google suffisamment dans la chaîne de recherche, entrez l'hôte: YourSite.ru et examinez le nombre de résultats.

Si, après une telle vérification simple, la quantité sera très différente, 10 à 20 fois, alors cela correspond à d'autres plus susceptibles de parler du contenu du DUB dans l'un d'eux. Les copies de la page ne peuvent pas être blâmées pour une telle différence, mais néanmoins, cela donne une raison de rechercher plus approfondie. Si le site est petit, vous pouvez calculer manuellement le nombre de pages réelles, puis comparer avec des indicateurs à partir de moteurs de recherche.

Rechercher des pages dupliquées Vous pouvez rechercher une URL dans l'émission du moteur de recherche. S'ils doivent être cnc, des pages avec une URL de caractères incompréhensibles, comme "index.php? S \u003d 0f6b2903d", seront immédiatement gênées de la liste générale.

Une autre façon de déterminer la présence d'un duplicata au moyen de moteurs de recherche est une recherche sur des fragments de texte. La procédure d'une telle inspection est simple: vous devez entrer un fragment de texte sur 10-15 mots de chaque page de la chaîne de recherche, puis analyser le résultat. S'il y aura deux pages ou plus d'extradition, il y en aura des copies, si le résultat n'est qu'un, il n'y a pas de double de cette page et vous ne pouvez pas vous inquiéter.

Il est logique que si le site consiste en un grand nombre de pages, une telle vérification peut devenir une routine irréalisable pour un optimiseur. Pour minimiser les coûts de temps, vous pouvez utiliser des programmes spéciaux. L'un de ces outils, qui est probablement un signe de spécialistes expérimentés, est la linge de Xenu.

Pour vérifier le site, vous devez ouvrir un nouveau projet en sélectionnant le menu "Fichier" "Vérifier l'URL", entrez l'adresse et cliquez sur "OK". Après cela, le programme commencera à traiter toute l'URL du site. À la fin du chèque, vous devez exporter les données reçues vers n'importe quel éditeur pratique et commencer à chercher un double.

Outre les méthodes ci-dessus dans les outils des panneaux Yandex.Vebaster et Google Webmaster Tools, il existe des moyens de vérifier les pages d'indexation pouvant être utilisées pour rechercher un double.

Méthodes de résolution du problème Une fois que toutes les duplicas sont trouvées, leur élimination sera nécessaire. Cela peut également être fait de plusieurs manières, mais pour chaque cas spécifique, vous avez besoin de votre propre méthode, il est possible que tout le monde ait à utiliser.

- Les pages de copie peuvent être supprimées manuellement, mais cette méthode ne convient plutôt que pour les doubles, qui ont été créées par voie manuelle à l'incohérence du webmaster.

- Redirection 301 est idéal pour les pages de collage - Copies dont l'URL est distinguée par la présence et l'absence de www.

- La résolution des problèmes avec des doubles utilisant la balise canonique peut être utilisée pour des copies floues. Par exemple, pour les catégories de marchandises dans la boutique en ligne, qui ont un duplicata, distinguée en triant dans divers paramètres. Canonical convient également aux versions de pages d'impression et dans d'autres cas similaires. Il est utilisé tout simplement - pour toutes les copies, l'attribut rel \u003d "canonique" est indiqué et pour la page principale la plus pertinente - non. Le code devrait ressembler à quelque chose comme ceci: link rel \u003d "canonique" href \u003d "http://yoursite.ru/stranica-kopiya" / et se tiennent dans l'étiquette de tête.

- Dans la lutte contre les doubles, peut aider à configurer le fichier robots.txt. La directive de l'interdiction vous permettra de fermer l'accès aux DUBS pour les robots de recherche. Vous pouvez en savoir plus sur la syntaxe de ce fichier dans notre envoi.

Les duplicas sont des pages du même domaine avec un contenu identique ou très similaire. Le plus souvent apparaissent en raison des caractéristiques du travail de CMS, des erreurs dans les directives Robots.txt ou dans la définition de 301 redirections.

Quel est le danger des doubles

1. Identification incorrecte de la page correspondante du robot de recherche. Supposons que vous ayez une et la même page disponible sur deux URL:

Https://site.ru/kepki/

Https://site.ru/catalog/kepki/

Vous avez investi de l'argent dans la promotion de la page https://site.ru/kepki/. Maintenant, il fait référence aux ressources thématiques et a classé les positions dans le top 10. Mais à un moment donné, le robot l'élimine de l'indice et en retour ajoute https://site.ru/catalog/kepki/. Naturellement, cette page est classée pire et attire moins de trafic.

2. Augmenter le temps requis pour traverser le site par des robots. Sur le balayage de chaque site, des robots ont attribué une durée limitée. Si beaucoup de doubles, le robot peut ne pas aller au contenu principal, car où l'indexation sera retardée. Ce problème est particulièrement pertinent pour les sites avec des milliers de pages.

3. L'imposition de sanctions de la part des moteurs de recherche. Par eux-mêmes, les Duplicas ne sont pas une raison pour la pessimisation du site - tant que les algorithmes de recherche ne comptent pas que vous créez une pâtisserie intentionnellement afin de manipuler l'émission.

4. Problèmes de webmasters. Si les travaux sur l'élimination des doubles à reporter dans une boîte longue, ils peuvent être accumulés par une telle quantité que le webmaster est purement physiquement, il sera difficile de traiter les rapports, systématisez les raisons des dubs et de faire des ajustements. Un grand travail augmente le risque d'erreurs.

Les dupils sont conventionnellement divisés en deux groupes: explicite et implicite.

Duplicas explicites (page disponible sur deux ou plusieurs URL)

Il existe de nombreuses options pour de tels doubles, mais elles sont toutes comme leur essence. Voici les plus courants.

1. URL avec une barre oblique à la fin et sans elle

Https://site.ru/list/

Https://site.ru/list.

Que faire: Configurer la réponse du serveur "HTTP 301 déplacé de manière permanente" (301e redirection).

Comment faire:

- recherchez dans le dossier racine du fichier de site.htaccess et ouvert (s'il n'y a pas - Créer au format TXT, appelez.htaccess et placez la racine du site);

- prescrire dans le fichier de fichiers pour rediriger avec l'URL avec une barre oblique sur l'URL sans barre oblique:

Réécritecond% (demande_filename)! -D

RewriteCond% (request_uri) ^ (. +) / $

Rewriterule ^ (. +) / $ / 1 $

- opération inverse:

RewriteCond% (demande_filename)! -F

RewriteCond% (request_uri)! (. *) / $

Réécritule ^ (. * [^ /]) $ 1 $ /

- si le fichier est créé à partir de zéro, toutes les redirections doivent être prescrites dans de telles lignes:

…

Configuration 301 Redirection avec .htaccess ne convient que pour les sites Apache. Pour NGinx et d'autres serveurs, Redirection est configuré d'une autre manière.

Quelle URL est préférée: avec ou sans chute? Pure techniquement - aucune différence. Regardez dans la situation: si plus de pages sont indexées avec une barre oblique, laissez cette option et inversement.

2. URL avec www et sans www

Https://www.site.ru/1.

Https://site.ru/1.

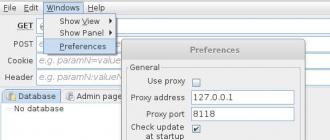

Que faire: Spécifiez le miroir principal du site dans le panneau WebMaster.

Comment faire cela à Yandex:

- aller à yandex.vebmaster

- sélectionnez le site dans le panneau à partir de laquelle la redirection ira (le plus souvent redirigé vers l'URL sans www);

- accédez à la section "Indexing / Déménagement du site", supprimez la case à l'avant de l'élément "Ajouter www" et enregistrez les modifications.

Dans les 1,5 à 2 semaines de Yandex, les miroirs refléteront les pages et seule l'URL sans www apparaîtra dans la recherche.

Important! Auparavant, pour spécifier le miroir principal du fichier robots.txt, il était nécessaire de prescrire une directive hôte. Mais ce n'est plus supporté. Certains webmasters "pour la sécurité" indiquent toujours la présente directive et pour une configuration encore plus grande 301 Redirection - Ceci n'est pas nécessaire, il suffit de régler le collage du webmaster.

Comment coller des miroirs dans Google:

- aller à Console de recherche Google. et ajoutez 2 versions du site - avec www et sans www;

- sélectionnez le site à partir duquel la redirection ira de la console de recherche;

- cliquez sur l'icône du matériel dans le coin supérieur droit, sélectionnez l'élément "Paramètres du site" et sélectionnez le domaine principal.

Comme dans le cas de Yandex, des manipulations supplémentaires avec 301 redirections ne sont pas nécessaires, bien qu'il soit possible de mettre en œuvre un collage avec celui-ci.

Qu'est-ce qui devrait être fait:

- décharger une liste d'URL indexées de Yandex.WebMaster;

- téléchargez cette liste dans l'outil de liste Seopult ou à l'aide du fichier XLS (instructions détaillées pour l'utilisation de l'outil);

- exécutez l'analyse et téléchargez le résultat.

Dans cet exemple, la page de phagination est indexée par Yandex et Google n'est pas. La raison en est qu'ils sont fermés de l'indexation dans robots.txt uniquement pour le bot Yandex. Solution - Configurez la canonisation pour les pages de pagination.

En utilisant l'analyseur de Seopult, vous comprendrez, des pages en double dans les deux moteurs de recherche ou uniquement dans une. Cela vous permettra de choisir des outils de résolution de problèmes optimaux.

Si vous n'avez pas de temps ou d'expérience pour traiter les doubles, commandez un audit - en plus de la présence d'un double, vous obtiendrez de nombreuses informations utiles sur votre ressource: la présence d'erreurs dans le code HTML, les titres, Meta Tags, structure, passage interne, convivialité, optimisation du contenu, etc. En conséquence, vous aurez des recommandations prêtes sur vos mains, ce qui rendra le site plus attrayant pour les visiteurs et augmentera sa position dans la recherche.